MÉTODOS DE ANÁLISIS MULTIVARIANTE: ANÁLISIS CLÚSTER

Objetivos

- Identificar grupos de objetos homogéneos.

- Determinar el criterio de similitud.

- Distinguir los Métodos de clasificación Jerárquicos y los Métodos de clasificación No-Jerárquicos o Repartición.

- Plantear y aplicar el Análisis Clúster Jerárquico.

- Distinguir los Métodos Jerárquicos Aglomerativos y los Métodos Jerárquicos Divisivos.

- Entender y aplicar el proceso algorítmico del Análisis Clúster Jerárquico Aglomerativo.

- Saber construir una matriz de distancias.

- Representar e Interpretar un dendograma.

- Plantear y aplicar el Análisis Clúster de K medias.

- Entender y aplicar el proceso algorítmico del Análisis Clúster de K medias.

- Plantear y aplicar el Análisis Clúster en dos etapas o bietápico.

Introducción al Análisis Clúster

El análisis clúster, también llamado análisis de conglomerados, es una técnica estadística multivariante que tiene por objeto formar grupos de individuos. Estos grupos reciben el nombre de clústers o conglomerados; de ahí el nombre de la técnica. Los individuos que conforman cada uno de los grupos que resultan de la aplicación de un análisis clúster son muy similares entre sí y, a la vez, muy diferentes a los individuos que conforman el resto de grupos.

- El objetivo del Análisis Clúster es formar grupos de objetos de manera que, por un lado, los objetos pertenecientes a un mismo grupo sean muy semejantes entre sí y, por otro lado, los objetos pertenecientes a grupos diferentes sean lo más heterogéneos posible entre sí

La formación de los grupos se realiza en función de la similitud o de la distancia que existe entre los individuos calculada a partir de un conjunto de variables numéricas. La obtención de dichos clústers depende del criterio o distancia considerados, por ejemplo, una baraja de carta española se podría dividir de distintas formas: en dos clústers (figuras y números), en cuatro clústers (los cuatro palos), en ocho clústers (los cuatro palos y según sean figuras o números). Es decir, el número de clústers depende de lo que consideremos como similar.

El análisis clúster es una tarea de clasificación. Por ejemplo

- Clasificar grupos de consumidores respecto a sus preferencias en nuevos productos

- Clasificar las entidades bancarias donde sería más rentable invertir

- Clasificar las estrellas del cosmos en función de su luminosidad

- Identificar si hay grupos de municipios en una determinada comunidad con una tendencia similar en el consumo de agua con el fin de identificar buenas prácticas para la sostenibilidad y zonas problemáticas por alto consumo.

El análisis Clúster es una técnica exploratoria puesto que para realizar el proceso de clasificación no utiliza ningún tipo de modelo estadístico.

Como se puede comprender fácilmente el análisis clúster tiene una extraordinaria importancia en la investigación científica, en cualquier rama del saber. La clasificación es uno de los objetivos fundamentales de la Ciencia y en la medida en que el análisis clúster nos proporciona los medios técnicos para realizarla, se nos hará imprescindible en cualquier investigación. Es muy importante que el analista tenga conocimientos del problema a analizar, ya que de otra forma el resultado del análisis de los datos se puede convertir en una disección de los mismos en vez de una clasificación representativa en conglomerados

Planteamiento del problema

Supongamos que partimos de una muestra \( X \) formada por n individuos y para cada uno de ellos se miden p variables, \( X_1,X_2, \cdots, X_p \) (p variables numéricas observadas en n objetos o individuos). Donde \( x_{ij} \) representa el valor de la la variable \( X_{j} \) para el i -ésimo individuo \( i= 1,2, \cdots, n \); \( j=1,2, \cdots, p \).

Toda la información recogida en la muestra puede resumirse en la siguiente matriz:

\( X = \left( \begin{matrix} x_{11} & x_{12} & \dots & x_{1j} & \dots & x_{1p} \\ x_{21} & x_{22} & \dots & x_{2j} & \dots & x_{2p} \\ \vdots & \vdots & \vdots & \vdots & \vdots & \vdots \\ x_{i1} & x_{i2} & \dots & x_{ij} & \dots & x_{ip} \\ \vdots & \vdots & \vdots & \vdots & \vdots & \vdots \\ x_{n1} & x_{n2} & \dots & x_{nj} & \dots & x_{np} \end{matrix} \right) \)

La i-ésima fila de la matriz X contiene los valores de cada variable para el i-ésimo individuo, mientras que la j-ésima columna muestra los valores pertenecientes a la j-ésima variable a lo largo de todos los individuos de la muestra. Es decir, donde cada fila recoge las observaciones para un individuo y cada columna recoge las observaciones para una variable.

Se trata, fundamentalmente, de resolver el siguiente problema: Dado un conjunto de n individuos caracterizados por la información de p variables \( X_{j} \), \( ( j=1,2, \cdots, p) \), nos planteamos clasificarlos de manera que los individuos pertenecientes a un grupo (clúster) (y siempre con respecto a la información disponible de las variables) sean lo más similares posibles entre sí y los distintos grupos sean entre ellos tan disimilares como sea posible.

El proceso completo puede estructurarse de acuerdo con el siguiente esquema:

-

Partimos de un conjunto de n individuos de los que se dispone de una información cifrada por un conjunto de p variables (una matriz de datos de n individuos y p variables).

-

Establecemos un criterio de similaridad y construimos una matriz de similaridades que nos permita relacionar la semejanza de los individuos entre sí. Para medir lo similares (o disimilares) que son los individuos existe una gran cantidad de índices de similaridad y de disimilaridad o divergencia. Todos ellos tienen propiedades y utilidades distintas y habrá que ser consciente de ellas para su correcta aplicación.

-

Elegimos un algoritmo de clasificación para determinar la estructura de agrupación de los individuos.

-

Especificamos esa estructura mediante diagramas arbóreos.

El análisis clúster: Técnica de agrupación de variables y de casos

-

Como técnica de agrupación de variables, el análisis clúster es similar al análisis factorial. Pero, mientras que el análisis factorial es poco flexible en algunos de sus supuestos (linealidad, normalidad, variables cuantitativas, etc.) y estima de la misma manera la matriz de distancias, el análisis clúster es menos restrictivo en sus supuestos (no exige linealidad, ni simetría, permite variables categóricas, etc.) y admite varios métodos de estimación de la matriz de distancias.

-

Como técnica de agrupación de casos, el análisis clúster es similar al análisis discriminante. Pero mientras que el análisis discriminante se centra en la agrupación de variables, es decir efectúa la clasificación tomando como referencia un criterio o variable dependiente (los grupos de clasificación), el análisis clúster se centra en agrupar objetos, es decir permite detectar el número óptimo de grupos y su composición únicamente a partir de la similaridad existente entre los casos; además, el análisis de clúster no asume ninguna distribución específica para las variables.

Inconvenientes del Análisis Clúster: Es un análisis descriptivo, a teórico y no inferencial. Habitualmente se utiliza como una técnica exploratoria que no ofrece soluciones únicas, las soluciones dependen de las variables consideradas y del método de análisis clúster utilizado.

Aplicabilidad: Las técnicas de análisis clúster han sido tradicionalmente utilizadas en muchas disciplinas, por ejemplo, Astronomía (Clúster = galaxia, súper galaxias, etc.), Marketing (segmentación de mercados, investigación de mercados), Psicología, Biología (Taxonomía. Microarrays), Ciencias Ambientales (Clasificación de ríos para establecer tipologías según la calidad de las aguas), Sociología, Economía, Ingeniería, ….

JAIN and DUBES (1988) definen el Análisis de Clúster como una herramienta de exploración de datos que se complementa con técnicas de visualización de los mismos.

Resumiendo

-

El objetivo del Análisis Clúster es obtener grupos de objetos de forma que, por un lado, los objetos pertenecientes a un mismo grupo sean muy semejantes entre sí y, por el otro, los objetos pertenecientes a grupos diferentes tengan un comportamiento distinto con respecto a las variables analizadas.

-

Es una técnica exploratoria puesto que la mayor parte de las veces no utiliza ningún tipo de modelo estadístico para llevar a cabo el proceso de clasificación.

-

Conviene estar siempre alerta ante el peligro de obtener, como resultado del análisis, no una clasificación de los datos sino una disección de los mismos en distintos grupos. El conocimiento que el analista tenga acerca del problema decidirá que grupos obtenidos son significativos y cuáles no.

-

Una vez establecidas las variables y los objetos a clasificar el siguiente paso consiste en establecer una medida de proximidad o de distancia entre ellos que cuantifique el grado de similaridad entre cada par de objetos.

- Las medidas de proximidad, similitud o semejanza miden el grado de semejanza entre dos objetos de forma que, cuanto mayor (menor) es su valor, mayor (menor) es el grado de similaridad existente entre ellos y mayor (menor) es la probabilidad de que los métodos de clasificación los asignen en el mismo grupo.

-

Las medidas de disimilitud, desemejanza o distancia miden la distancia entre dos objetos de forma que, cuanto mayor (menor) sea su valor, más (menos) diferentes son los objetos y menor (mayor) es la probabilidad de que los métodos de clasificación los asignen en el mismo grupo.

Técnicas de clasificación

Se distinguen dos grandes categorías de métodos clústers, dos procedimientos distintos para la clasificación de los individuos en grupos o, equivalentemente, para la formación de los grupos. En concreto: Procedimientos jerárquicos y Procedimientos no-jerárquicos

- Procedimientos Jerárquicos: En cada paso del algoritmo sólo un objeto cambia de grupo y los grupos están anidados en los de pasos anteriores. Si un objeto ha sido asignado a un grupo ya no cambia más de grupo. La clasificación resultante tiene un número creciente de clases anidadas.

- Procedimientos No jerárquico o Repartición: Comienzan con una solución inicial, un número de grupos g fijado de antemano y agrupa los objetos para obtener los g grupos.

Procedimientos jerárquicos

Son procedimientos iterativos en los que, en cada paso o iteración, se produce un único cambio en las agrupaciones motivado por la asignación de un individuo a un grupo. Una vez que un individuo es asignado a un grupo, se mantiene en el mismo grupo hasta el final de procedimiento.

Este procedimiento intenta identificar grupos relativamente homogéneos de casos basándose en las variables seleccionadas. Se utiliza cuando no se conoce el número de clusters a priori y cuando el número de objetos no es muy grande. Al trabajar con variables que pueden venir dadas en diferentes unidades de medida, el escalamiento de las variables es un aspecto importante, ya que las diferentes escalas en que están medidas las variables pueden afectar a las soluciones de conglomeración. Si las variables muestran grandes diferencias en el escalamiento (por ejemplo, una variable se mide en dólares y la otra se mide en años), se debe considerar la posibilidad de estandarizarlas.

Los métodos jerárquicos se subdividen a su vez en aglomerativos y divisivos (o disociativos):

- Los procedimientos jerárquicos aglomerativos parten de una situación inicial en la que hay tantos grupos como individuos componen la muestra. En cada paso, se fusionan los dos grupos más similares (o, equivalentemente, los dos grupos menos disimilares o menos distantes). A continuación, se vuelve a calcular el grado de similaridad entre grupos. El procedimiento termina con un único grupo formado por todos los individuos de la muestra. En este tipo de procedimientos, cuando dos grupos se fusionan permanecerán unidos hasta el final del proceso.

- Los procedimientos jerárquicos divisivos (o disociativos) parten de una situación inicial en la que hay un único grupo que incluye a todos los individuos de la muestra. En cada paso, se divide en dos al grupo más heterogéneo, esto es, el grupo cuyos elementos sean menos similares o estén más distantes. A continuación, se vuelve a calcular el grado de similaridad dentro de cada grupo. El procedimiento termina con tantos grupos (de un individuo cada uno) como individuos compongan la muestra.

Independientemente del proceso de agrupamiento, hay diversos criterios para ir formando los clústers; todos estos criterios se basan en una matriz de distancias o similitudes.

Algunos de los métodos jerárquicos aglomerativos más usados son:

- Método del enlace simple o del vecino más próximo. En este método se asume que la distancia o similitud entre dos grupos viene dada por la mínima distancia (o máxima similitud) entre sus individuos (entre sus individuos más cercanos).

- Método del enlace completo o del vecino más lejano. En este método se asume que la distancia o similitud entre dos grupos viene dada por la máxima distancia (o mínima similitud) entre sus individuos (entre sus individuos más lejanos).

- Método del promedio entre grupos. En este método se asume que la distancia o similitud entre dos grupos viene dada por la media de las distancias (o de las similitudes) entre los individuos de ambos grupos.

- Método del promedio ponderado entre grupos. Variación del método anterior, en el que cada individuo tiene un peso asignado.

- Método del centroide. Este método mide la proximidad entre grupos calculando la distancia entre sus centroides, teniendo en cuenta los tamaños de los grupos.

- Método de la mediana. Este método mide la proximidad entre grupos calculando la distancia entre sus centroides, teniendo en cuenta los tamaños de los grupos. Este método mide la proximidad entre grupos calculando la distancia entre sus centroides, sin tener en cuenta los tamaños de los grupos.

- Método de Ward. Este método se unen grupos de manera que se minimiza la varianza dentro cada uno de ellos, por lo que se maximiza la homogeneidad dentro de cada grupo.

Jerárquicos aglomerativos:

- Método del Linkage Simple, Enlace Simple o Vecino más próximo

- Método del Linkage Completo, Enlace Completo o Vecino más alejado

- Método del Promedio entre grupos

- Método del Centroide

- Método del la Mediana

- Método de Ward

Jerárquicos divisivos o disociativos

- Método del Linkage Simple

- Método del Linkage Completo

- Método del Promedio entre grupos

- Método del Centroide

- Método del la Mediana

- Análisis de Asociación

Procedimientos no jerárquicos (o de partición o reparto)

Este tipo de procedimientos parten de una solución inicial con un número de clústers determinado de antemano, (requiere conocer el número de clústers a priori) y se agrupan los objetos para obtener esos grupos. Es decir, se elige una partición de los individuos conformada por un número de grupos determinado y se van intercambiando los individuos entre grupos para obtener una partición mejor, entendida como aquella con mayor similitud (o menor distancia) entre los miembros de los grupos. El clúster no jerárquico sólo puede ser aplicado a variables cuantitativas.

El método de análisis clúster no jerárquico más utilizado es el de las k-medias.

Análisis de conglomerados de K medias

En el análisis clúster de k-medias se asignan los individuos a un número fijo de grupos, en base a los valores de un conjunto de variables que deben ser cuantitativas. Cada individuo debe pertenecer a un grupo y solo a uno. Esta técnica es especialmente útil cuando se quiere clasificar un gran número de casos. De forma general, este método se basa en el siguiente algoritmo:

- Fijar, aleatoriamente, los centroides de los k clústers (k debe ser fijado de antemano).

- Asignar cada unidad a un clúster, en base a un determinado criterio.

- Recalcular los centroides de los clústers.

Los pasos 2 y 3 se repiten iterativamente hasta que se satisface un criterio de parada como, por ejemplo, que no se produzca ninguna reasignación, es decir, que los clústers obtenidos en dos iteraciones consecutivas sean los mismos.

En este método, la medida de distancia o de similaridad entre los casos se calcula utilizando la distancia euclídea. Es muy importante el tipo de escala de las variables, si las variables tienen diferentes escalas (por ejemplo, una variable se expresa en dólares y otra en años), los resultados podrían ser equívocos. En estos casos, se debería considerar la estandarización de las variables antes de realizar el análisis de conglomerados de k-medias.

Este procedimiento supone que se ha seleccionado el número apropiado de conglomerados y que se han incluido todas las variables relevantes. Si se ha seleccionado un número inapropiado de conglomerados o se han omitido variables relevantes, los resultados podrían ser equívocos.

El método suele ser muy sensible a la solución inicial dada por lo que es conveniente utilizar una que sea buena o probar con varias soluciones iniciales. Una forma de construir una solución inicial apropiada es mediante una clasificación obtenida por un algoritmo jerárquico.

Proceso que se debe seguir en un análisis clúster

Paso 1: Selección de variables

De forma previa a la aplicación de la técnica en sí hay que prestar atención a las variables que se van a considerar para la formación de los clústers. Hay que asegurarse, por ejemplo, de seleccionar exclusivamente aquellas variables que realmente caracterizan a los individuos que se van a agrupar y que pueden tener relevancia a la hora de la formación de los clústers.

La clasificación dependerá de las variables elegidas. Introducir variables irrelevantes aumenta la posibilidad de errores. También hay que tener en cuenta el número de variables.

- Seleccionar sólo aquellas variables que caracterizan los objetos que se van agrupando, y referentes a los objetivos del análisis clúster que se va a realizar

- Si el número de variables es muy grande es aconsejable realizar previamente un Análisis de Componentes Principales para reducir la dimensionalidad y resumir la información del conjunto de variables.

Paso 2: Detección y eliminación de valores atípicos.

El análisis clúster es muy sensible a la presencia de individuos con características muy diferentes a las del grueso del grupo. En general, estos individuos tienden a ser asignados a un grupo exclusivo que no comparten con ningún otro individuo, lo cual dificulta la interpretación de los resultados.

Paso 3. Selección del método para determinar la distancia o disimilitud entre individuos dependiendo de si los datos con cuantitativos o cualitativos

- Datos métricos: Para datos de naturaleza cuantitativa, se suelen emplear métodos basados en la correlación así como medidas de distancia. Medidas de correlación y medidas de distancia

- Datos no métricos: Si los datos son cualitativos, se utilizan técnicas basadas en la asociación. Medidas de asociación.

Paso 4: Decisión sobre la estandarización de los datos.

Si las variables a partir de las cuales se van a formar los grupos vienen dadas en unidades de medida muy dispares o si la magnitud de sus valores es muy dispar, se recomienda la estandarización de los datos antes de llevar a cabo el análisis clúster. Hay que tener en cuenta que el orden de las similitudes puede variar bastante con tan solo un cambio de escala en una de las variables, por lo que la tipificación solo se realizará cuando resulte necesaria.

Paso 5: Aplicación de la técnica e interpretación de los resultados.

Por último, se aplica el análisis clúster. Para ello, se ha de elegir el procedimiento que se va a emplear así como el número de clústers con el que nos quedaremos.

- El procedimiento que se va a emplear (jerárquicos o no jerárquicos)

- Número de clústers: Regla de parada. Existen diversos métodos de determinación del número de clústers, algunos están basados en reconstruir la matriz de distancias original, otros en los coeficientes de concordancia de Kendall y otros realizan análisis de la varianza entre los grupos obtenidos. Aunque no existe un criterio universalmente aceptado para determinar el número final de clústers, se suele hacer en función de las distancias de formación de los grupos, localizando en qué iteraciones del método utilizado dichas distancias dan grandes saltos

- Adecuación del modelo. Comprobar que el modelo no ha definido clúster con un solo objeto, clúster con tamaños desiguales,…

Análisis clúster en R

Con el programa R, podemos realizar un número casi ilimitado de tipos de análisis clúster.

En esta práctica vamos a estudiar tres tipos de métodos de análisis clúster:

- Análisis de conglomerados de bietápico

- Análisis de conglomerados de K medias

- Análisis de conglomerados jerárquicos.

Análisis de conglomerados de bietápico

El clúster en dos etapas está pensado para minería de datos, es decir para estudios con un número de individuos grande que pueden tener problemas de clasificación con los otros procedimientos. Se puede utilizar tanto cuando el número de clúster es conocido a priori y cuando es desconocido. Permite trabajar conjuntamente con variables de tipo mixto (cualitativas y cuantitativas).

Análisis de conglomerados de K medias

Es un método de clasificación No Jerárquico (Repartición). El número de clusters que se van a formar es fijado de antemano (requiere conocer el número de clústers a priori) y se agrupan los objetos para obtener esos grupos. Comienzan con una solución inicial y los objetos se reagrupan de acuerdo con algún criterio de optimalidad. El clúster no jerárquico sólo puede ser aplicado a variables cuantitativas. Este procedimiento puede analizar archivos de datos grandes.

Análisis de conglomerados jerárquicos

En el método de clasificación Jerárquico en cada paso del algoritmo sólo un objeto cambia de grupo y los grupos están anidados en los pasos anteriores. Si un objeto ha sido asignado a un grupo ya no cambia más de grupo. El método jerárquico es idóneo para determinar el número óptimo de conglomerados existente en los datos y el contenido de los mismos. Se utiliza cuando no se conoce el número de clusters a priori y cuando el número de objetos no es muy grande. Permite trabajar conjuntamente con variables de tipo mixto (cualitativas y cuantitativas). Siempre que todas las variables sean del mismo tipo, el procedimiento Análisis de Conglomerados Jerárquico podrá analizar variables de intervalo (continuas), de recuento o binarias.

Los tres métodos de análisis que vamos a estudiar son de tipo aglomerativo, en el sentido de que, partiendo del análisis de los casos individuales, intentan ir agrupando casos hasta llegar a la formación de grupos o conglomerados homogéneos.

Todos los métodos de análisis clúster son métodos exploratorios de datos

- Para cada conjunto de datos podemos tener diferentes agrupaciones, dependiendo del método

- Lo importante es identificar una solución que nos enseñe cosas relevantes de los datos.

En esta práctica estudiamos primero el Análisis clúster Jerárquico, seguido del Análisis Clúster de K medias y por último el Análisis Clúster en dos etapas.

Antes de comenzar a realizar un análisis clúster, primero explicaremos qué paquetes vamos a utilizar a lo largo de la práctica.

- Paquete “MVA”. Este paquete incorpora la función hclust, la más importante función para el análisis cluster.

- Paquete “foreign”. Este paquete sirve para leer datos .sav, datos con formato tipo SPSS.

- Paquete “vegan”. Este paquete amplia el paquete MVA permitiendo calcular otros tipos de matrices de distancias.

Vamos a proceder a instalarlos todos.

> install.packages(“foreign”)

> install.packages(“MVA”)

> install.packages(“vegan”)

Vamos a cargarlos todos en la librería.

> library(“foreign”)

> library(“MVA”)

> library(“vegan”)

Análisis clúster jerárquico

Este procedimiento intenta identificar grupos relativamente homogéneos de casos (o de variables) basándose en las características seleccionadas. Permite trabajar conjuntamente con variables de tipo mixto (cualitativas y cuantitativas), siendo posible analizar las variables brutas o elegir de entre una variedad de transformaciones de estandarización. Se utiliza cuando no se conoce el número de clústers a priori y cuando el número de objetos no es muy grande. Como hemos dicho anteriormente, los objetos de análisis de agrupamiento jerárquico pueden ser casos o variables, dependiendo de si desea clasificar los casos o examinar las relaciones entre las variables.

Al trabajar con variables que pueden ser cuantitativas, binarias o datos de recuento (frecuencias), el escalamiento de las variables es un aspecto importante, ya que las diferentes escalas en que están medidas las variables pueden afectar a las soluciones de conglomeración. Si las variables muestran grandes diferencias en el escalamiento (por ejemplo, una variable se mide en dólares y la otra se mide en años), se debe considerar la posibilidad de estandarizarlas. Esto puede llevarse a cabo automáticamente mediante el propio procedimiento Análisis de conglomerados jerárquico.

Estudiaremos fundamentalmente los Métodos Jerárquicos Aglomerativos. En estos métodos se utilizan diversos criterios para determinar, en cada paso del algoritmo, qué grupos se deben unir.

- Enlace simple o vecino más próximo: Mide la proximidad entre dos grupos calculando la distancia entre sus objetos más próximos o la similitud entre sus objetos más semejantes

- Enlace completo o vecino más alejado: Mide la proximidad entre dos grupos calculando la distancia entre sus objetos más lejanos o la similitud entre sus objetos menos semejantes

- Enlace medio entre grupos: Mide la proximidad entre dos grupos calculando la media de las distancias entre objetos de ambos grupos o la media de las similitudes entre objetos de ambos grupos

- Enlace medio dentro de los grupos: Mide la proximidad entre dos grupos con la distancia media existente entre los miembros del grupo unión de los dos grupos

- Métodos del centroide y de la mediana: Ambos métodos miden la proximidad entre dos grupos calculando la distancia entre sus centroides. Los dos métodos difieren en la forma de calcular los centroides: Método de Ward

- El método del centroide utiliza las medias de todas las variables

- En el método de la mediana, el nuevo centroide es la media de los centroides de los grupos que se unen

Comparación de los diversos métodos aglomerativos

- El enlace simple conduce a clústers encadenados

- El enlace completo conduce a clústers compactos

- El enlace completo es menos sensible a outliers que el enlace simple

- El método de Ward y el método del enlace medio son los menos sensibles a outliers

- El método de Ward tiene tendencia a formar clústers más compactos y de igual tamaño y forma en comparación con el enlace medio

- Todos los métodos salvo el método del centroide satisfacen la desigualdad ultramétrica

\( d_{ut} \leq min (d_{ur}, d_{us} ) \hspace {.2cm}; \hspace{.2cm}t =r \cup s \)

Decisiones que hay que tomar para hacer un clúster

- Elegir el método clúster que se va a utilizar

- Decidir si se estandarizan los datos

- Seleccionar la forma de medir la distancia/disimilitud entre los individuos

- Elegir un criterio para unir grupos, distancia entre grupos.

Proceso que se debe seguir en un Análisis Clúster Jerárquico Aglomerativo

Paso 1: Selección de las variables. Se recomienda que las variables sean del mismo tipo (continuas, categóricas,..)

Paso 2: Detección de valores atípicos. El análisis clúster es muy sensible a la presencia de objetos muy diferentes del resto (valores atípicos).

Paso 3: Elección de una medida de similitud entre objetos y obtención de la matriz de distancias. Mediante estas medidas se determinan los clusters iniciales.

Paso 4: Buscar los clústers más similares

Paso 5: Unir estos dos clústers en un nuevo clúster que tenga al menos dos objetos, de forma que el número de clúster decrece en una unidad.

Paso 6: Calcular la distancia entre este clúster y el resto. Los distintos métodos para el cálculo de las distancias entre los clústers producen distintas agrupaciones, por lo que no existe una agrupación única.

Paso 7: Repetir desde el paso 4 hasta que todos los objetos estén en un único clúster.

El proceso de agrupación jerárquico se puede resumir gráficamente mediante una representación gráfica en forma de árbol que recibe el nombre de Dendograma. Los objetos similares se enlazan y su posición en el diagrama está determinada por el nivel de similitud/disimilitud entre los objetos.

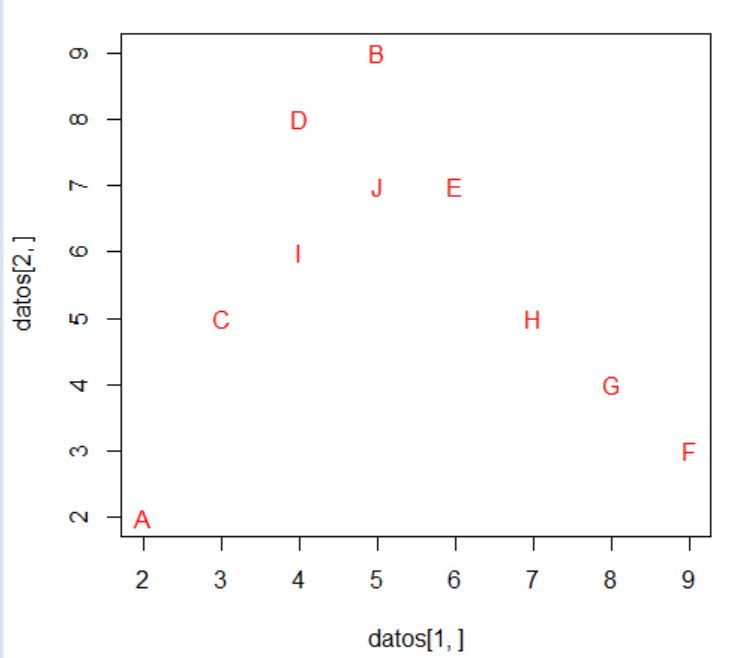

Vamos a realizar el proceso descrito y para ello utilizamos un ejemplo sencillo. Dicho ejemplo está formado por 5 objetos (A, B, C, D, E) y 2 variables \( (X_1, X_2 ) \). Los datos se presentan en la siguiente tabla

\( \begin{array} {|c|c|c|} \hline Objetos/individuos & X_1 & X_2 \\ \hline A & 1 & 1 \\ \hline B & 2 & 1 \\ \hline C & 4 & 5 \\ \hline D & 7 & 7 \\ \hline E & 5 & 7 \\ \hline \end{array} \)

Paso 1 y 2: Para detectar valores atípicos podemos representar los puntos en el plano

En este caso no detectamos valores atípicos, no hay ningún valor que sea muy distinto de los demás.

Paso 3: La medida de distancia que vamos a tomar entre los objetos va a ser la distancia euclídea cuya expresión es:

\( d(P_1, P_2) = \displaystyle \sqrt {(x_2-x_1)^{2} + (y_2-y_1)^{2} } \)

Así, por ejemplo, la distancia entre el clúster A y el clúster B es:

\( d(A, B) = \displaystyle \sqrt {(2-1)^{2} + (1-1)^{2}} = 1 \)

Realizamos la distancia euclídea entre todos los puntos y obtenemos la siguiente matriz de distancias euclídeas entre los objetos

\( \begin{array} {|c|c|c|c|c|c|} \hline & A & B & C & D & E \\ \hline A & 0 & & & & \\ \hline B & 1 & 0 & & & \\ \hline C & 5 & 4.5 & 0 & & \\ \hline D & 8.5 & 7.8 & 3.6 & 0 & \\ \hline E & 7.2 & 6.7 & 2.2 & 2 & 0 \\ \hline \end{array} \)

Nota: Estamos realizando el método jerárquico aglomerativo, por lo que inicialmente tenemos 5 clústers, uno por cada uno de los objetos a clasificar.

Paso 4: Observamos en la matriz de distancias cuales son los objetos más similares, en nuestro ejemplo son el A y B que tienen la distancia menor (1).

Paso 5: Fusionamos los clusters más similares construyendo un nuevo clúster que contiene A y B. Se han formado los clusters: AB, C, D y E.

Paso 6: Calculamos la distancia entre el clúster AB y los objetos C, D y E. Para medir esta distancia tomamos como representante del clúster AB el centroide, es decir, el punto que tiene como coordenadas las medias de los valores de las componentes de las variables, es decir, las coordenadas de AB son: ((1+2)/2 , (1+1)/2) = (1.5, 1). La tabla de datos es la siguiente

\( \begin{array} {|c|c|c|} \hline Cluster & X_1 & X_2 \\ \hline AB & 1.5 & 1 \\ \hline C & 4 & 5 \\ \hline D & 7 & 7 \\ \hline E & 5 & 7 \\ \hline \end{array} \)

Paso 7: Repetimos desde el paso 4 hasta que todos los objetos estén en un único clúster

Paso 4: A partir de estos datos calculamos de nuevo la matriz de distancias

\( \begin{array} {|c|c|c|c|c|} \hline & AB & C & D & E \\ \hline AB & 0 & & & \\ \hline C & 4.7 & 0 & & \\ \hline D & 8.1 & 3.6 & 0 & \\ \hline E & 6.9 & 2.2 & 2 & 0 \\ \hline \end{array} \)

Paso 5: Los clusters más similares son el D y E con una distancia de 2, que se fusionan en un nuevo clúster DE. Se han formado tres clusters AB, C, DE

Paso 6: Calculamos el centroide del nuevo clúster que es el punto (6,7) y formamos de nuevo la tabla de datos

\( \begin{array} {|c|c|c|} \hline Cluster & X_1 & X_2 \\ \hline AB & 1.5 & 1 \\ \hline C & 4 & 5 \\ \hline DE & 6 & 7 \\ \hline \end{array} \)

Paso 4: A partir de estos datos calculamos de nuevo la matriz de distancias

\( \begin{array} {|c|c|c|c|} \hline & AB & C & DE \\ \hline AB & 0 & & \\ \hline C & 4.7 & 0 & \\ \hline DE & 7.5 & 2.8 & 0 \\ \hline \end{array} \)

Paso 5: Los clusters más similares son el C y DE con una distancia de 2.8, que se fusionan en un nuevo clúster CDE. Se han formado dos clusters AB y CDE

Paso 6. Calculamos el centroide del nuevo clúster ((4+5+7)/3 , (5+7+7)/3) = (5.3, 6.3) y formamos de nuevo la tabla de datos

\( \begin{array} {|c|c|c|} \hline Cluster & X_1 & X_2 \\ \hline AB & 1.5 & 1 \\ \hline CDE & 5.3 & 6.3 \\ \hline \end{array} \)

Paso 4 : A partir de estos datos calculamos de nuevo la matriz de distancias

\( \begin{array} {|c|c|c|} \hline & AB & CDE \\ \hline AB & 0 & \\ \hline CDE & 6.4 & 0 \\ \hline \end{array} \)

En este último paso tenemos solamente dos clusters con distancia 6.4 que se fusionarán en un único clúster en el paso siguiente terminando el proceso.

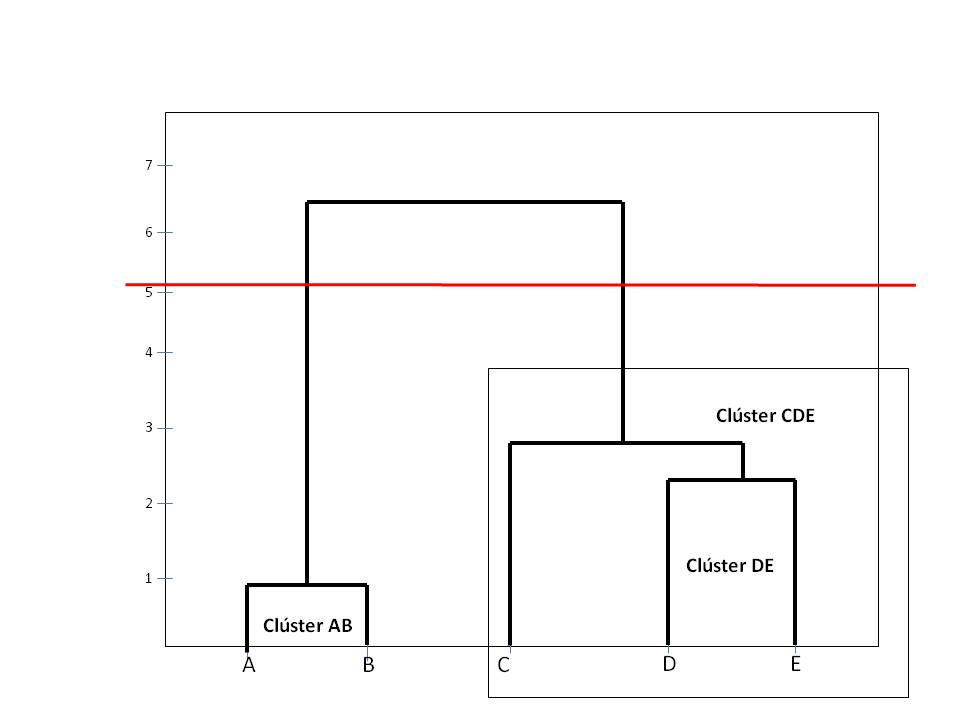

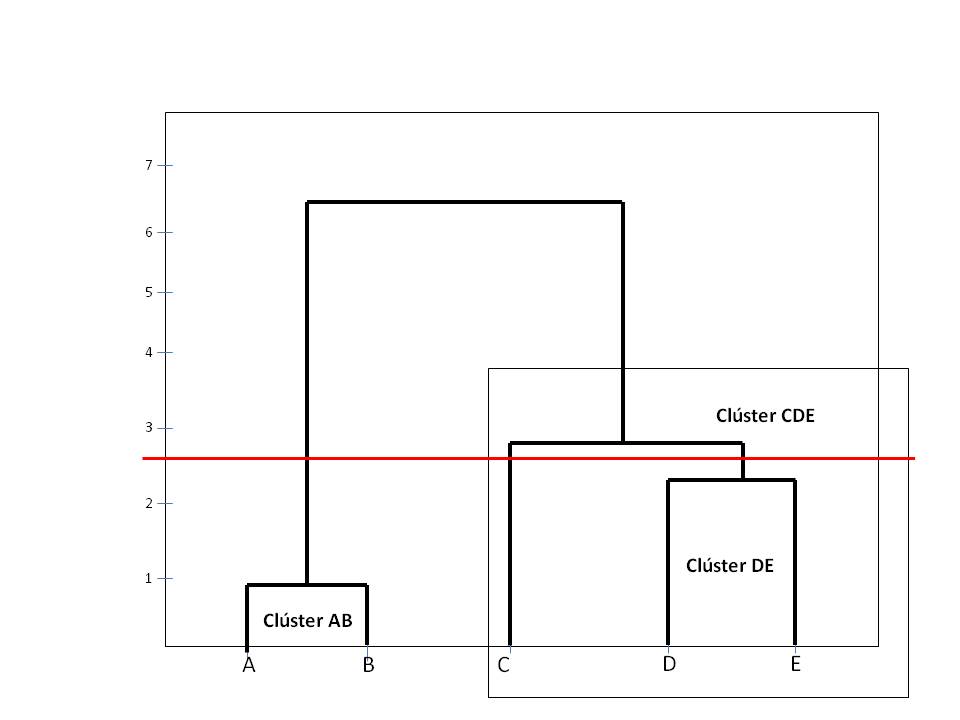

A continuación vamos a representar gráficamente el proceso de fusión mediante un dendograma

A continuación mostramos varias soluciones, para ello cortamos el dendograma por medio de líneas horizontales, así por ejemplo

En la figura anterior se muestran 2 clústers: AB y CDE

En esta figura la línea de corte nos muestra 3 clústers: AB, C y DE

El número de clústers depende del sitio donde cortemos el dendograma, por lo tanto la decisión sobre el número óptimo de clústers es subjetiva. Es conveniente elegir un número de clústers que sepamos interpretar. Para interpretar los clúster podemos utilizar:

- ANOVA

- Análisis factorial

- Análisis discriminante

- …

- Sentido común

Para decidir el número de clústers nos puede ser de gran utilidad representar los distintos pasos del algoritmo y las distancias a la que se produce la fusión de los clústers. En los primeros pasos el salto de las distancias es pequeño, mientras que esas diferencias van aumentando en los sucesivos pasos. Podemos elegir como punto de corte aquel donde comienzan a producirse saltos más bruscos. En nuestro ejemplo, el salto brusco se produce entre etapas 3 y 4, por lo tanto son dos el número de clústers óptimo.

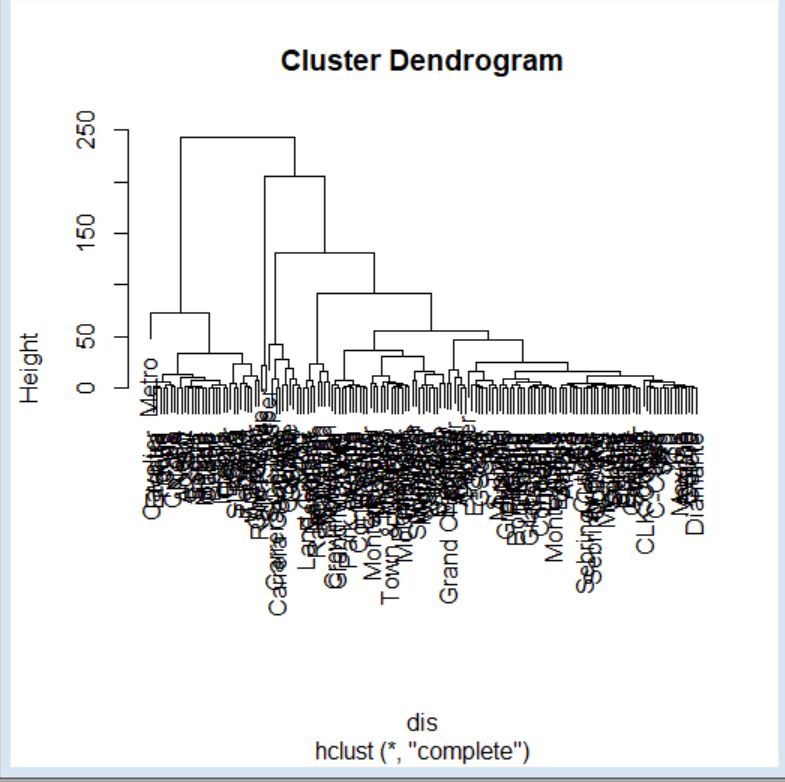

Comentarios sobre el clúster jerárquico

-

Realizar el clúster jerárquico en conjunto de datos grande es problemático ya que un árbol con más de 50 individuos es difícil de representar e interpretar.

-

Una desventaja general es la imposibilidad de reasignar los individuos a los clústers en los casos en que la clasificación haya sido dudosa en las primeras etapas del análisis.

-

Debido a que el análisis clúster implica la elección entre diferentes medidas y procedimientos, con frecuencia es difícil juzgar la veracidad de los resultados.

-

Se recomienda comparar los resultados con diferentes métodos de conglomerados. Soluciones similares generalmente indican la existencia de una estructura en los datos. Soluciones muy diferentes probablemente indican una estructura pobre.

-

En último caso, la validez de los clústers se juzga mediante una interpretación cualitativa que puede ser subjetiva.

-

El número de clústers depende del sitio donde cortemos el dendograma.

Supuesto práctico 1

Los fabricantes de automóviles deben adaptar sus estrategias de desarrollo de productos y de marketing en función de cada grupo de consumidores para aumentar las ventas y el nivel de fidelidad a la marca. La tarea de agrupación de los coches según variables que describen los hábitos de consumo, sexo, edad, nivel de ingresos, etc. de los clientes puede ser en gran medida automática utilizando el análisis de clúster.

Se desea hacer un estudio de mercado sobre las preferencias de los consumidores al adquirir un vehículo, para ello disponemos una base de datos, ventas_vehículos.sav de automóviles y camiones en los que figura una serie de variables como el fabricante, modelo, ventas, etc.

El archivo de datos contiene 157 datos y está formado por las siguientes variables:

Variables tipo cadena: marca (Fabricante); modelo

Variables tipo numérico: ventas (en miles); reventa (Valor de reventa en 4 años); tipo (Tipo de vehículo: Valores: {0, Automóvil; 1, Camión}); precio (en miles); motor (Tamaño del motor); CV (Caballos); pisada (Base de neumáticos); ancho (Anchura); largo (Longitud); peso_neto (Peso neto); depósito (Capacidad de combustible); mpg (Consumo).

Para cargar los datos utilizamos la función read.table indicando el nombre del archivo (que debe de estar en el directorio de trabajo) e indicando además que tiene cabecera.

Nota: La ruta hasta llegar al fichero varía en función del ordenador. Utilizar la orden setwd() para situarse en el directorio de trabajo

> setwd(“C:/Users/Usuario/Desktop/Datos”)

Mediante la función read.spss leemos los datos que están en un archivo .sav. Para poder utilizar esta función debemos instalar el paquete foreign.

Para ello, seleccionar Paquetes/Instalar paquetes y de la lista escoger foreign. O bien utilizar la siguiente orden

> install.packages(“foreign”)

A continuación debemos cargar el paquete, para ello se seleccionan Paquetes/cargar paquete y de la lista escoger foreign. O bien utilizar la siguiente orden

> library(foreign)

> datos<- read.spss(“ventas-vehiculos.sav”,use.value.labels=TRUE, max.value.labels=TRUE, to.data.frame=TRUE, sep)

re-encoding from CP1252

> datos

marca modelo ventas reventa tipo precio motor CV pisada ancho largo peso_neto deposito mpg

1 Acura Integra 16.919 16.360 0 21.500 1.8 140 101.2 67.3 172.4 2.639 13.2 28.0

2 Acura TL 39.384 19.875 0 28.400 3.2 225 108.1 70.3 192.9 3.517 17.2 25.0

3 Acura CL 14.114 18.225 0 NA 3.2 225 106.9 70.6 192.0 3.470 17.2 26.0

4 Acura RL 8.588 29.725 0 42.000 3.5 210 114.6 71.4 196.6 3.850 18.0 22.0

5 Audi A4 20.397 22.255 0 23.990 1.8 150 102.6 68.2 178.0 2.998 16.4 27.0

6 Audi A6 18.780 23.555 0 33.950 2.8 200 108.7 76.1 192.0 3.561 18.5 22.0

7 Audi A8 1.380 39.000 0 62.000 4.2 310 113.0 74.0 198.2 3.902 23.7 21.0

8 BMW 323i 19.747 NA 0 26.990 2.5 170 107.3 68.4 176.0 3.179 16.6 26.1

9 BMW 328i 9.231 28.675 0 33.400 2.8 193 107.3 68.5 176.0 3.197 16.6 24.0

10 BMW 528i 17.527 36.125 0 38.900 2.8 193 111.4 70.9 188.0 3.472 18.5 24.8

11 Buick Century 91.561 12.475 0 21.975 3.1 175 109.0 72.7 194.6 3.368 17.5 25.0

12

Nota: La función read.spss se utiliza para leer archivos .sav. Los otros dos argumentos son para darle formato de data frame.

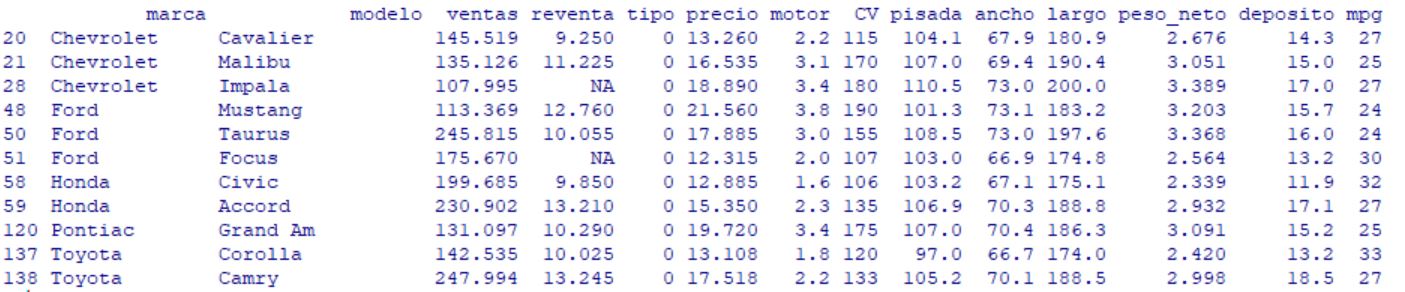

El estudio de mercado lo queremos realizar sólo en automóviles de mayor venta y para ello vamos a utilizar el procedimiento Análisis de conglomerados jerárquico para agrupar los automóviles de mayor venta en función de sus precios, fabricante, modelo y propiedades físicas.

En primer lugar restringiremos el archivo de datos sólo a los automóviles de los que se vendieron al menos 100.000 unidades. Para ello seleccionamos los casos que cumplan esa condición mediante la siguiente fórmula:

>datos100k <- subset(datos, subset =datos$ventas>100 & datos$tipo==0)

La función subset filtramos los datos, poniendo las condiciones de selección en el segundo argumento.

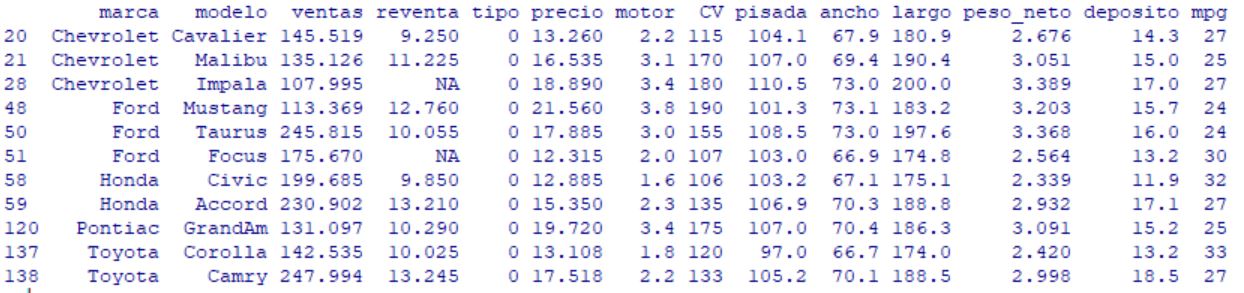

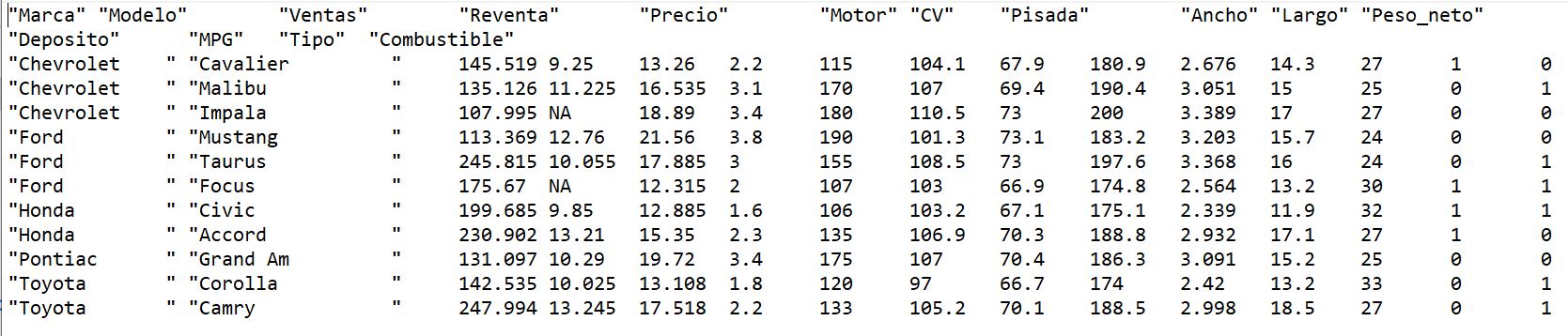

> datos100k

marca modelo ventas reventa tipo precio motor CV pisada ancho largo peso_neto deposito mpg

20 Chevrolet Cavalier 145.519 9.250 0 13.260 2.2 115 104.1 67.9 180.9 2.676 14.3 27

21 Chevrolet Malibu 135.126 11.225 0 16.535 3.1 170 107.0 69.4 190.4 3.051 15.0 25

28 Chevrolet Impala 107.995 NA 0 18.890 3.4 180 110.5 73.0 200.0 3.389 17.0 27

48 Ford Mustang 113.369 12.760 0 21.560 3.8 190 101.3 73.1 183.2 3.203 15.7 24

50 Ford Taurus 245.815 10.055 0 17.885 3.0 155 108.5 73.0 197.6 3.368 16.0 24

51 Ford Focus 175.670 NA 0 12.315 2.0 107 103.0 66.9 174.8 2.564 13.2 30

58 Honda Civic 199.685 9.850 0 12.885 1.6 106 103.2 67.1 175.1 2.339 11.9 32

59 Honda Accord 230.902 13.210 0 15.350 2.3 135 106.9 70.3 188.8 2.932 17.1 27

120 Pontiac Grand Am 131.097 10.290 0 19.720 3.4 175 107.0 70.4 186.3 3.091 15.2 25

137 Toyota Corolla 142.535 10.025 0 13.108 1.8 120 97.0 66.7 174.0 2.420 13.2 33

138 Toyota Camry 247.994 13.245 0 17.518 2.2 133 105.2 70.1 188.5 2.998 18.5 27

Al leer los datos vemos que se han colado una serie de espacios en las variables “marca” y “modelo”. Para corregirlo utilizamos la función gsub, que funciona sustituyendo lo que pongas en el primer argumento por lo que pones en el segundo. En este caso un espacio por nada.

> datos100k$marca= gsub(” “,””,datos100k$marca)

> datos100k$modelo= gsub(” “,””,datos100k$modelo)

Mostramos la matriz de datos correcta

> datos100k

marca modelo ventas reventa tipo precio motor CV pisada ancho largo peso_neto deposito mpg

20 Chevrolet Cavalier 145.519 9.250 0 13.260 2.2 115 104.1 67.9 180.9 2.676 14.3 27

21 Chevrolet Malibu 135.126 11.225 0 16.535 3.1 170 107.0 69.4 190.4 3.051 15.0 25

28 Chevrolet Impala 107.995 NA 0 18.890 3.4 180 110.5 73.0 200.0 3.389 17.0 27

48 Ford Mustang 113.369 12.760 0 21.560 3.8 190 101.3 73.1 183.2 3.203 15.7 24

50 Ford Taurus 245.815 10.055 0 17.885 3.0 155 108.5 73.0 197.6 3.368 16.0 24

51 Ford Focus 175.670 NA 0 12.315 2.0 107 103.0 66.9 174.8 2.564 13.2 30

58 Honda Civic 199.685 9.850 0 12.885 1.6 106 103.2 67.1 175.1 2.339 11.9 32

59 Honda Accord 230.902 13.210 0 15.350 2.3 135 106.9 70.3 188.8 2.932 17.1 27

120 Pontiac GrandAm 131.097 10.290 0 19.720 3.4 175 107.0 70.4 186.3 3.091 15.2 25

137 Toyota Corolla 142.535 10.025 0 13.108 1.8 120 97.0 66.7 174.0 2.420 13.2 33

138 Toyota Camry 247.994 13.245 0 17.518 2.2 133 105.2 70.1 188.5 2.998 18.5 27

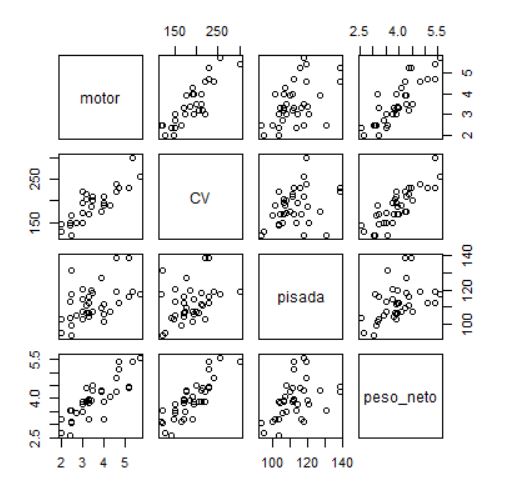

A continuación vamos a elegir las variables para hacer el análisis clúster.

Variables: precio (en miles); motor (Tamaño del motor); CV (Caballos); pisada (Base de neumáticos); ancho (Anchura); largo (Longitud); peso_neto (Peso neto); depósito (Capacidad de combustible); mpg (Consumo).

> x <- datos100k[,c(“precio”,”motor”,”CV”,”pisada”,”ancho”,”largo”,”peso_neto”,”deposito”,”mpg” )]

> x

precio motor CV pisada ancho largo peso_neto deposito mpg

20 13.260 2.2 115 104.1 67.9 180.9 2.676 14.3 27

21 16.535 3.1 170 107.0 69.4 190.4 3.051 15.0 25

28 18.890 3.4 180 110.5 73.0 200.0 3.389 17.0 27

48 21.560 3.8 190 101.3 73.1 183.2 3.203 15.7 24

50 17.885 3.0 155 108.5 73.0 197.6 3.368 16.0 24

51 12.315 2.0 107 103.0 66.9 174.8 2.564 13.2 30

58 12.885 1.6 106 103.2 67.1 175.1 2.339 11.9 32

59 15.350 2.3 135 106.9 70.3 188.8 2.932 17.1 27

120 19.720 3.4 175 107.0 70.4 186.3 3.091 15.2 25

137 13.108 1.8 120 97.0 66.7 174.0 2.420 13.2 33

138 17.518 2.2 133 105.2 70.1 188.5 2.998 18.5 27

Como las variables se miden en unidades diferentes vamos a normalizar la variable con Media 0 y Varianza 1. Para ello usamos la función scale. Elegimos True tanto para centrar como para escalar. También renombramos a las filas como el nombre de sus modelos.

> X.scale<- scale(x, center = T, scale = T)

> row.names(X.scale)<- datos100k$modelo

> round(X.scale,3)

precio motor CV pisada ancho largo peso_neto deposito mpg

Cavalier -0.963 -0.562 -0.942 -0.209 -0.772 -0.511 -0.648 -0.455 -0.118

Malibu 0.083 0.648 0.833 0.567 -0.165 0.563 0.382 -0.097 -0.769

Impala 0.835 1.051 1.156 1.503 1.290 1.648 1.310 0.924 -0.118

Mustang 1.688 1.588 1.479 -0.958 1.331 -0.251 0.799 0.260 -1.094

Taurus 0.514 0.513 0.349 0.968 1.290 1.377 1.252 0.413 -1.094

Focus -1.265 -0.831 -1.200 -0.503 -1.176 -1.200 -0.955 -1.016 0.857

Civic -1.083 -1.368 -1.232 -0.450 -1.096 -1.166 -1.573 -1.680 1.508

Accord -0.296 -0.428 -0.296 0.540 0.199 0.382 0.055 0.975 -0.118

GrandAm 1.100 1.051 0.995 0.567 0.239 0.100 0.492 0.005 -0.769

Corolla -1.012 -1.100 -0.780 -2.108 -1.257 -1.291 -1.351 -1.016 1.833

Camry 0.397 -0.562 -0.361 0.085 0.118 0.348 0.236 1.689 -0.118

attr(,”scaled:center”)

precio motor CV pisada ancho largo peso_neto deposito mpg

16.275091 2.618182 144.181818 104.881818 69.809091 185.418182 2.911909 15.190909 27.363636

attr(,”scaled:scale”)

precio motor CV pisada ancho largo peso_neto deposito mpg

3.1303620 0.7440674 30.9865073 3.7381327 2.4728342 8.8457694 0.3642111 1.9588030 3.0748245

Con esta estructura en el data.frame podemos realizar el análisi clúster

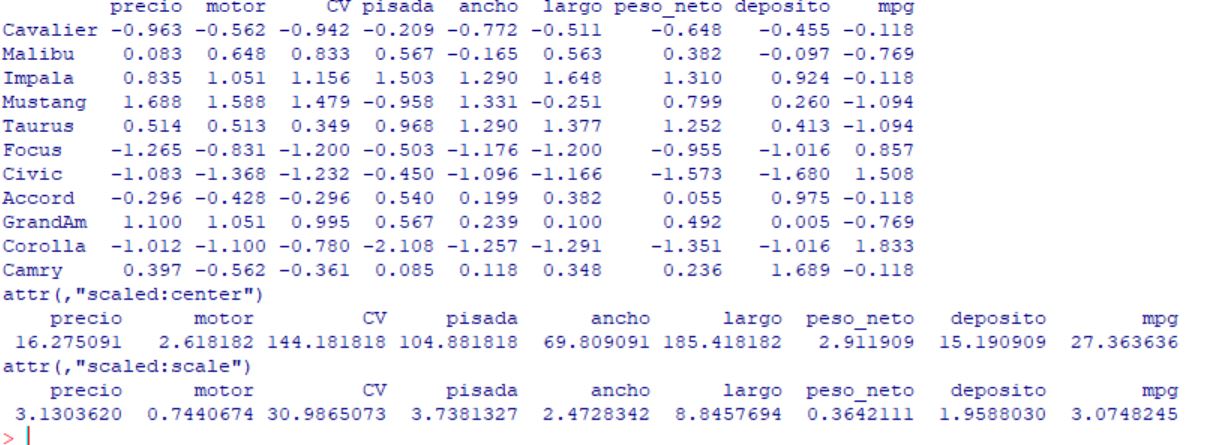

En primer lugar vamos a calcular la matriz de distancias.

Las medidas que podemos elegir para la matriz de distancias son “euclidean”, “maximum”,”manhattan”, “canberra”,”binary” o “minkowski“.

Nosotros vamos a usar la distancia euclídea.

> dmx <- dist(X.scale[, colnames(x)], method = “euclidean”)

> dmx

Cavalier Malibu Impala Mustang Taurus Focus Civic Accord GrandAm Corolla

Malibu 3.072816

Impala 5.274025 2.708019

Mustang 5.110737 3.084236 3.526982

Taurus 4.418552 2.122562 1.618253 3.224947

Focus 1.522351 4.323238 6.447844 6.136681 5.743645

Civic 2.518551 5.107705 7.099278 6.849459 6.472819 1.256555

Accord 2.391317 2.102429 3.297454 4.134429 2.650065 3.652378 4.447080

GrandAm 3.812895 1.274623 2.532611 2.185040 2.190572 4.956890 5.681518 2.727180

Corolla 3.063649 5.408865 7.389655 6.598459 6.831109 2.002918 1.915638 4.783256 5.896650

Camry 3.030349 2.642446 3.450847 3.988278 2.915417 4.201357 4.992374 1.122524 2.927103 5.048393

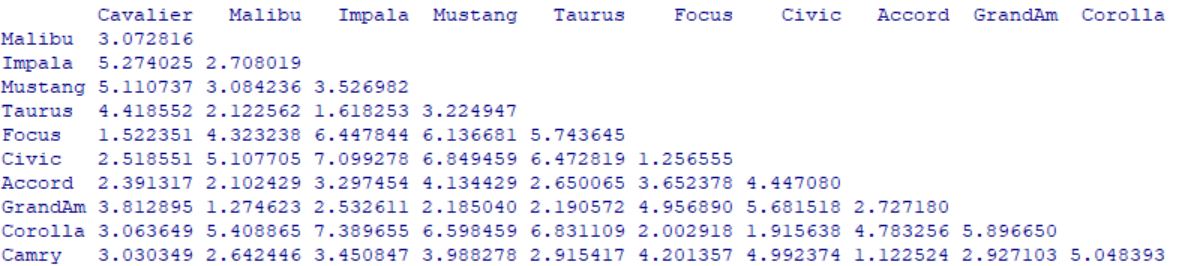

> round(dmx,3)

Cavalier Malibu Impala Mustang Taurus Focus Civic Accord GrandAm Corolla

Malibu 3.073

Impala 5.274 2.708

Mustang 5.111 3.084 3.527

Taurus 4.419 2.123 1.618 3.225

Focus 1.522 4.323 6.448 6.137 5.744

Civic 2.519 5.108 7.099 6.849 6.473 1.257

Accord 2.391 2.102 3.297 4.134 2.650 3.652 4.447

GrandAm 3.813 1.275 2.533 2.185 2.191 4.957 5.682 2.727

Corolla 3.064 5.409 7.390 6.598 6.831 2.003 1.916 4.783 5.897

Camry 3.030 2.642 3.451 3.988 2.915 4.201 4.992 1.123 2.927 5.048

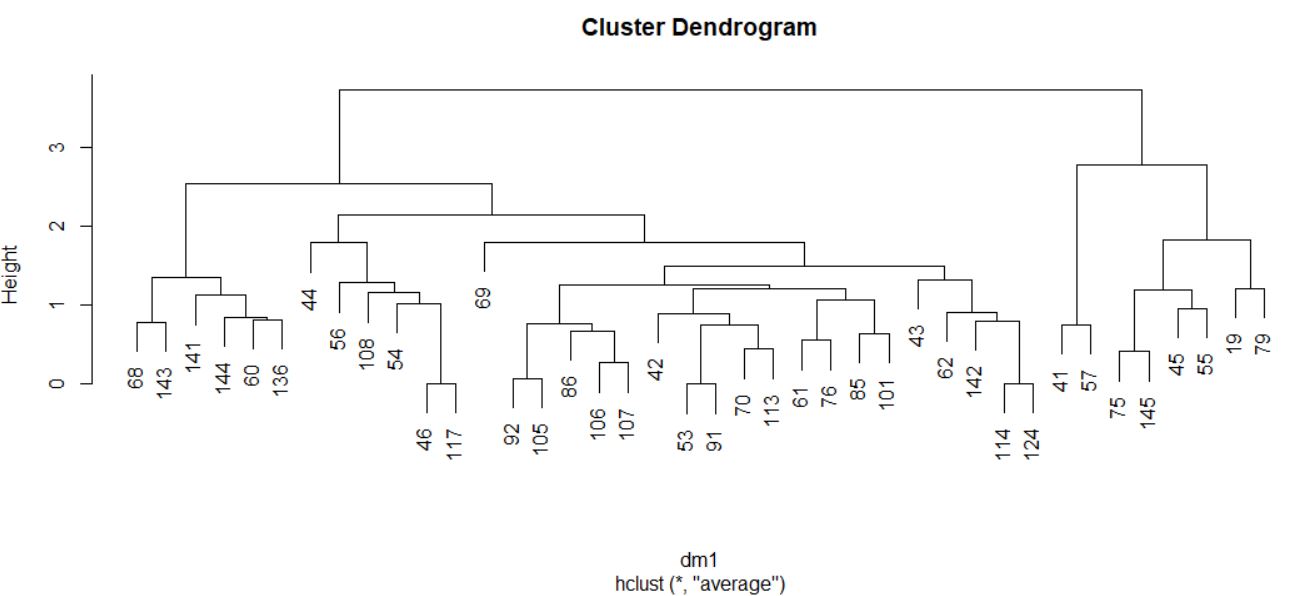

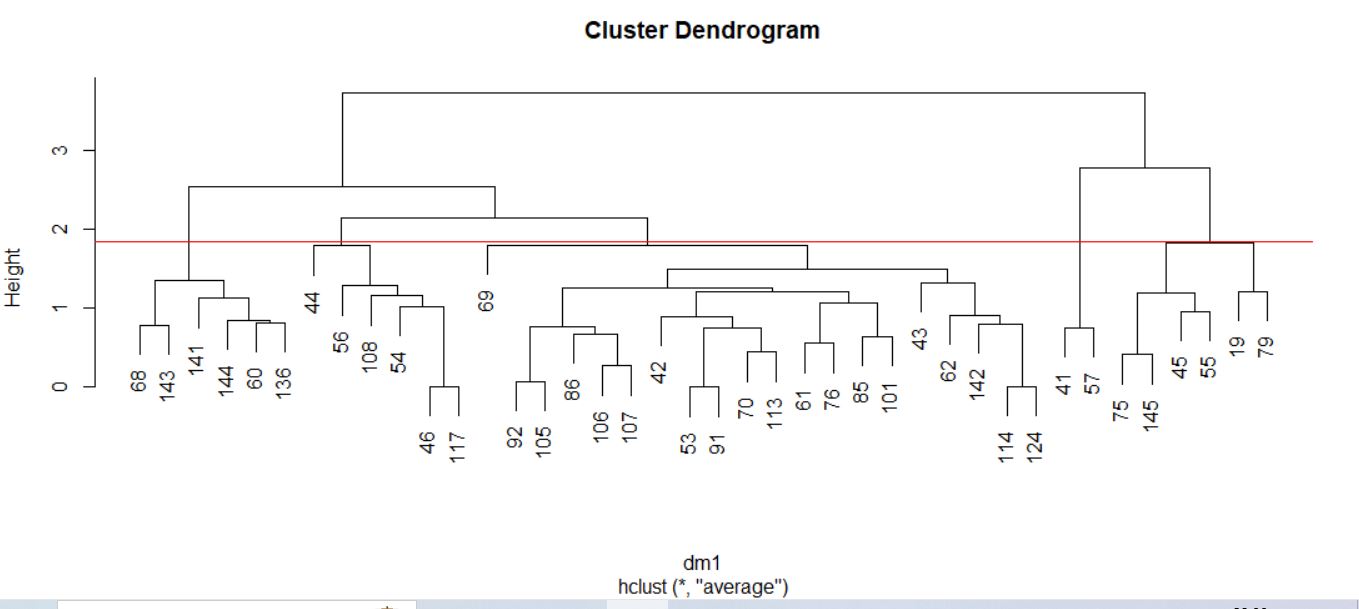

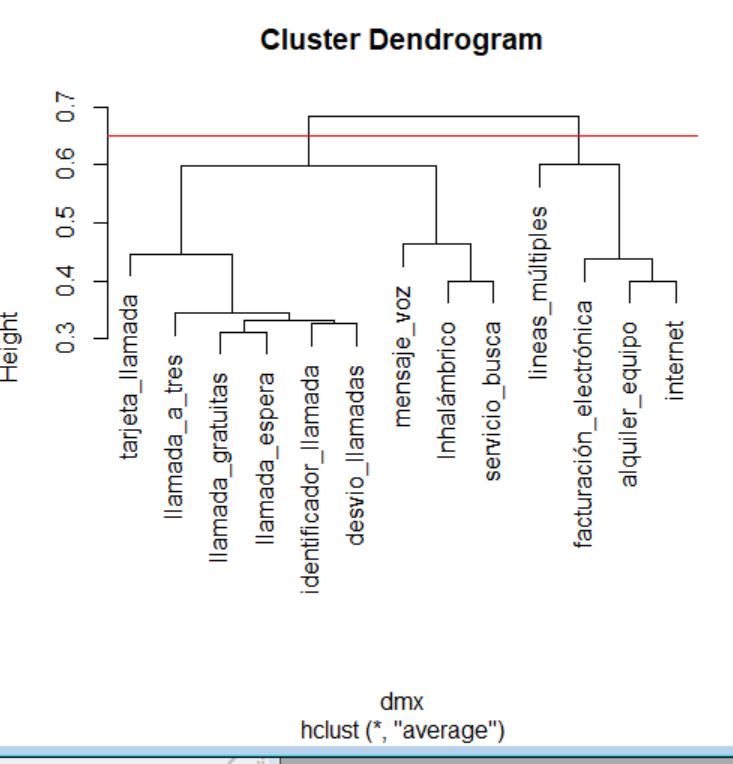

Hermos obtenido nuestra matriz de distancias. A continuación vamos a realizar el análisis clúster. Y para ello vamos a elegir el método de conglomeración.

Método de conglomeración. Los métodos de enlace (linkage) utilizan la proximidad entre pares de individuos para unir grupos de individuos. Existen diversas formas de medir la distancia entre clúster que producen diferentes agrupaciones y diferentes dendogramas. No hay un criterio para seleccionar cual es el algoritmo mejor. La decisión es normalmente subjetiva y depende del método que mejor refleje los propósitos de cada estudio en particular.

- Vinculación inter-grupos. “average”. Media Intergrupos

- Vinculación intra-grupos. “mcquitty”. Media Intragrupos

- Vecino más próximo. “single”. Enlace sencillo (salto mínimo). Utiliza la mínima distancia/disimilitud entre dos individuos de cada grupo (útil para identificar atípicos). Conduce a clusters encadenados

- Vecino más lejano. “complete”. Enlace completo (salto máximo). Utiliza la máxima distancia/disimilitud entre dos individuos de cada grupo. Conduce a clusters compactos

- Agrupación de centroides. “centroid”. Utiliza la distancia/disimilitud entre los centros de los grupos

- Agrupación de medianas. “median”. Utiliza la mediana de las distancias/disimilitud entre todos los individuos de los dos grupos

- Método de Ward. “ward.D” o “ward.D2”. Tiene tendencia a formar clusters más compactos y de igual tamaño y forma, en comparación con el enlace medio

Para más información sobre los distintos métodos escribir “?hclust” en la consola.

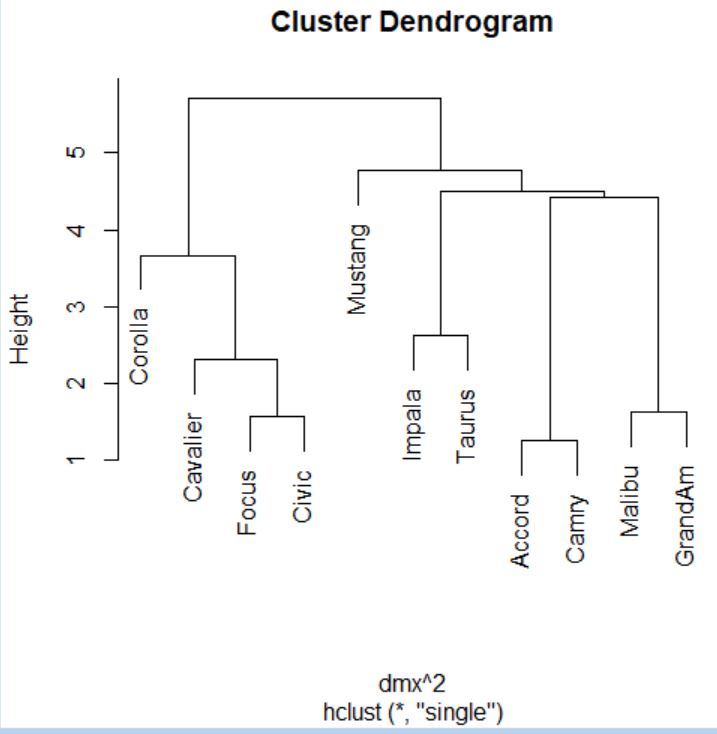

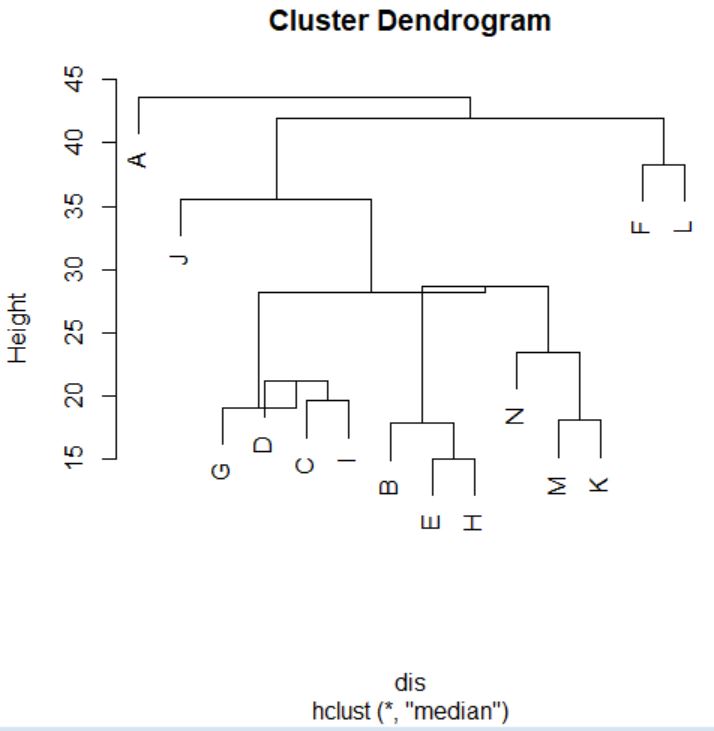

Vamos a elegir como método Vecino más próximo. Es decir, “single”.

> cs <- hclust(dmx^2, method = “single”)

> cs

Call:

hclust(d = dmx^2, method = “single”)

Cluster method : single

Distance : euclidean

Number of objects: 11

De esta forma elegimos el método, y como la distancia que queremos es la euclídea al cuadrado. elevamos nuestra matriz de distancias a 2.

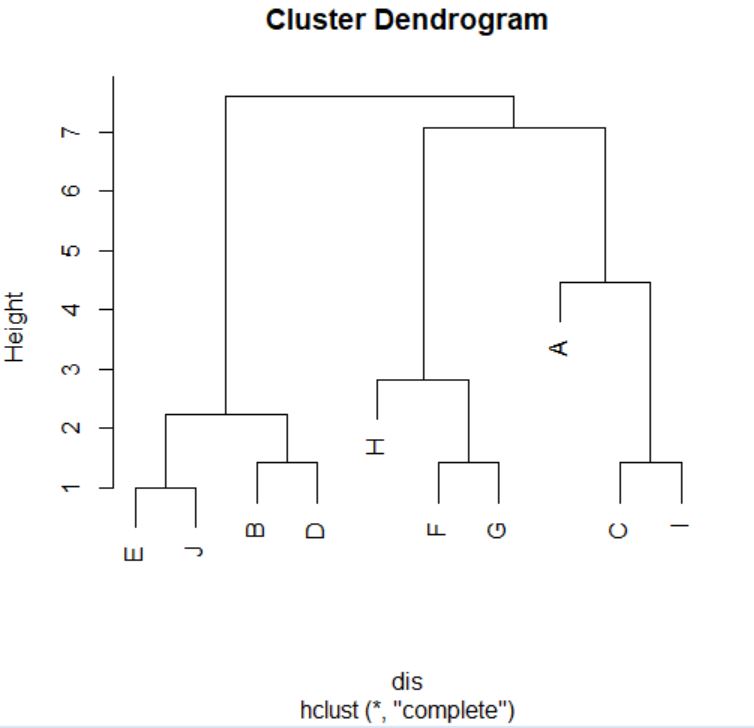

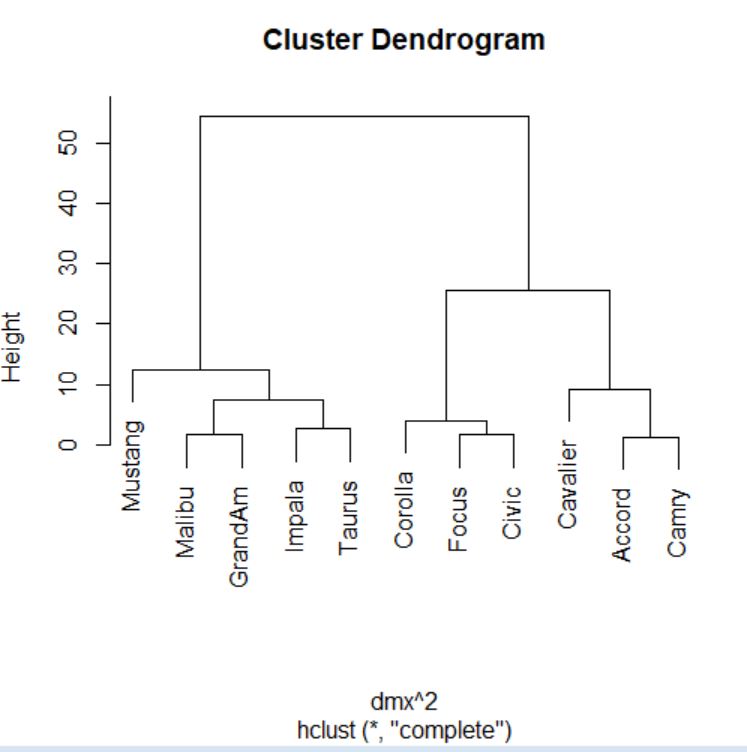

A continuación construimos el dendrograma.

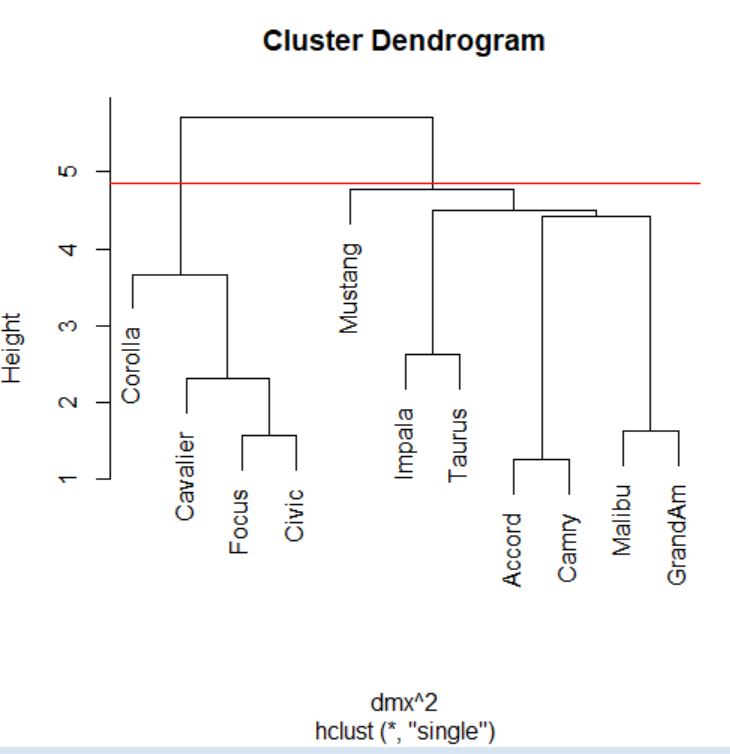

> plot(cs)

> abline(h=4.85, col=”red”)

Cortamos donde más nos interese, en este caso por ejemplo en el 4.85.

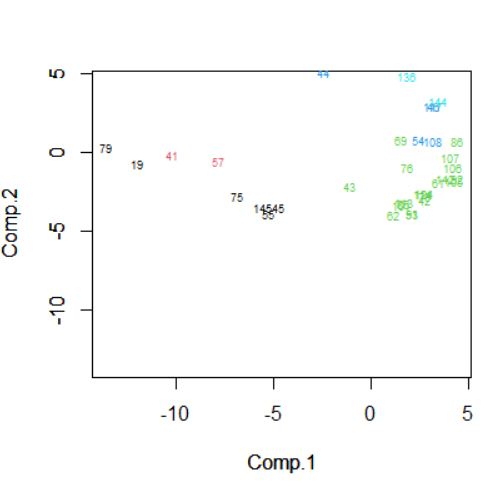

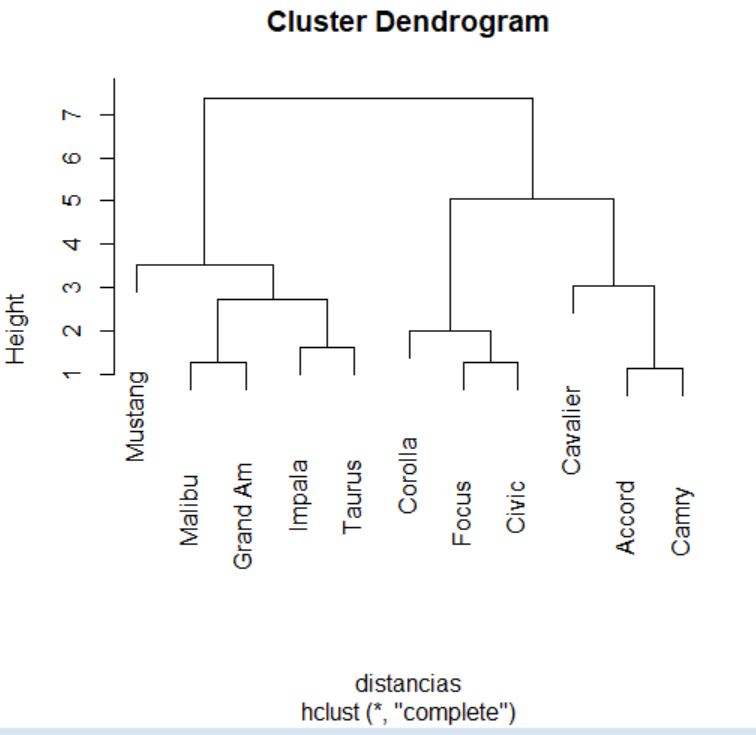

Dendrograma. Es una representación gráfica en forma de árbol, en el que los clusters están representados mediante trazos verticales (horizontales) y las etapas de fusión mediante trazos horizontales (verticales). La separación entre las etapas de fusión es proporcional a la distancia a la que están los grupos que se funden en esa etapa. Es un resumen gráfico de la solución de clúster. Los casos (marcas de coche) se encuentran a lo largo del eje vertical izquierdo. El eje horizontal muestra la distancia entre los grupos cuando se unieron (de 0 a 5.71).

Analizar el árbol de clasificación para determinar el número de grupos es un proceso subjetivo. En general, se comienza por buscar “huecos” entre uniones a lo largo del eje horizontal. De derecha a izquierda hay un hueco en el 4.8, que divide los coches en dos grupos:

- Un grupo está formado por los modelos: Accord, Camry, Malibu, Grand Am, Impala, Taurus, Mustang y

- el otro grupo está formado por los modelos: Focus, Civic, Cavalier y Corolla.

Con el siguiente código podemos ver donde se han ido formando los clústers.

> cs$height

[1] 1.260060 1.578930 1.624664 2.317551 2.618741 3.669669 4.420208 4.505270

[9] 4.774399 5.718398

Realizamos el Historial de conglomeración

> cs$merge

[,1] [,2]

[1,] -8 -11

[2,] -6 -7

[3,] -2 -9

[4,] -1 2

[5,] -3 -5

[6,] -10 4

[7,] 1 3

[8,] 5 7

[9,] -4 8

[10,] 6 9

El Historial de conglomeración es una tabla que muestra un resumen numérico de la solución del método clúster utilizado. El Historial muestra los casos o conglomerados combinados en cada etapa, las distancias entre los casos o los conglomerados que se combinan (Coeficientes), así como el último nivel del proceso de conglomeración en el que cada caso (o variable) se unió a su conglomerado correspondiente. Cuando se combinan dos clusters, R asigna al nuevo clúster la etiqueta menor entre las que tienen los clusters que se combinan.

En nuestro ejemplo, en la primera etapa se unen los casos 8 y 11 (Accord (8), Camry (11)) porque son los que tienen la distancia más pequeña (1.260). El grupo creado por 8 y 11 aparece de nuevo en la etapa 7 donde se une al clúster 2 (formado en la etapa 3). Por lo tanto en esta etapa se unen los grupos creados en las etapas 1 y 3 y el grupo resultante formado por 8, 11, 2 y 9 aparece en la siguiente etapa la 8.

Si hay muchos casos la tabla es bastante larga, pero suele ser más fácil de estudiar la columna de coeficientes para distinguir grandes distancias que analizar el dendrograma. Cuando se observa un salto inesperado en el coeficiente de distancia, la solución antes de ese hueco indica una buena elección de conglomerados.

Las mayores diferencias en la columna de los coeficientes se producen entre las etapas 5 y 6, lo que indica una solución de 6-clúster ((8, 11); (2,9); (3, 5); (4); (6, 7, 1); (10)) y entre las etapas 9 y 10, lo que indica una solución de 2-clúster. Estos son los mismos que los resultados del dendrograma.

En este estudio no hemos podido obtener unas conclusiones sólidas sobre la agrupación de los automóviles de mayor venta en función de sus precios, fabricante, modelo y propiedades físicas. Puede deberse a que hemos utilizado como método de clúster el Vecino más próximo que, aunque es aconsejable para examinar los grados de similitud es pobre en la construcción de los distintos grupos. Por ello, debemos volver a realizar de nuevo el análisis utilizando otro método de conglomerado.

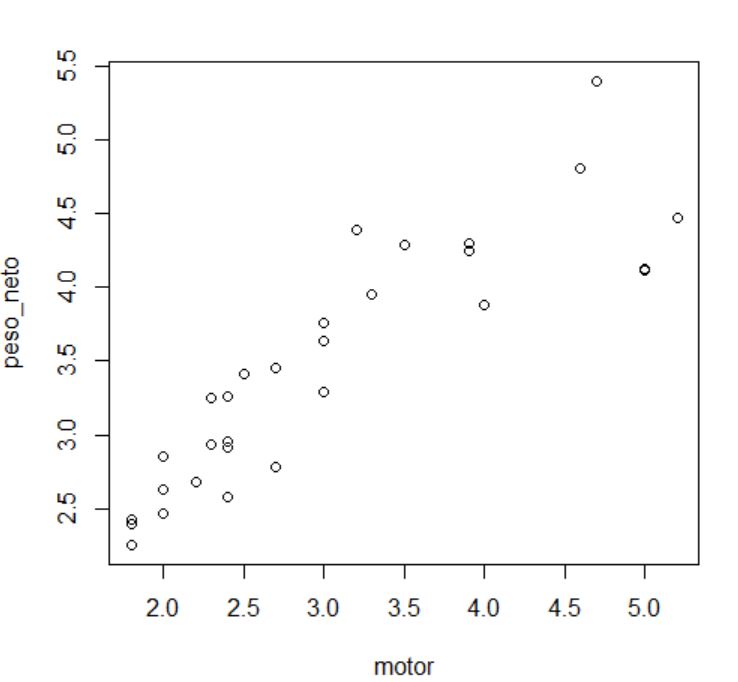

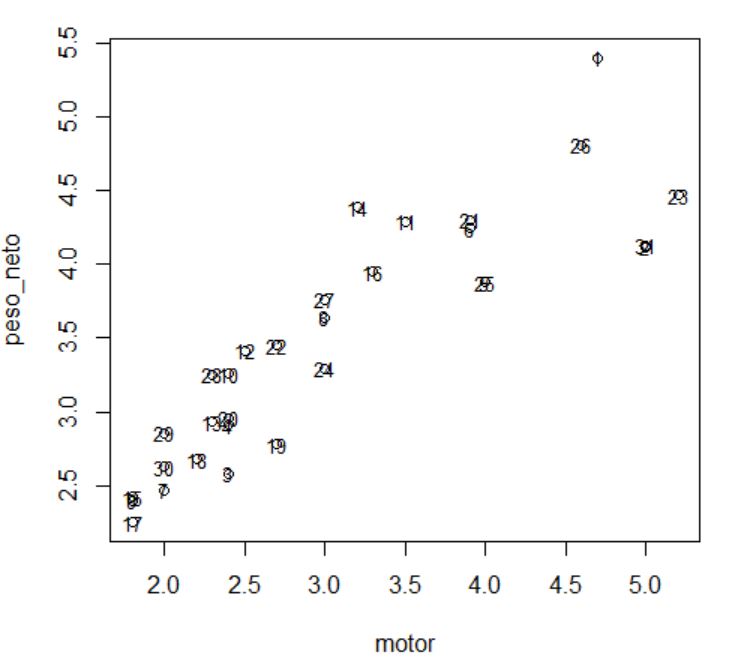

Supuesto práctico 2

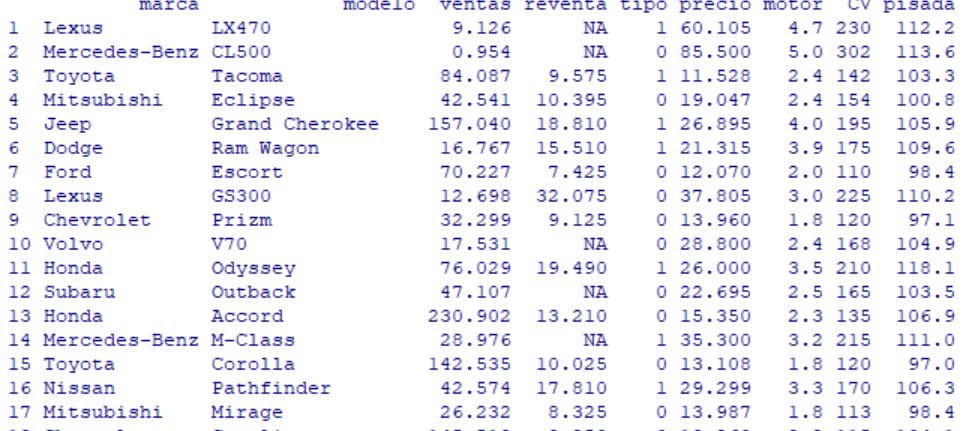

Se desea hacer un estudio de mercado sobre las preferencias de los consumidores al adquirir un vehículo, como en el supuesto práctico 1. Para ello, disponemos de un conjunto de datos, que se encuentra en el fichero ventas_vehiculos.txt.

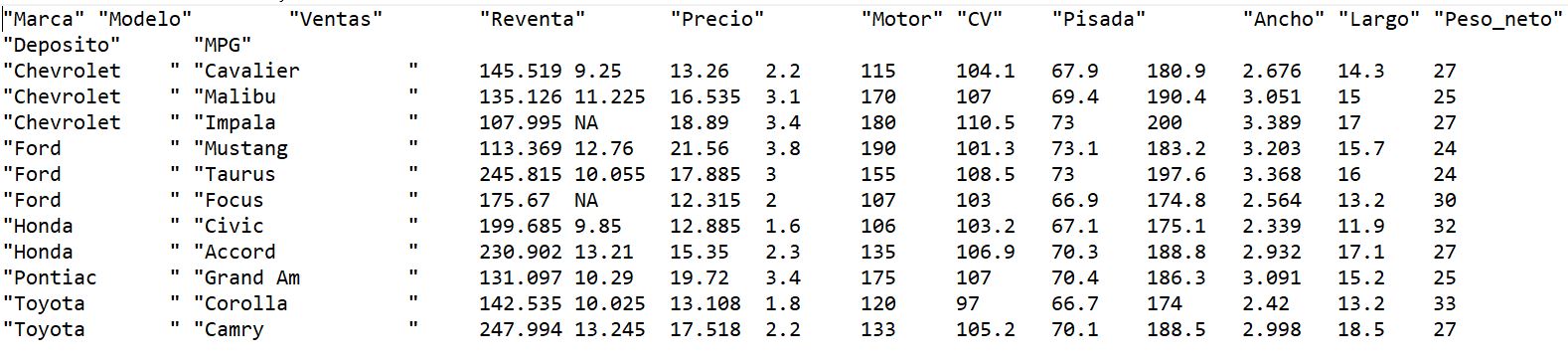

Tabla1: Datos del Supuesto práctico 2

El fichero contiene 11 datos, cada uno de ellos correspondiente a un vehículo. Para cada vehículo se han recogido las siguientes variables:

- Marca del automóvil.

- Modelo del automóvil.

- Ventas. Número de vehículos vendidos durante un determinado año, en miles de unidades.

- Reventa. Precio de reventa en 4 años, en miles de euros.

- Precio. Precio de venta, en miles de euros.

- Motor. Tamaño del motor.

- CV. Caballos de potencia.

- Pisada. Base de los neumáticos.

- Ancho. Anchura del vehículo.

- Largo. Longitud del vehículo.

- Peso_neto. Peso neto del vehículo.

- Depósito. Capacidad del depósito de combustible.

- MPG. Millas por galón, medida de consumo del vehículo.

En primer lugar, debemos importar en R los datos de los vehículos. Para ello, utilizamos la orden read.table.

> setwd(“C:/Users/Usuario/Desktop/Datos”) # Nos situamos en el directorio donde se encuentra el fichero de datos

> datos <- read.table(“ventas_vehiculos.txt”, header = TRUE)

Cuando las variables vienen dadas en diferentes unidades de medida, se recomienda escalar los datos, para que la formación de los clústers no se vea afectada por dichas unidades de medida. Para escalar un conjunto de datos, se utiliza la función scale. Esta función solo puede aplicarse sobre las variables del conjunto de datos que sean de tipo numérico.

> datos[3:13] <- scale(datos[3:13])

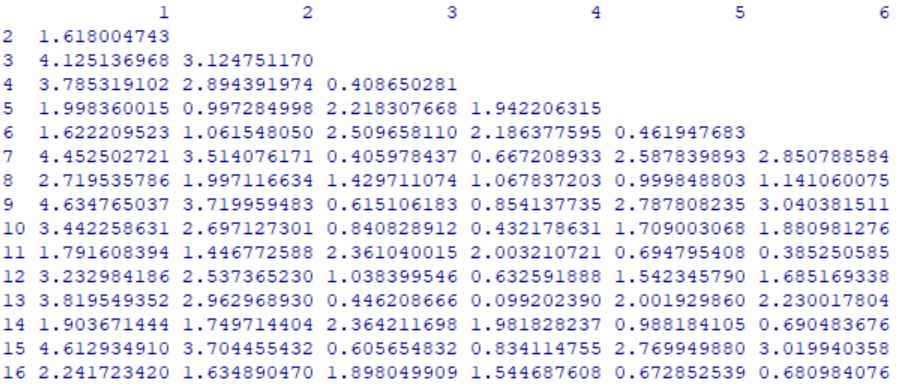

A continuación, antes de realizar el análisis clúster en sí, es necesario calcular la distancia entre las observaciones. Para ello, se utiliza la función de R dist. La sintaxis de esta función es la siguiente:

dist(x, method = “euclidean”, p = 2)

donde

- x es una matriz numérica o un data frame.

- method indica el método que se empleará para calcular las distancias entre individuos. Las posibles opciones son “euclidean”, para la distancia euclídea (por defecto); “maximum”, para la distancia máxima; “manhattan”, para la distancia Manhattan; “canberra”, para la distancia Canberra y “minkowski”, para la distancia de Minkowski.

- p es un valor numérico que se indica el valor de p, en el caso de que se seleccione la distancia de Minkowski en el argumento method.

Utilizaremos la función dist para calcular las distancias entre las observaciones de la muestra a partir de algunas de las variables de las que se dispone. En nuestro caso, utilizaremos las variables Precio, Motor, CV, Pisada, Ancho, Largo, Peso_neto, Deposito y MPG y usaremos la distancia euclídea.

> attach(datos)

> variables <- data.frame (Precio, Motor, CV, Pisada, Ancho, Largo, Peso_neto, Deposito, MPG)

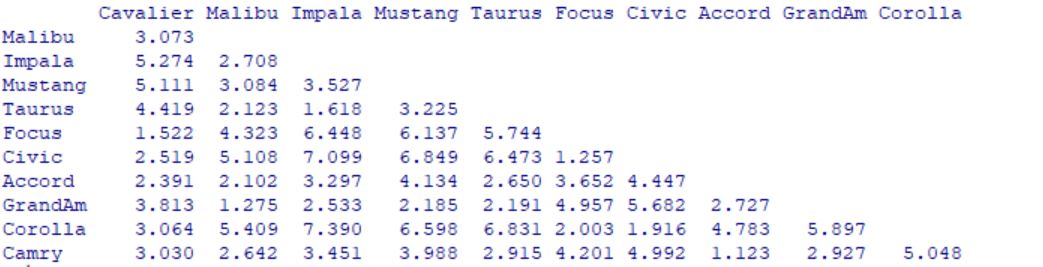

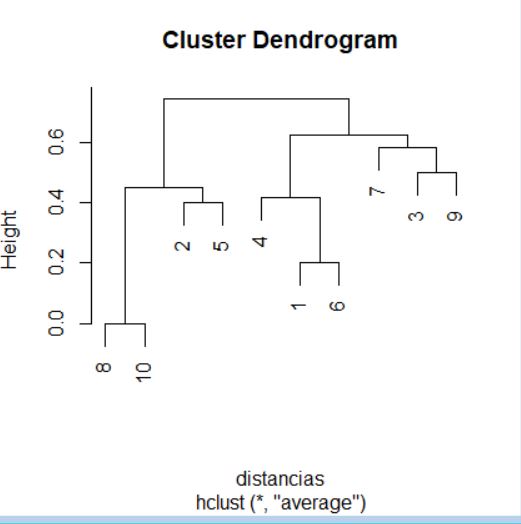

> distancias <- dist(variables, method = “euclidean”)

> distancias

1 2 3 4 5 6 7 8 9 10

2 3.072816

3 5.274025 2.708019

4 5.110737 3.084236 3.526982

5 4.418552 2.122562 1.618253 3.224947

6 1.522351 4.323238 6.447844 6.136681 5.743645

7 2.518551 5.107705 7.099278 6.849459 6.472819 1.256555

8 2.391317 2.102429 3.297454 4.134429 2.650065 3.652378 4.447080

9 3.812895 1.274623 2.532611 2.185040 2.190572 4.956890 5.681518 2.727180

10 3.063649 5.408865 7.389655 6.598459 6.831109 2.002918 1.915638 4.783256 5.896650

11 3.030349 2.642446 3.450847 3.988278 2.915417 4.201357 4.992374 1.122524 2.927103 5.048393

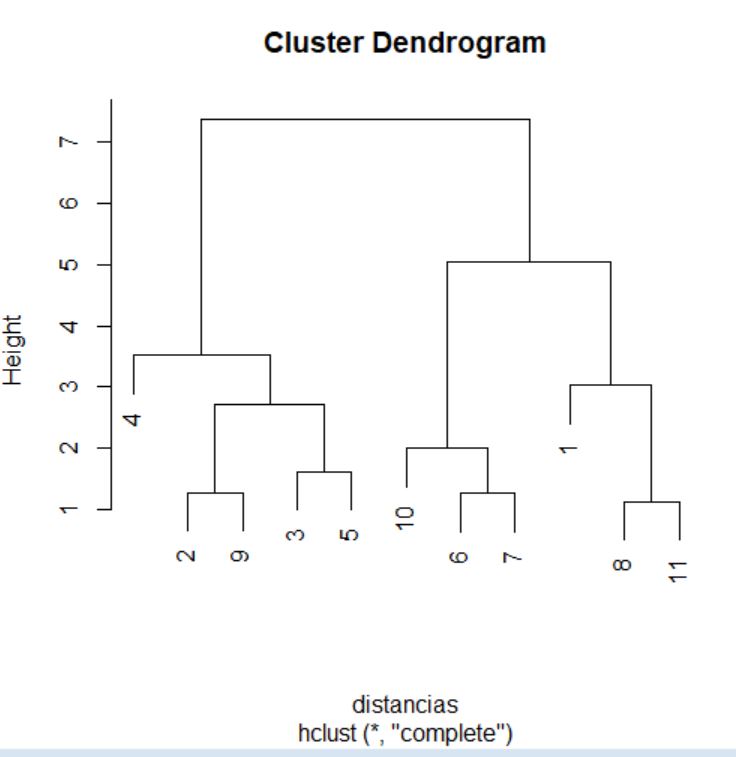

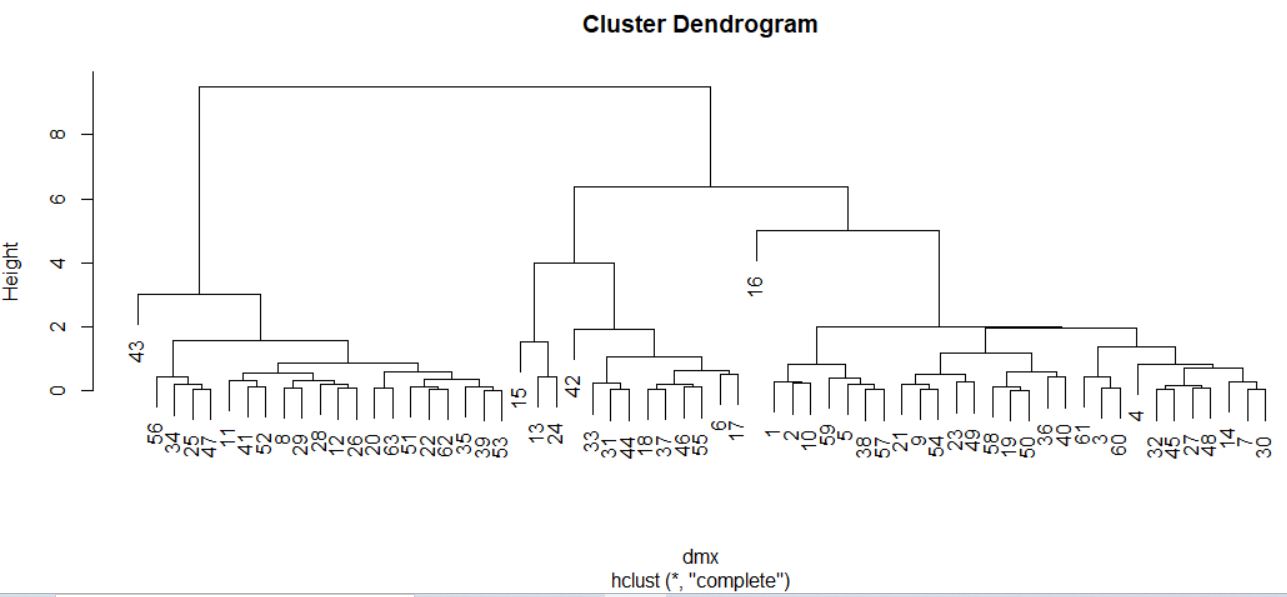

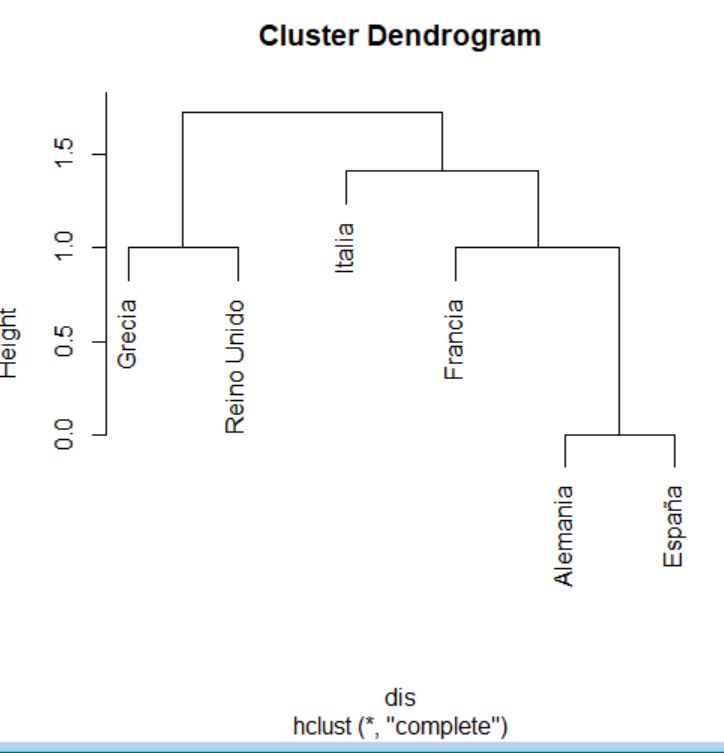

Una vez obtenidas las distancias, pasamos a realizar el análisis clúster propiamente dicho utilizando la función hclust de R. La sintaxis de esta función es la siguiente:

hclust(d, method = “complete”)

donde

- d es la matriz que proporciona la función dist.

- method indica el método que se empleará para conformar los clústers. Las posibles opciones son “ward.D”, “ward.D2”, dos variaciones del método de Ward; “single”, para el método del enlace simple; “complete”, para el método del enlace completo (por defecto); “average”, para el método del promedio entre grupos; “mcquitty”, para el método del promedio ponderado entre grupos; “median”, para el método de la mediana y “centroid”, para el método del centroide.

Utilizaremos la función hclust para llevar a cabo el análisis clúster y el método del enlace completo (o del vecino más lejano) como método de formación de los grupos de observaciones.

> cluster <- hclust(distancias, method = “complete”)

> cluster

Call:

hclust(d = distancias, method = “complete”)

Cluster method : complete

Distance : euclidean

Number of objects: 11

La función hclust devuelve varios elementos. Los más interesantes son el historial de aglomeración y las distancias de aglomeración, que se pueden consultar accediendo a los componentes merge y height, respectivamente, del objeto generado por hclust. Para acceder a dichos componentes, se indica el nombre del objeto generado por hclust (cluster, en nuestro caso), seguido del símbolo del dólar ($) y del nombre del componente.

> cluster$merge

[,1] [,2]

[1,] -8 -11

[2,] -6 -7

[3,] -2 -9

[4,] -3 -5

[5,] -10 2

[6,] 3 4

[7,] -1 1

[8,] -4 6

[9,] 5 7

[10,] 8 9

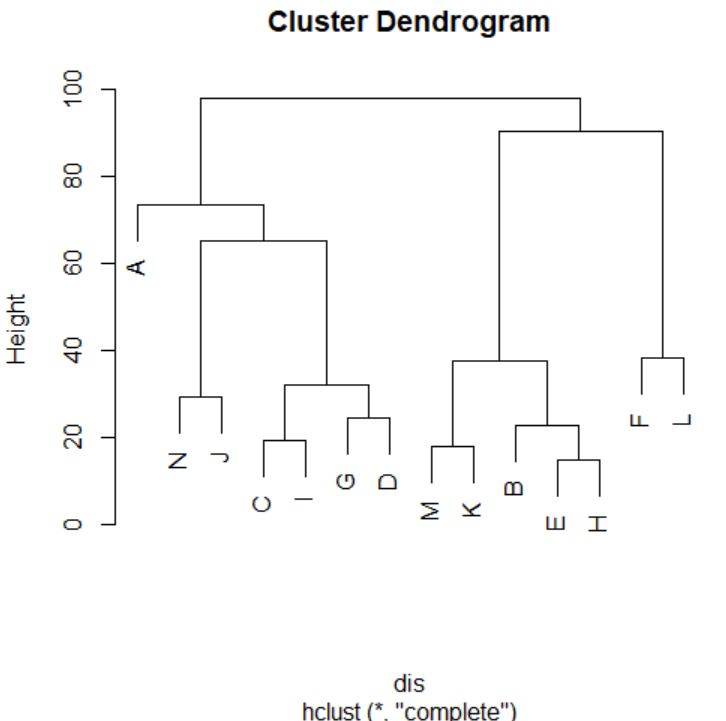

El historial de aglomeración indica qué dos elementos se funden en cada etapa del procedimiento de agrupamiento. Estos elementos pueden ser dos unidades individuales, dos grupos o una unidad individual y un grupo. En el historial de aglomeración, los números negativos indican unidades individuales y los números positivos indican grupos formados previamente.

En concreto, la interpretación del historial de aglomeración anterior es la que sigue:

- En la primera etapa se unen en un grupo las unidades individuales 8 y 11 (los números indican la posición dentro del fichero de datos).

- En la segunda etapa se unen en un grupo las unidades individuales 6 y 7.

- En la tercera etapa se unen en un grupo las unidades individuales 2 y 9.

- En la cuarta etapa se unen en un grupo las unidades individuales 3 y 5.

- En la quinta etapa se unen en un grupo la unidad individual 10 y el grupo formado en la etapa 2 (esto es, el grupo formado por las unidades 6 y 7).

- En la sexta etapa se unen en un grupo los grupos formados en la etapa 3 (esto es, el formado por las unidades 2 y 9) y en la etapa 4 (esto es, el formado por las unidades 3 y 5).

- En la séptima etapa se unen en un grupo la unidad individual 1 y el grupo formado en la etapa 1 (esto es, el grupo formado por las unidades 8 y 11).

- En la octava etapa se unen en un grupo la unidad individual 4 y el grupo formado en la etapa 6 (esto es, el grupo formado por las unidades 2, 3, 5 y 9).

- En la novena etapa se unen en un grupo los grupos formados en la etapa 5 (esto es, el formado por las unidades 6, 7 y 10) y en la etapa 7 (esto es, el formado por las unidades 1, 8 y 11).

- Por último, en la décima etapa se unen en un grupo los grupos formados en la etapa 8 (esto es, el formado por las unidades (2, 3, 4, 5 y 9) y en la etapa 9 (esto es, el formado por las unidades 1, 6, 7, 8, 10 y 11).

> cluster$height

[1] 1.122524 1.256555 1.274623 1.618253 2.002918 2.708019 3.030349 3.526982

[9] 5.048393 7.389655

Como ya hemos comentado, el componente height incluye las distancias a las que se producen las uniones entre unidades y/o grupos en cada etapa. Así, a modo de ejemplo, en nuestro caso podemos concluir que, en la primera etapa, las unidades 8 y 11 están separadas por una distancia de 1.1225 unidades. También sabemos que los grupos que se unen en la décima etapa están separados por una distancia de 7.3896 unidades.

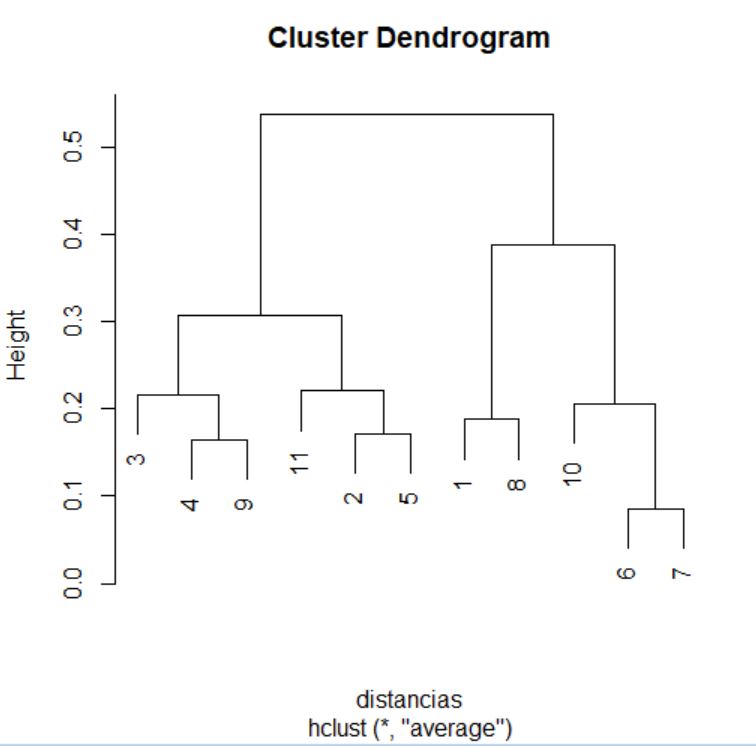

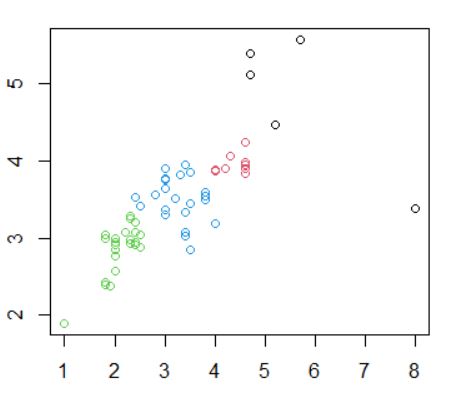

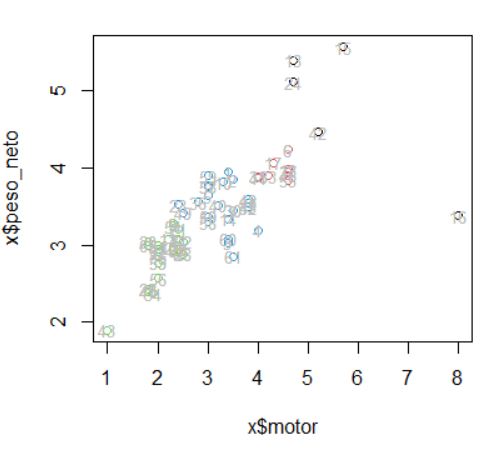

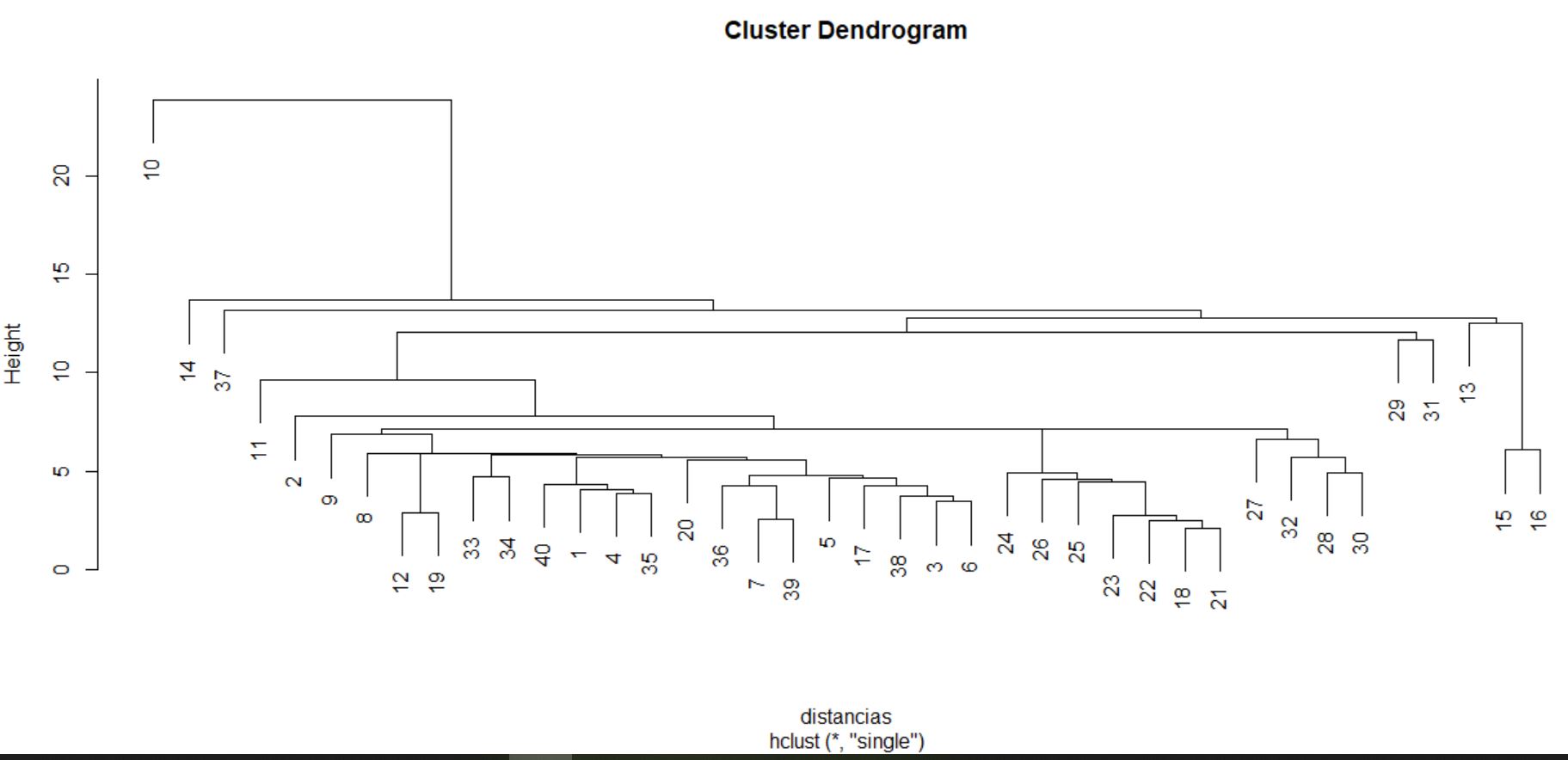

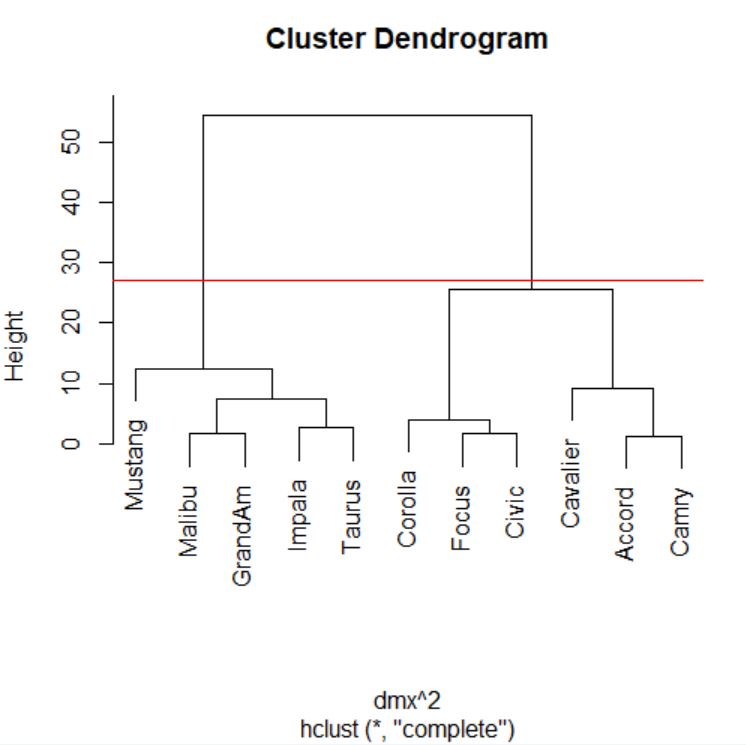

El proceso de agrupamiento de las unidades y de los grupos se suele visualizar a través de un gráfico conocido como dendrograma. Para realizar un dendrograma basta con utilizar la función plot, pasándole como argumento el objeto generado por la función hclust (cluster, en nuestro caso).

> plot(cluster)

El dendrograma, en este caso, se interpreta desde abajo hacia arriba. Si se desea, para facilitar la interpretación, se pueden incluir las etiquetas de los individuos mediante el argumento label en la llamada a la función plot.

> plot(cluster, labels = datos$Modelo)

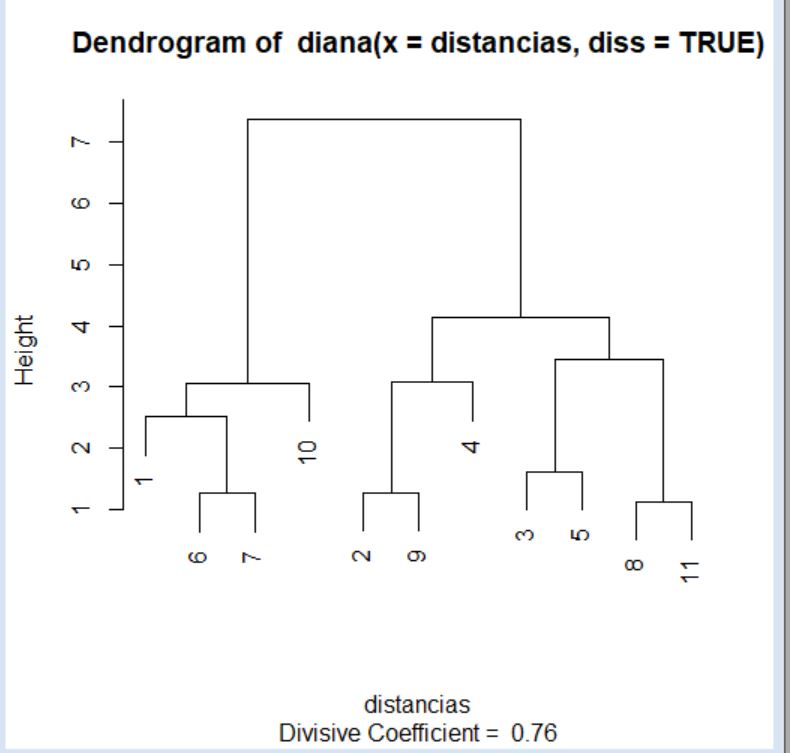

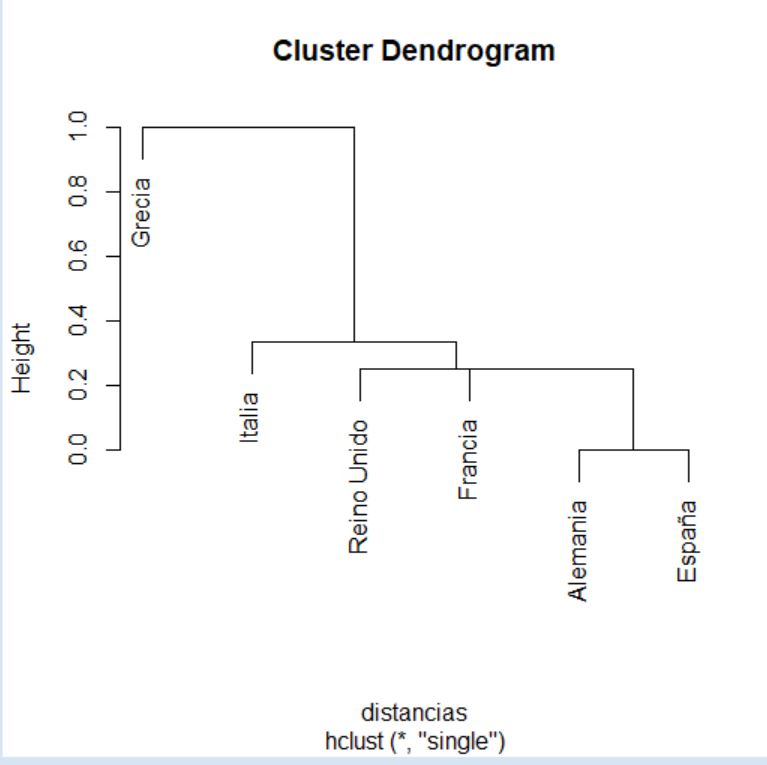

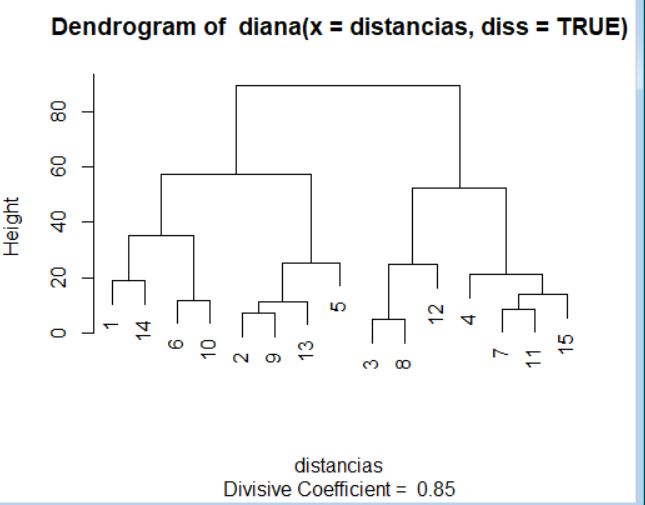

Supuesto práctico 3: Análisis clúster jerárquico divisivo o disociativo en R

A partir de los datos del supuesto práctico 1, realizar un análisis clúster divisivo o disociativo.

Todos los métodos que ofrece la función hclust son de tipo aglomerativo. Para hacer un análisis clúster jerárquico divisivo se utiliza la función diana, que pertenece al paquete que se llama cluster. Por lo tanto, el primer paso consiste en instalar y cargar el paquete cluster.

> install.packages(“cluster”)

> library(cluster)

A continuación, se importan los datos y se escalan las variables numéricas del conjunto de datos, tal y como se hizo en el supuesto práctico anterior.

> datos <- read.table(“ventas_vehiculos.txt”, header = TRUE)

> datos[3:13] <- scale(datos[3:13])

El siguiente paso es calcular la matriz de distancias, usando la función dist. De nuevo, volveremos a utilizar la distancia euclídea.

> variables <- data.frame (Precio, Motor, CV, Pisada, Ancho, Largo, Peso_neto, Deposito, MPG)

> distancias <- dist(variables, method = “euclidean”)

1 2 3 4 5 6 7 8 9 10

2 3.072816

3 5.274025 2.708019

4 5.110737 3.084236 3.526982

5 4.418552 2.122562 1.618253 3.224947

6 1.522351 4.323238 6.447844 6.136681 5.743645

7 2.518551 5.107705 7.099278 6.849459 6.472819 1.256555

8 2.391317 2.102429 3.297454 4.134429 2.650065 3.652378 4.447080

9 3.812895 1.274623 2.532611 2.185040 2.190572 4.956890 5.681518 2.727180

10 3.063649 5.408865 7.389655 6.598459 6.831109 2.002918 1.915638 4.783256 5.896650

11 3.030349 2.642446 3.450847 3.988278 2.915417 4.201357 4.992374 1.122524 2.927103 5.048393

Ahora ya podemos utilizar la función diana del paquete cluster. La sintaxis de esta función es la que sigue:

diana(x, diss, metric = “euclidean”)

donde

- x es, bien una matriz de distancias (como la que proporciona la función dist), o bien un data frame con los valores de las variables a partir de las cuales se realizará el análisis clúster. Estas variables han de ser numéricas.

- diss es un valor lógico. Si este parámetro es igual a TRUE, indica que el parámetro x es una matriz de distancias. Si este parámetro es igual a FALSE, indica que el parámetro x es un data frame con valores de las variables.

- metric es una cadena de caracteres usada para calcular la distancia entre observaciones, solo en el caso en que x contenga los valores de las variables. Los posibles valores para este parámetro son “euclidean”, para la distancia euclídea (valor por defecto) y “manhattan”, para la distancia Manhattan.

> cluster <- diana(distancias, diss = TRUE)

Merge:

[,1] [,2]

[1,] -8 -11

[2,] -6 -7

[3,] -2 -9

[4,] -3 -5

[5,] -1 2

[6,] 5 -10

[7,] 3 -4

[8,] 4 1

[9,] 7 8

[10,] 6 9

Order of objects:

[1] 1 6 7 10 2 9 4 3 5 8 11

Height:

[1] 2.518551 1.256555 3.063649 7.389655 1.274623 3.084236 4.134429 1.618253 3.450847 1.122524

Divisive coefficient:

[1] 0.7636703

Available components:

[1] “order” “height” “dc” “merge” “diss” “call”

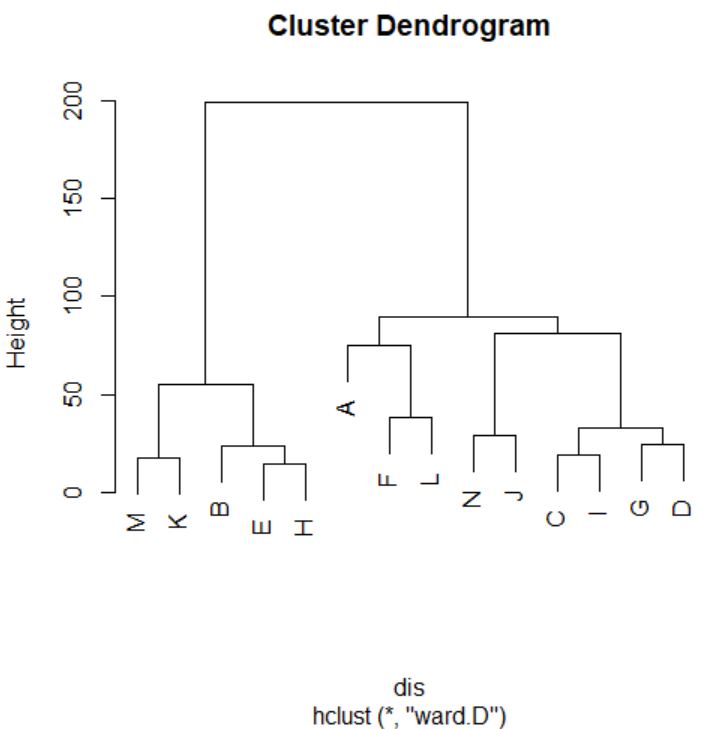

Como ocurría en el supuesto anterior, el objeto que devuelve la función diana contiene algunos componentes interesantes. De hecho, los nombres de los componentes que nos interesan son merge y height que, como en el caso anterior, indican el historial de disociación y las distancias de disociación, respectivamente. Comencemos por obtener el historial de disociación.

> cluster$merge

[,1] [,2]

[1,] -8 -11

[2,] -6 -7

[3,] -2 -9

[4,] -3 -5

[5,] -1 2

[6,] 5 -10

[7,] 3 -4

[8,] 4 1

[9,] 7 8

[10,] 6 9

En este caso, i-ésima fila de la matriz anterior indica el desagrupamiento que sea realiza en la etapa \( n_i \) del proceso. Por lo tanto, conviene interpretar el historial de disociación a partir de la última hasta la primera fila de la matriz que lo contiene. De nuevo, valores negativos en la matriz indican unidades individuales y los números positivos indican grupos de individuos. La interpretación del historial de disociación anterior es la siguiente:

- En la primera etapa (que corresponde con la décima fila de la matriz) se divide el conjunto total de observaciones en dos grupos: el que se volverá a dividir según lo indicado en la fila 6 de la matriz y el que se volverá a dividir según lo indicado en la fila 9 de la matriz.

- En la segunda etapa (que corresponde con la novena fila de la matriz) uno de los grupos generados en el paso anterior se vuelve a dividir en otros dos: el que se volverá a dividir según lo indicado en la fila 7 de la matriz y el que se volverá a dividir según lo indicado en la fila 8 de la matriz.

- En la tercera etapa (que corresponde con la octava fila de la matriz) uno de los grupos generados en el paso anterior se vuelve a dividir en otros dos: el que se volverá a dividir según lo indicado en la fila 4 de la matriz y el que se volverá a dividir según lo indicado en la fila 1 de la matriz.

- En la cuarta etapa (que corresponde con la séptima fila de la matriz) uno de los grupos generados en la segunda etapa se vuelve a dividir en un grupo que se volverá a dividir según lo indicado en la fila 3 de la matriz y una unidad individual (en concreto, la que ocupa la posición 4 en el fichero de datos).

- …

- Por último, en la décima etapa (que corresponde con la primera fila de la matriz) se dividen las unidades individuales 8 y 11, las cuales permanecían unidas hasta este momento.

Consultemos las distancias a las que se separan cada uno de los grupos.

> cluster$height

[1] 2.518551 1.256555 3.063649 7.389655 1.274623 3.084236 4.134429 1.618253 3.450847 1.122524

La primera división se produce a una distancia de 2.5185 unidades (entendiendo como distancia la mayor de las distancias entre dos unidades del conjunto de datos). Después, el resto de unidades se asigna al grupo del que se encuentra menos distante. La segunda división entre grupos se produce a una distancia de 1.2565 unidades.

Al igual que con los métodos aglomerativos, en este caso es posible representar un dendrograma para visualizar el proceso de división del conjunto de datos. Para ello, de nuevo, debemos utilizar la función plot pasándole como argumento el objeto generado por la función diana.

> plot(cluster)

La interpretación de este dendrograma se realiza desde arriba hacia abajo. Si comparamos este dendrograma con el del supuesto práctico anterior observamos importantes diferencias, por lo que la elección del método para la creación de los clústers (aglomerativo o divisivo) puede condicionar los resultados de forma notable.

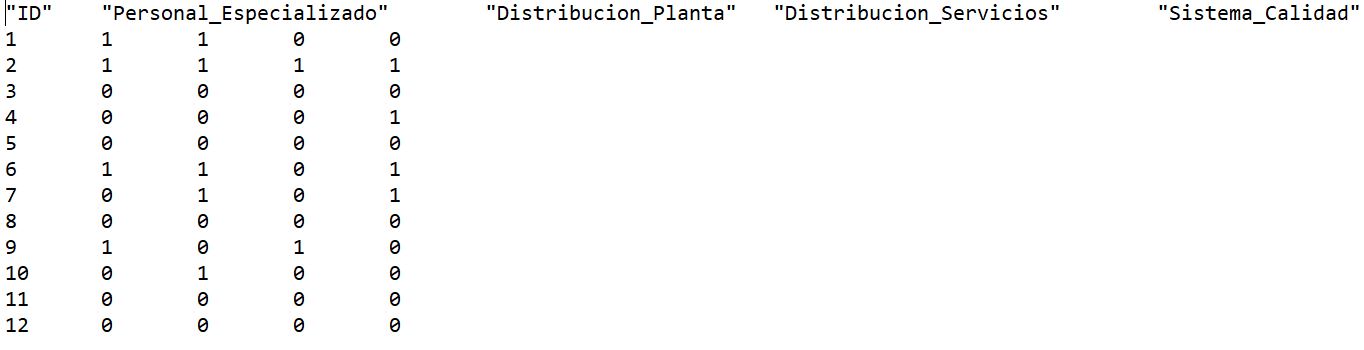

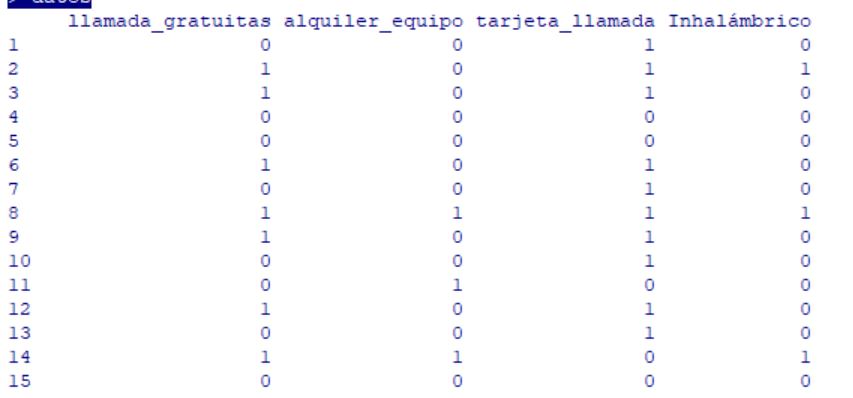

Supuesto práctico 4: Análisis clúster jerárquico en R con variables dicotómicas

Realizamos un estudio sobre las pequeñas y medianas empresas del sector textil. En el estudio se recoge información sobre si 12 empresas disponen de los siguientes servicios: Personal Especializado, Estudio de distribución de Planta, Estudio de distribución de Servicios y Aplicación de Sistema de Calidad. Si la empresa dispone del servicio en cuestión, la variable correspondiente toma el valor 1 y, si no dispone de él, la variable toma el valor 0.

Realizar un análisis clúster jerárquico aglomerativo utilizando el método del enlace simple (o del vecino más próximo).

Los datos se encuentran en el fichero empresas.txt.

Comenzamos importando los datos del fichero empresas.txt en R.

Tabla 2: Datos del Supuesto Práctico 3

Comenzamos importando los datos del fichero empresas.txt en R.

> datos <- read.table(“empresas.txt”, header = TRUE

A continuación, guardamos en un data frame las variables a partir de las cuales generaremos los grupos.

> attach(datos)

> variables <- data.frame(Personal_Especializado, Distribucion_Planta, Distribucion_Servicios, Sistema_Calidad)

Calculamos las distancias entre empresas mediante la función dist, teniendo en cuenta que la distancia a usar es la binaria, dado el carácter dicotómico de las variables.

> distancias <- dist(variables, method = “binary”)

Por último, llamamos a la función hclust, pasando como argumento la matriz de distancias que acabamos de calcular y el método que se ha de utilizar para la formación de los conglomerados.

> cluster <- hclust(distancias, method = “single”)

> cluster

Call:

hclust(d = distancias, method = “single”)

Cluster method : single

Distance : binary

Number of objects: 12

Consultemos ahora el historial de conglomeración, accediendo al componente merge del objeto que ha generado la función hclust.

> cluster$merge

[,1] [,2]

[1,] -3 -5

[2,] -8 1

[3,] -11 2

[4,] -12 3

[5,] -2 -6

[6,] -1 5

[7,] -7 6

[8,] -4 7

[9,] -9 8

[10,] -10 9

[11,] 4 10

Este historial se interpreta de la misma manera que el del supuesto práctico 1, por lo que podemos decir que las unidades que se unen en el primer paso son las situadas en la posición 3 y 5 del fichero. En el segundo paso, se unen el grupo formado en el paso anterior con la unidad situada en la posición 8 del fichero. El proceso continúa hasta que en el undécimo y último paso se fusionan los grupos generados en la etapa 4 y en la etapa 10 del procedimiento.

Veamos ahora las distancias a las que se producen los agrupamientos. Para ello, accedemos al componente height del objeto cluster.

> cluster$height

[1] 0.0000000 0.0000000 0.0000000 0.0000000 0.2500000 0.3333333 0.3333333

[8] 0.5000000 0.5000000 0.5000000 1.0000000

Terminemos este ejemplo graficando el dendrograma asociado mediante la orden plot.

> plot(cluster)

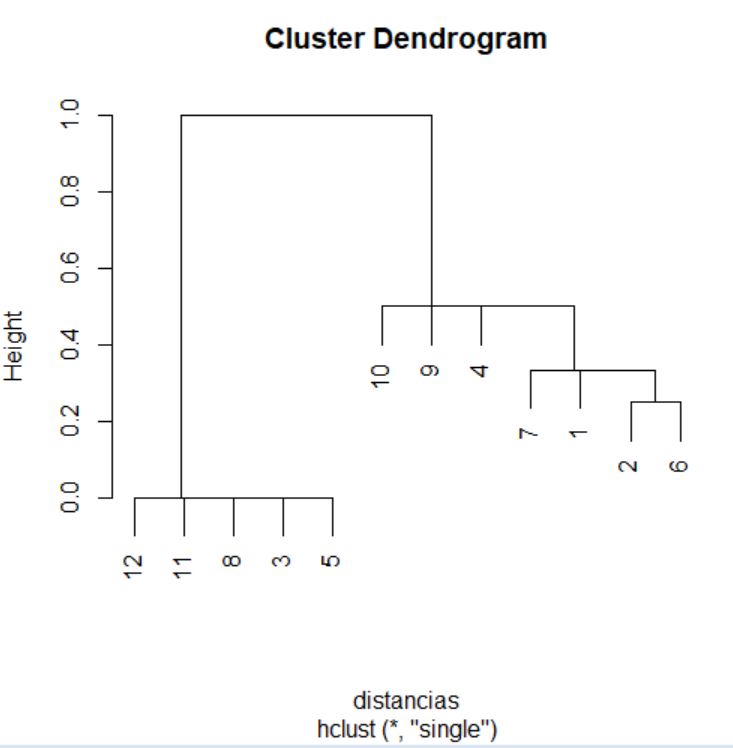

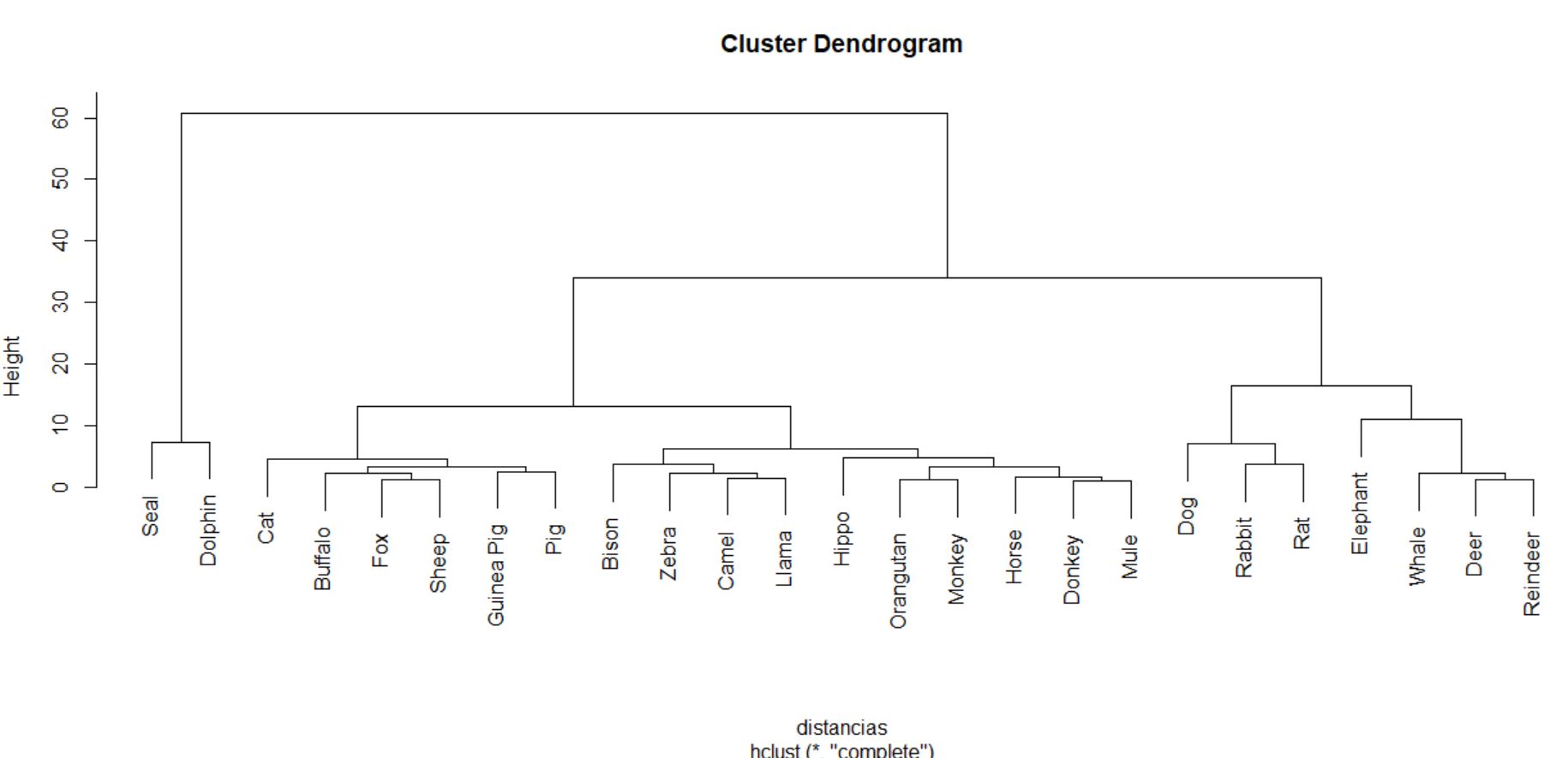

Supuesto práctico 5: Análisis clúster jerárquico en R con variables mixtas

Los ejemplos que se han realizado hasta ahora realizaban los clúster a partir de un conjunto de variables las cuales eran, o todas numéricas o todas dicotómicas. En la práctica, los grupos en un análisis clúster suelen crear a partir de conjuntos de variables en los que aparecen ambos tanto unas como otras de forma simultánea. Como ejemplo tenemos este supuesto práctico:

Se dispone de una versión ampliada del conjunto de datos utilizado en el supuesto 1, la cual, además de las variables numéricas del conjunto original, contiene las siguientes variables:

- Tipo del automóvil: manual (0) o automático (1).

- Combustible del automóvil: gasolina (0) o diesel (1).

Realizar un análisis de conglomerados jerárquico utilizando el método el promedio entre grupos a partir de todas las variables numéricas y de las dos variables dicotómicas que se acaban de presentar.

Los datos se encuentran en el fichero ventas_vehiculos_ext.txt.

Tabla3: Datos del Supuesto Práctico 4

Recordar que el fichero con el que se trabaja debe estar situado en el directorio de trabajo

> setwd(“C:/Users/Usuario/Desktop/Datos”) # Nos situamos en el directorio donde se encuentra el fichero de datos

> datos <- read.table(“ventas_vehiculos_ext.txt”, header = TRUE) # Importamos los datos

Creamos un data frame con las variables que utilizaremos para formar los clústers.

> attach(datos)

> variables <- data.frame (Precio, Motor, CV, Pisada, Ancho, Largo, Peso_neto, Deposito, MPG, Tipo, Combustible)

> variables

Precio Motor CV Pisada Ancho Largo Peso_neto Deposito MPG Tipo Combustible

1 13.260 2.2 115 104.1 67.9 180.9 2.676 14.3 27 1 0

2 16.535 3.1 170 107.0 69.4 190.4 3.051 15.0 25 0 1

3 18.890 3.4 180 110.5 73.0 200.0 3.389 17.0 27 0 0

4 21.560 3.8 190 101.3 73.1 183.2 3.203 15.7 24 0 0

5 17.885 3.0 155 108.5 73.0 197.6 3.368 16.0 24 0 1

6 12.315 2.0 107 103.0 66.9 174.8 2.564 13.2 30 1 1

7 12.885 1.6 106 103.2 67.1 175.1 2.339 11.9 32 1 1

8 15.350 2.3 135 106.9 70.3 188.8 2.932 17.1 27 1 0

9 19.720 3.4 175 107.0 70.4 186.3 3.091 15.2 25 0 0

10 13.108 1.8 120 97.0 66.7 174.0 2.420 13.2 33 0 1

11 17.518 2.2 133 105.2 70.1 188.5 2.998 18.5 27 0 1

No es posible utilizar la función dist para calcular las distancias entre los vehículos, puesto que los distintos tipos de distancia que nos ofrece esta función sólo son válidas cuando todas las variables son numéricas o cuando todas son dicotómicas. En el caso de que el conjunto de datos esté constituido por variables de ambos tipos, se recomienda utilizar una distancia alternativa, conocida como distancia de Gower. Para calcular distancias entre individuos en R mediante el método de Gower se debe utilizar la función daisy, que forma parte del paquete cluster. La sintaxis de esta función es la siguiente:

daisy(x, metric = “euclidean”, type)

donde

- x es, bien una matriz o bien un data frame con los valores de las variables a partir de las cuales se realizará el análisis clúster.

- metric es una cadena de caracteres usada para calcular la distancia entre observaciones. Los posibles valores para este parámetro son “euclidean”, para la distancia euclídea (valor por defecto), “manhattan”, para la distancia Manhattan y “gower” para la distancia de Gower. Si el data frame contiene variables no numéricas, la función utiliza la distancia de Gower de forma automática.

- type es una lista en donde hay que indicar la posición de las variables dicotómicas, indicando si son simétricas (symm) o asimétricas (asymm).

Calculemos las distancias de Gower para los vehículos de nuestro conjunto de datos.

> distancias <- daisy(variables, metric = “gower”, type = list(symm = c(10,11))) # puede necesitar instalar algún paquete

> distancias

Dissimilarities :

1 2 3 4 5 6 7 8 9 10

2 0.44709986

3 0.54744953 0.32257190

4 0.51578552 0.33991073 0.24003425

5 0.57774205 0.17137419 0.21213172 0.31665610

6 0.21521619 0.48049787 0.76266573 0.71618690 0.61114007

7 0.27957459 0.54485627 0.82702412 0.78323890 0.67549846 0.08604171

8 0.18762940 0.34288988 0.36257495 0.44359489 0.42041568 0.40284560 0.46720399

9 0.41140477 0.17479442 0.19277213 0.16511631 0.27877349 0.62662096 0.69097936 0.29359948

10 0.39215788 0.46479887 0.74696672 0.67759227 0.59544106 0.20985336 0.20281705 0.56896478 0.61092196

11 0.39412986 0.18860741 0.37646017 0.43248658 0.25248272 0.42752787 0.49188627 0.24976927 0.30538679 0.41182887

Metric : mixed ; Types = I, I, I, I, I, I, I, I, I, S, S

Number of objects : 11

En este caso, hemos indicado que las variables de las columnas 10 (Tipo) y 11 (Combustible) son variables dicotómicas simétricas, es decir, variables en las cuales no hay preferencia por qué valor se codifique como 0 y cuál se codifique como 1.

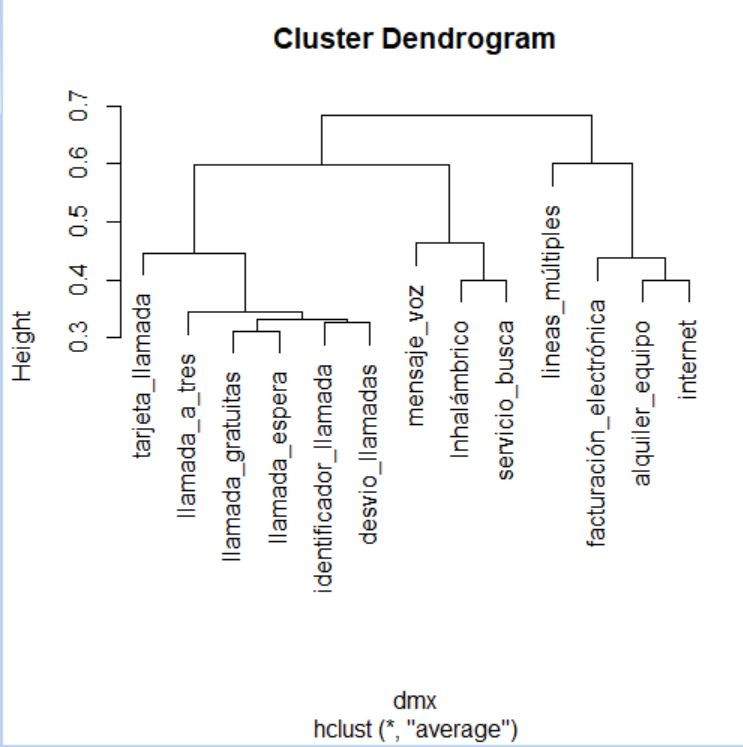

Una vez calculadas las distancias, procedemos a llamar a la función hclust, tal y como lo hemos hecho en ejemplos anteriores.

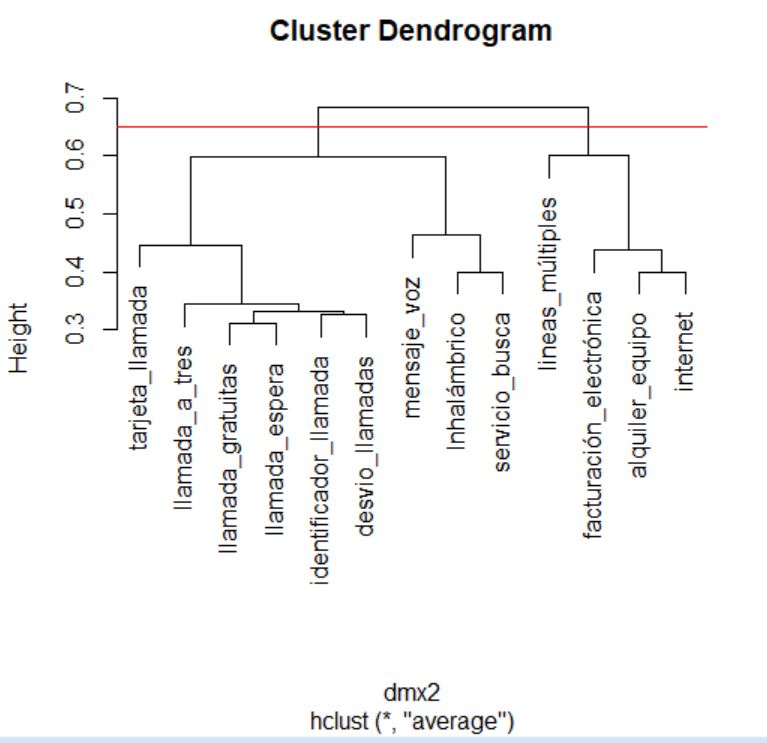

> cluster <- hclust(distancias, method = “average”)

> cluster

Call:

hclust(d = distancias, method = “average”)

Cluster method : average

Number of objects: 11

A continuación, accedemos al historial de conglomeración, consultando el componente merge del objeto que nos ha devuelto la función hclust.

> cluster$merge

[,1] [,2]

[1,] -6 -7

[2,] -4 -9

[3,] -2 -5

[4,] -1 -8

[5,] -10 1

[6,] -3 2

[7,] -11 3

[8,] 6 7

[9,] 4 5

[10,] 8 9

El historial de conglomeración se interpreta del mismo modo que en ejemplos anteriores. Así, podemos decir que en el primer paso se agrupan los vehículos situados en las posiciones 6 y 7 del conjunto de datos. Del mismo modo, en la segunda etapa se unen en un grupo las observaciones situadas en las posiciones 4 y 9 del conjunto de datos. El proceso de agrupación continúa hasta que, en el décimo paso, se aúnan los grupos formados en las etapas 8 y 9 del proceso.

Vamos a consultar ahora las distancias a las que se producen los agrupamientos. Para ello, accedemos al componente height del objeto cluster.

> cluster$height

[1] 0.08604171 0.16511631 0.17137419 0.18762940 0.20633520 0.21640319 0.22054506 0.30657465 0.38766051 0.53840428

En este ejemplo, los primeros vehículos que se unen están separados por una distancia de 0,08604 unidades, mientras que el último agrupamiento se produce a una distancia de 0,5384 unidades.

Para terminar, representamos el dendrograma asociado.

> plot(cluster)

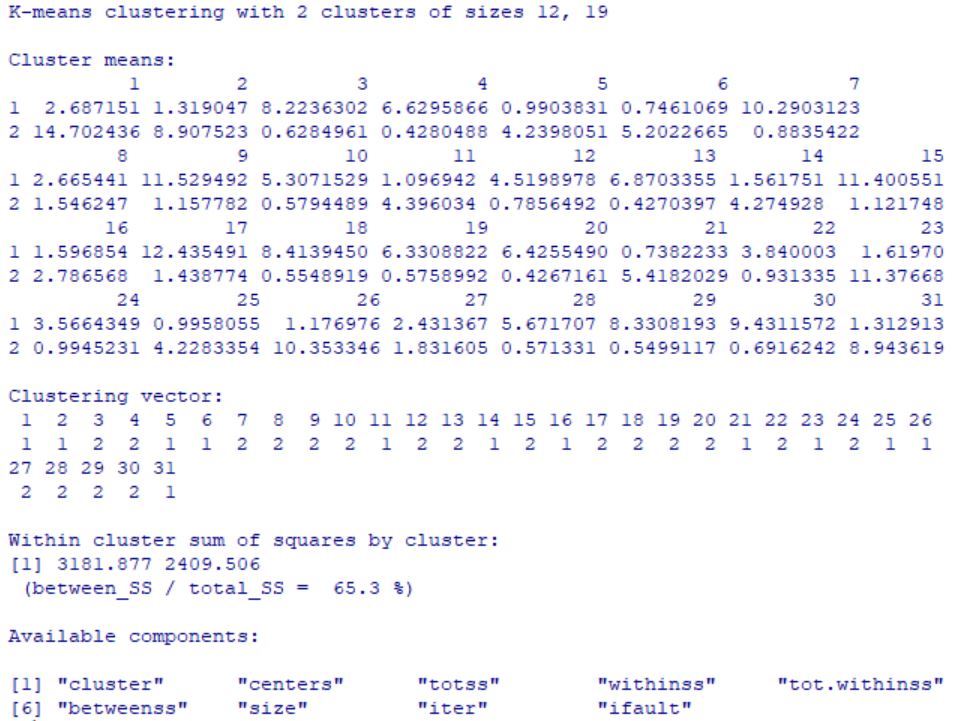

Análisis clúster de k-medias

Análisis clúster de K-medias es una herramienta diseñada para asignar los casos a un número fijo de grupos, cuyas características no se conocen, pero se basan en un conjunto de variables que deben ser cuantitativas. Es muy útil cuando se quiere clasificar un gran número de casos. Es un método de agrupación de casos que se basa en las distancias existentes entre ellos en un conjunto de variables cuantitativas. Este método de aglomeración no permite agrupar variables. El objetivo de optimalidad que se persigue es “maximizar la homogeneidad dentro de los grupos.”

Es el método que se usa más habitualmente, es fácil de programar y da resultados razonables. Tiene por objetivo separar las observaciones en K clúster, de manera que cada dato pertenezca a un grupo y sólo a uno. El algoritmo busca con un método iterativo:

-

Los centroides (medias, medianas,… ) de los K clusters

-

Asigna cada individuo a un clúster.

El algoritmo requiere que se especifique el número de conglomerados, también se puede especificar los centros iniciales de los clusters si conoce de antemano dicha información.

En este método, la medida de distancia o de similaridad entre los casos se calcula utilizando la distancia euclídea. Es muy importante el tipo de escala de las variables, si las variables tienen diferentes escalas (por ejemplo, una variable se expresa en dólares y otra en años), los resultados podrían ser equívocos. En estos casos, se debería considerar la estandarización de las variables antes de realizar el análisis de conglomerados de k-medias.

Este procedimiento supone que se ha seleccionado el número apropiado de conglomerados y que se han incluido todas las variables relevantes. Si se ha seleccionado un número inapropiado de conglomerados o se han omitido variables relevantes, los resultados podrían ser equívocos.

Existen varias formas de implementarlo pero todas ellas siguen, básicamente, los siguientes pasos:

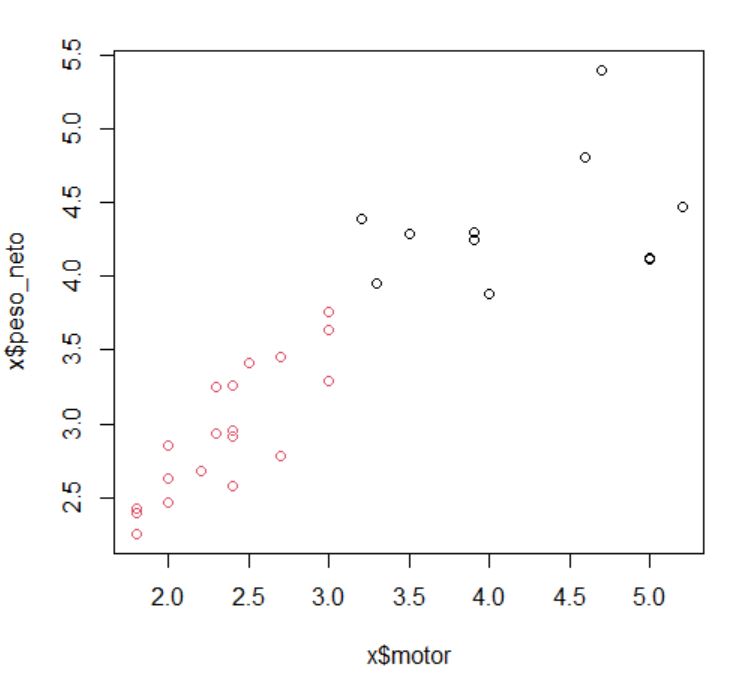

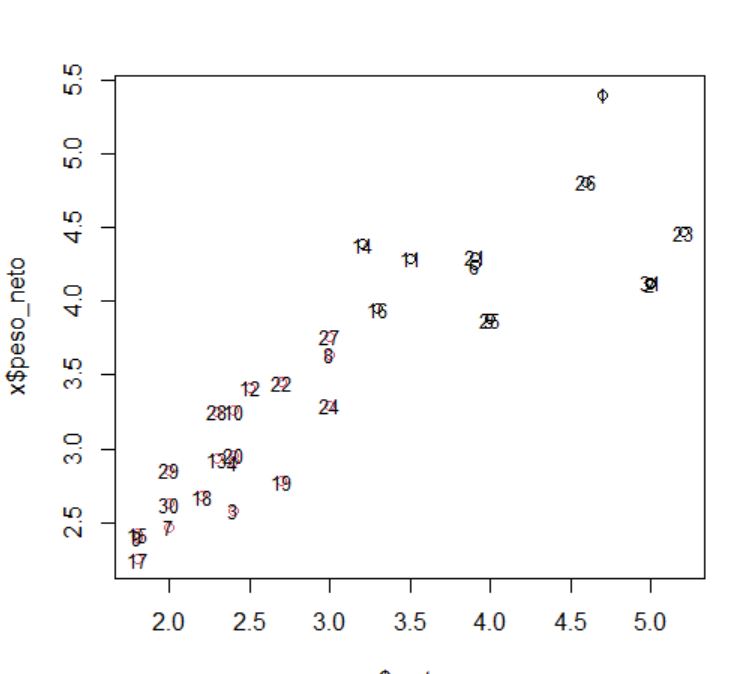

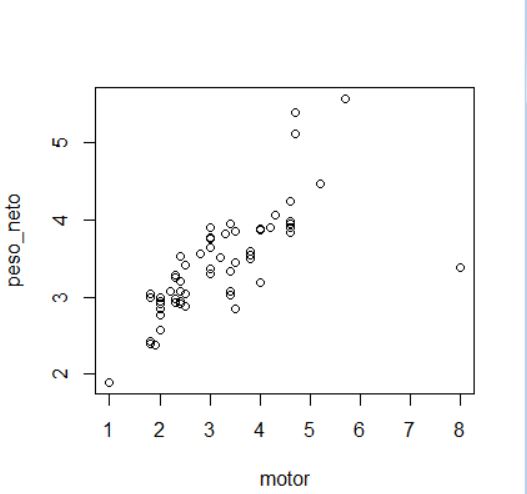

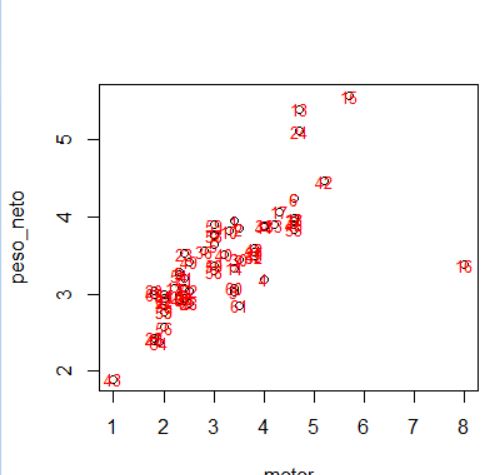

-