CONTRASTES DE HIPÓTESIS

Objetivos

- Resolver contrastes de hipótesis para la media de una población normal con varianza conocida

- Resolver contrastes de hipótesis para la media de una población normal con varianza desconocida

- Resolver contrastes de hipótesis para una proporción

- Resolver contrastes de hipótesis para la diferencia de medias en dos poblaciones normales independientes con varianzas desconocidas

- Suponiendo que las varianzas, aun siendo desconocidas, son iguales en las dos poblaciones

- Suponiendo que las varianzas son diferentes en las dos poblaciones

- Resolver contrastes de hipótesis para la diferencia de medias en dos poblaciones normales relacionadas

- Resolver contrastes de hipótesis para la diferencia de proporciones

- Resolver contrastes de hipótesis no-paramétricos de independencia para variables cualitativas

- Resolver contrastes de hipótesis no-paramétricos de bondad de ajuste de distribuciones

- Resolver contrastes de hipótesis no-paramétricos de aleatoriedad

- Resolver contrastes de hipótesis no-paramétricos de dos muestras independientes y de dos muestras relacionadas.

- APÉNDICE: Introducción al Análisis de datos categóricos: Tablas de Contingencia.

Conceptos básicos

Contraste de hipótesis. Un contraste de hipótesis (también conocido como test de hipótesis) es una técnica estadística que se utiliza para comprobar la validez de una afirmación en base a la información recogida en una muestra de observaciones. Es un proceso estadístico mediante el cual se investiga si una propiedad que se supone que cumple una población es compatible con lo observado en una muestra de dicha población. Es un procedimiento que permite elegir una hipótesis de trabajo de entre dos posibles y antagónicas.

Hipótesis Estadística. Todo contraste de hipótesis se basa en la formulación de dos hipótesis exhaustivas y mutuamente exclusivas:

- Hipótesis nula (\( H_0 \))

- Hipótesis alternativa (\( H_1 \))

La afirmación cuya validez se pretende comprobar recibe el nombre de hipótesis nula y se denota mediante \( H_0 \). La hipótesis nula de un contraste habitualmente hace referencia al valor poblacional de un parámetro o a la distribución de probabilidad de una variable. En los casos en los que la información de la muestra no apoya la hipótesis nula, se da por veraz una afirmación alternativa, que se conoce como hipótesis alternativa, y se denota por \( H_1 \). La hipótesis alternativa es la negación de la hipótesis nula. Así, por ejemplo, en un contraste sobre los valores poblaciones de un parámetro, en la hipótesis alternativa se recogen todos los posibles valores del parámetro que no figuran en la hipótesis nula. Igualmente, cuando se contrasta la distribución de probabilidad de una variable, en la hipótesis alternativa se incluyen todas las distribuciones de probabilidad que no se han considerado en la hipótesis nula. De aquí se deduce que la hipótesis nula y la hipótesis alternativa son exhaustivas y mutuamente excluyentes.

La hipótesis \( H_0 \) es la que se desea contrastar. Consiste generalmente en una afirmación concreta sobre la forma de una distribución de probabilidad o sobre el valor de alguno de los parámetros de esa distribución. El nombre de “nula” significa “sin valor, efecto o consecuencia”, lo cual sugiere que \( H_0 \) debe identificarse con la hipótesis de no cambio (a partir de la opinión actual); no diferencia, no mejora, etc. \( H_0 \) representa la hipótesis que mantendremos a no ser que los datos indiquen su falsedad, y puede entenderse, por tanto, en el sentido de “neutra”. La hipótesis \( H_0 \) nunca se considera probada, aunque puede ser rechazada por los datos. Por ejemplo, la hipótesis de que dos poblaciones tienen la misma media puede ser rechazada fácilmente cuando ambas difieren mucho, analizando muestras suficientemente grandes de ambas poblaciones, pero no puede ser “demostrada” mediante muestreo, puesto que siempre cabe la posibilidad de que las medias difieran en una cantidad lo suficientemente pequeña para que no pueda ser detectada, aunque la muestra sea muy grande. Dado que descartaremos o no la hipótesis nula a partir de muestras obtenidas (es decir, no dispondremos de información completa sobre la población), no será posible garantizar que la decisión tomada sea la correcta.

La hipótesis \( H_1 \) es la negación de la nula. Incluye todo lo que \( H_0 \) excluye.

¿Qué asignamos como \( H_0 \) y \( H_1 \)?

La hipótesis \( H_0 \) asigna un valor específico al parámetro en cuestión y por lo tanto “el igual” siempre forma parte de \( H_0 \).

La idea básica de la prueba de hipótesis es que los hechos tengan probabilidad de rechazar \( H_0 \). La hipótesis \( H_0 \) es la afirmación que podría ser rechazada por los hechos. El interés del investigador se centra, por lo tanto, en la \( H_1 \).

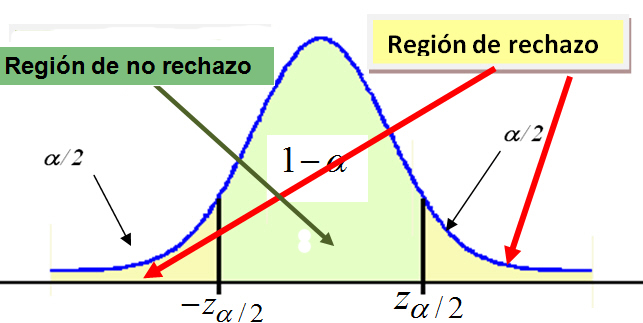

La regla de decisión. Es el criterio que vamos a utilizar para decidir si la hipótesis nula planteada debe o no ser rechazada. Este criterio se basa en la partición de la distribución muestral del estadístico de contraste en dos regiones o zonas mutuamente excluyentes: Región crítica o región de rechazo y Región de no-rechazo.

Región de no-rechazo. Es el área de la distribución muestral que corresponde a los valores del estadístico de contraste próximos a la afirmación establecida en \( H_0 \). Es decir, los valores del estadístico de contraste que nos conducen a decidir \( H_0 \). Es por tanto, el área correspondiente a los valores del estadístico de contraste que es probable que ocurran si \( H_0 \) es verdadera. Su probabilidad se denomina nivel de confianza y se representa por 1 – α .

Región de rechazo o región crítica. Es el área de distribución muestral que corresponde a los valores del estadístico de contraste que se encuentran tan alejados de la afirmación establecida en \( H_0 \), que es muy poco probable que ocurran si \( H_0 \) es verdadera. Su probabilidad se denomina nivel de significación o nivel de riesgo y se representa con la letra α .

Ya definidas las dos zonas, la regla de decisión consiste en rechazar \( H_0 \) si el estadístico de contraste toma un valor perteneciente a la zona de rechazo, o mantener \( H_0 \) si el estadístico de contraste toma un valor perteneciente a la zona de no-rechazo.

El tamaño de las zonas de rechazo y no-rechazo se determina fijando el valor de α, es decir, fijando el nivel de significación con el que se desea trabajar. Se suele tomar un 1% o un 5%.

La forma de dividir la distribución muestral en zona de rechazo y de no-rechazo depende de si el contraste es bilateral o unilateral. La zona crítica debe situarse donde puedan aparecer los valores muestrales incompatibles con H0.

Estadístico de contraste. Un estadístico de contraste es un resultado muestral que cumple la doble condición de:

- Proporcionar información empírica relevante sobre la afirmación propuesta en la \( H_0 \).

- Poseer una distribución muestral conocida

Tipos de contrastes.

Contrastes paramétricos: Conocida una v.a. con una determinada distribución, se establecen afirmaciones sobre los parámetros de dicha distribución.

Contrastes no paramétricos: Las afirmaciones establecidas no se hacen en base a la distribución de las observaciones, que a priori es desconocida.

Tipos de hipótesis del contraste.

Existen dos tipos de contrastes de hipótesis en función de la forma que adopten las hipótesis: los contrastes bilaterales y los contrastes unilaterales. En los contrastes bilaterales la hipótesis nula es una igualdad mientras que en los contrastes unilaterales en la hipótesis nula aparece una desigualdad no estricta. Cualquiera que sea el caso, es importante notar que en la hipótesis nula siempre debe aparecer un signo de igualdad, ya sea como una igualdad en sí (=) o como una desigualdad no estricta (\( \leq \) o \( \geq \)). A modo de ejemplo, veamos los tipos de contrastes de hipótesis para la media de una variable que pueden darse.

\( \begin{array} {|c|} \hline Contraste \hspace{.1cm} bilateral \\ \hline H_0 \equiv \mu = \mu_0 \\ \hline H_1 \equiv \mu \neq \mu_0 \\ \hline \end{array} \) \( \hspace{2cm} \begin{array} {|c||} \hline Contrastes \hspace {.1cm}unilaterales \\ \hline H_0 \equiv \mu \geq \mu_0 \hspace{2cm} H_0 \equiv \mu \leq \mu_0 \\ \hline H_1 \equiv \mu < \mu_0 \hspace{2cm} H_1 \equiv \mu > \mu_0 \\ \hline \end{array} \)

Figura 1: Tipo de contrastes de hipótesis

El planteamiento de un contraste de hipótesis es el paso previo a su resolución. Plantear un contraste de hipótesis consiste en definir la hipótesis nula y la hipótesis alternativa.

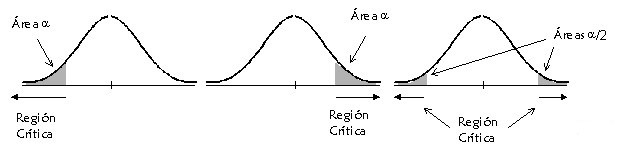

Una vez planteado el contraste, se calcula el valor del estadístico de contraste. Un estadístico de contraste es una función de los datos muestrales cuya distribución de probabilidad es conocida en las condiciones que establece la hipótesis nula. Es decir, el estadístico de contraste, \( T \), se calcula a partir de una muestra de tamaño \( n \), \( X_1,X_2,…, X_n \), de la variable de interés, \( X \) , como \( T = f(X_1,X_2,…, X_n) \). En función del valor de \( T \), optaremos por rechazar, o no, la hipótesis nula. Concretamente, los valores de \( T \) con probabilidades pequeñas de haber sido obtenidos bajo las condiciones que establece la hipótesis nula nos harán pensar que dicha hipótesis no es cierta en realidad y, consecuentemente, nos llevarán a rechazarla. El conjunto de todos los valores del estadístico de contraste que nos llevan a rechazar la hipótesis nula recibe el nombre de región de rechazo o región crítica. Por el contrario, el conjunto de los valores del estadístico de contraste que nos hacen no rechazar la hipótesis nula se denomina región de aceptación. La localización de la región crítica depende del tipo de contraste que se plantee, tal y como se muestra en la siguiente figura.

Figura 2: Localización de la región crítica

Las dos primeras imágenes muestran las regiones críticas para contrastes unilaterales. Concretamente, la primera imagen se corresponde con el caso de un contraste de hipótesis con hipótesis alternativa del tipo <, mientras que la región crítica de la segunda imagen se corresponde con un contraste de hipótesis con hipótesis alternativa del tipo >. Por último, en la tercera imagen representa la región crítica para un contraste con hipótesis alternativa del tipo \( \neq \). En cualquier caso, los valores de la región crítica son aquellos que menos probabilidad tienen de ocurrir suponiendo cierta la hipótesis nula.

Hipótesis simples: La hipótesis asigna un único valor al parámetro desconocido, \( H \equiv \theta = \theta_0 \)

Hipótesis compuestas: La hipótesis asigna varios valores posibles al parámetro desconocido, \( H \equiv \theta \in ( \theta_1, \theta_2) \)

En términos generales: Dada una variable aleatoria \( X \) que se distribuye según una ley de probabilidad \( Ϝ(\theta) \) que depende de un parámetro θ. Supongamos que el parámetro \( \theta \) es desconocido y que \( \theta_0 \) es el valor propuesto para \( \theta \). El contraste consiste en elegir, en alguno de los contrastes siguientes, entre la hipótesis \( H_0 \) o \( H_1 \).

\( \begin{array}{ccccc} H_0 \equiv \theta \leq \theta_0 & & H_0 \equiv θ \geq θ_0 & & H_0 \equiv θ = θ_0 \\ & o & & o & \\ H_1 \equiv \theta > \theta_0 & & H_1 \equiv θ < θ_0 & & H_1 \equiv θ \neq θ_0 \end{array} \)

Nota: Consideramos la hipótesis \( H_0 \) simple y la hipótesis \( H_1 \) compuesta.

- En los dos primeros contrastes, en los que la hipótesis alternativa es: \( H_1≡ θ>θ_0 \) o \( H_1 ≡ θ<θ_0 \), se dice que la Hipótesis Alternativa es Unilateral, ya que los posibles valores de \( θ \) bajo \( H_1 \) están situados a un lado del valor propuesto bajo \( H_0 \) y la región crítica recibe el nombre de Región crítica o de Rechazo Unilateral. (La hipótesis \( H_1 \) da lugar a una región crítica a un solo lado del valor del parámetro).

- En el tercer contraste, en el que la hipótesis alternativa es de la forma \( H_1≡ θ \neq θ_0 \), se dice que la Hipótesis Alternativa es Bilateral y la región crítica también recibe el nombre de Región Crítica Bilateral. (La hipótesis \( H_1 \) da lugar a una región crítica a ambos lados del valor del parámetro).

\( \begin{array}{||c|c||} \hline \begin{array}{c}H_0 \equiv \theta = \theta_0 \\ H_1 \equiv \theta \neq \theta_0 \end{array}& Simple – Compuesta \\ \hline \begin{array}{c}H_0 \equiv \theta \leq \theta_0 \\ H_1 \equiv \theta > \theta_0 \end{array}& Compuesta – Compuesta \\ \hline \begin{array}{c}H_0 \equiv \theta \geq \theta_0 \\ H_1 \equiv \theta < \theta_0 \end{array} & Compuesta – Compuesta \\ \hline \end{array} \)

Figura 3: Tipos de Hipótesis

El tamaño de la región de rechazo lo establece el investigador. Es decir, el investigador decide a partir de qué valor del estadístico de contraste va a rechazar la hipótesis nula. O en otras palabras, identifica cuáles son los valores que son poco probables de ocurrir bajo la hipótesis nula. El valor del estadístico de contraste a partir del cual se rechaza la hipótesis nula recibe el nombre de valor crítico. A la probabilidad de los valores de la región crítica se le conoce como nivel de significación y se denota mediante α. Al valor 1-α se le conoce como nivel de confianza.

La resolución del contraste se hace en función de un criterio que se conoce como regla de decisión. La regla de decisión nos dice que se ha de rechazar la hipótesis nula en favor de la hipótesis alternativa cuando el valor del estadístico de contraste caiga dentro de la región de rechazo. En caso contrario, no se rechazará la hipótesis nula y se considerará cierta. En otras palabras, rechazaremos la hipótesis nula siempre y cuando el valor del estadístico de contraste sea mayor al valor crítico.

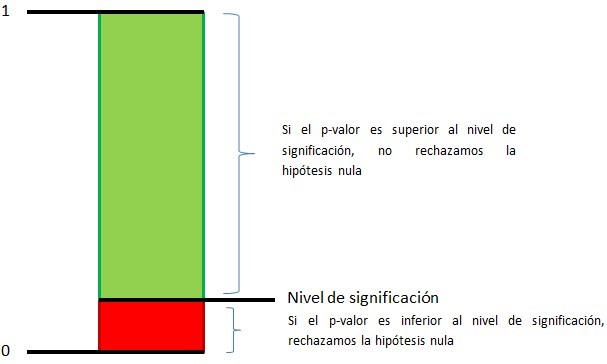

Equivalentemente, se puede resolver un contraste a partir de una probabilidad que recibe el nombre de p-valor. El p-valor de un contraste de hipótesis nos indica cuál es la probabilidad de obtener un valor del estadístico de contraste tanto o más “extraño” que el que se ha obtenido suponiendo que la hipótesis nula es cierta. Por tanto, p-valores pequeños nos llevarán a rechazar la hipótesis nula. Concretamente, si el p-valor obtenido es más pequeño que el nivel de significación, rechazaremos la hipótesis nula. En caso contrario, no podremos rechazar la hipótesis nula y la consideraremos verdadera.

Figura 4: Representación del rechazo y no rechazo de la hipótesis nula en función del p-valor

La Reglas de decisión.

- Contrastes bilaterales: Si la hipótesis alternativa da lugar a una región crítica “a ambos lados” del valor del parámetro, diremos que el test es bilateral o de dos colas.

Se rechaza H0 si el estadístico de contraste cae en la zona crítica, es decir, si el estadístico de contraste toma un valor tan grande o tan pequeño que la probabilidad de obtener un valor tan extremo o más que el encontrado es menor que α /2.

Figura 5: Regiones de rechazo y no rechazo

Figura 5: Regiones de rechazo y no rechazo

- Contraste unilateral: Si la hipótesis alternativa da lugar a una región crítica “a un solo lado del valor del parámetro”, diremos que el test es unilateral o de una sola cola

Se rechaza \( H_0 \) si el estadístico de contraste cae en la zona crítica, es decir, si toma un valor tan grande que la probabilidad de obtener un valor como ese o mayor es menor que α .

|

Contraste bilateral \( H_0 \equiv \theta = \theta_0 \) \( H_1 \equiv \theta \neq \theta_0 \) |

Contraste unilateral: Cola a la derecha \( H_0 \equiv \theta ≤ \theta_0 \) \( H_1 \equiv \theta > \theta_0 \) |

Contraste unilateral: Cola a la izquierda \( H_0 \equiv \theta ≥ \theta_0 \) \( H_1 \equiv \theta < \theta_0 \) |

La decisión:

Planteada la hipótesis, formulados los supuestos, definido el estadístico de contraste y su distribución muestral, y establecida la regla de decisión, el paso siguiente es obtener una muestra aleatoria de tamaño n, calcular el estadístico de contraste y tomar una decisión:

- Si es estadístico de contraste cae en la zona crítica se rechaza \( H_0 \).

- Si es estadístico cae en la zona de no rechazo se mantiene \( H_0 \).

Si rechazamos Ho afirmamos que la hipótesis es falsa, es decir, que afirmamos con una probabilidad α de equivocarnos que esa hipótesis es falsa. Por el contrario, si no la rechazamos, no estamos afirmando que la hipótesis sea verdadera. Simplemente que no tenemos evidencia empírica suficiente para rechazarla y que se considera compatible con los datos.

Como conclusión, si se mantiene o no se rechaza \( H_0 \), nunca se puede afirmar que es verdadera.

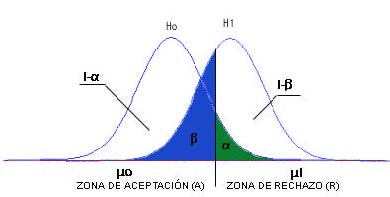

Errores de Tipo I y II.

-

Error de tipo I: Se comete cuando se decide rechazar la hipótesis nula \( H_0 \) que en realidad es verdadera. La probabilidad de cometer ese error es α.

\( P[Rechazar \hspace{.1cm} H_0 / H_0 \hspace{.1cm} es \hspace{.1cm} cierta]=α \hspace{.1cm}; \hspace{.1cm} 0 \leq α \leq 1 \)

-

Error de tipo II: Se comete cuando se decide no rechazar la hipótesis nula \( H_0 \) que en realidad es falsa. La probabilidad de cometer ese error es β .

\( P[No\hspace{.1cm} rechazar \hspace{.1cm} H_0 / H_0 \hspace{.1cm} es \hspace{.1cm} falsa] =β \hspace{.1cm} ; \hspace{.1cm} 0 \leq β \leq 1 \)

Por tanto,

- 1 – α es la probabilidad de tomar una decisión correcta cuando \( H_0 \) es verdadera.

- 1 – β es la probabilidad de tomar una decisión correcta cuando \( H_0 \) es falsa.

En la tabla siguiente presentamos las decisiones y posibles errores que se pueden cometer

\( \begin{array}{||l|cc||} \hline & \hspace{5cm} Decisión \\ \hline & Rechazar \hspace{.1cm} H_0 & No \hspace{.1cm} rechazar H_0 \\ \hline Hipótesis \hspace{.1cm} cierta \hspace{.1cm} H_0 & \begin{array}{c} Error \hspace{.1cm} de \hspace{.1cm} tipo \hspace{.1cm}I \\ P = α \end{array} & \begin{array}{c} Decisión \hspace{.1cm} correcta \\ P = 1- \beta \end{array} \\ \hline Hipótesis \hspace{.1cm} falsa \hspace{.1cm} H_0 & \begin{array}{c} Decisión \hspace{.1cm} correcta \\ P = 1-\alpha \end{array} & \begin{array}{c} Error \hspace{.1cm} de \hspace{.1cm} tipo \hspace{.1cm}II \\ P = β \end{array} \\ \hline \end{array} \)

Figura 7: Cuadro tipos de errores

- La dificultad al usar un procedimiento basado en datos muestrales es que debido a la variabilidad de muestreo, puede resultar una muestra no representativa, y por tanto, resultaría un rechazo erróneo de H0.

- La probabilidad de cometer un error de tipo I con nuestra decisión es una probabilidad conocida, pues el valor de α lo fija el propio investigador.

- Sin embargo, la probabilidad de cometer un error de tipo II, β , es un valor desconocido que depende de tres factores:

-

- La hipótesis \( H_1 \) que consideremos verdadera.

- El valor de α .

- El tamaño del error típico (desviación típica) de la distribución muestral utilizada para efectuar el contraste.

-

Figura 8: Zonas de rechazo y no rechazo

Figura 8: Zonas de rechazo y no rechazo

Relaciones entre los errores de Tipo I y II. El estudio de las relaciones entre los errores lo realizamos mediante el contraste de hipótesis:

\( \begin{array}{c} H_0 \equiv \mu = \mu_0 \\ H_1 \equiv μ = μ_1 \end{array} \)

Expresión 1: Contraste de hipótesis

Para ello utilizamos la información muestral proporcionada por el estadístico media muestral \( (\overline{X})\)

Cualquier valor atribuido a \( \mu_1 \) en \( H_1\) (siempre mayor a \( \mu_0 \)) generará distribuciones muestrales distintas para la media muestral. Aunque todas tendrán la misma forma, unas estarán más alejadas que otras de la curva de \( H_0 \), es decir, unas serán distintas de otras únicamente en el valor asignado a \( \mu_1 \).

- Cuanto mayor es \( \alpha \), menor es \( \beta \). Se relacionan de forma inversa.

-

Para una distancia dada entre \( \mu_0 \) y \( \mu_1 \), el solapamiento entre las curvas correspondientes a uno y otro parámetro será tanto mayor cuanto mayor sea el error típico de la distribución muestral representada por esas curvas (cuanto mayor es el error típico de una distribución, más ancha es esa distribución). Y cuanto mayor sea el solapamiento, mayor será el valor de \( \beta \).

En lugar de buscar procedimientos libres de error, debemos buscar procedimientos para los que no sea probable que ocurran ningún tipo de estos errores. Esto es, un buen procedimiento es aquel para el que es pequeña la probabilidad de cometer cualquier tipo de error. La elección de un valor particular de corte de la región de rechazo fija las probabilidades de errores tipo I y tipo II.

Debido a que \( H_0 \) especifica un valor único del parámetro, hay un solo valor de \( \alpha \). Sin embargo, hay un valor diferente de \( \beta \) por cada valor del parámetro recogido en \( H_1 \).

En general, un buen contraste o buena regla de decisión debe tender a minimizar los dos tipos de error inherentes a toda decisión. Como \( \alpha \) queda fijado por el investigador, trataremos de elegir una región donde la probabilidad de cometer el error de tipo II sea la menor .

Usualmente, se diseñan los contrastes de tal manera que la probabilidad a sea el 5% (0,05), aunque a veces se usan el 10% (0,1) o 1% (0,01) para adoptar condiciones más relajadas o más estrictas.

Potencia de un contraste. Es la probabilidad de decidir \( H_1 \) cuando ésta es cierta

\( P[decidir \hspace{.1cm} H_1 / H_1 \hspace{.1cm} es \hspace{.1cm} verdadera]=1- \beta \)

El concepto de potencia se utiliza para medir la bondad de un contraste de hipótesis. Cuanto más lejana se encuentra la hipótesis \( H_1 \) de \( H_0 \) menor es la probabilidad de incurrir en un error tipo II y, por consiguiente, la potencia tomará valores más próximos a 1.

Si la potencia en un contraste es siempre muy próxima a 1 entonces se dice que el estadístico de contraste es muy potente para contrastar \( H_0 \) ya que en ese caso las muestras serán, con alta probabilidad, incompatibles con \( H_0 \) cuando \( H_1 \) sea cierta.

Por tanto puede interpretarse la potencia de un contraste como su sensibilidad o capacidad para detectar una hipótesis alternativa. La potencia de un contraste cuantifica la capacidad del criterio utilizado para rechazar \( H_0 \) cuando esta hipótesis sea falsa

Es deseable en un contraste de hipótesis que las probabilidades de ambos tipos de error fueran tan pequeñas como fuera posible. Sin embargo, con una muestra de tamaño prefijado, disminuir la probabilidad del error de tipo I, α, conduce a incrementar la probabilidad del error de tipo II, β. El recurso para aumentar la potencia del contraste, esto es, disminuir la probabilidad de error de tipo II, es aumentar el tamaño muestral lo que en la práctica conlleva un incremento de los costes del estudio que se quiere realizar

El concepto de potencia nos permite valorar cual entre dos contrastes con la misma probabilidad de error de tipo I, α, es preferible. Se trata de escoger entre todos los contrastes posibles con α prefijado aquel que tiene mayor potencia, esto es, menor probabilidad β de incurrir en el error de tipo II. En este caso el Lema de Neyman-Pearson garantiza la existencia de un contraste de máxima potencia y determina cómo construirlo.

Potencia de un contraste de hipótesis

Contrastes de hipótesis paramétricos

El propósito de los contrastes de hipótesis es determinar si un valor propuesto (hipotético) para un parámetro u otra característica de la población debe aceptarse como plausible con base en la evidencia muestral.

Podemos considerar las siguientes etapas en la realización de un contraste:

-

-

El investigador formula una hipótesis sobre un parámetro poblacional, por ejemplo que toma un determinado valor

-

Selecciona una muestra de la población

-

Comprueba si los datos están o no de acuerdo con la hipótesis planteada, es decir, compara la observación con la teoría

- Si lo observado es incompatible con lo teórico entonces el investigador puede rechazar la hipótesis planteada y proponer una nueva teoría

- Si lo observado es compatible con lo teórico entonces el investigador puede continuar como si la hipótesis fuera cierta.

-

Contrastes de hipótesis para la media de una población normal

El objetivo es probar uno de los siguientes contrastes de hipótesis con respecto de μ

\( \begin{array}{ccccc} H_0 \equiv \mu = \mu_0 & & H_0 \equiv μ \leq μ_0 & & H_0 \equiv μ \geq μ_0 \\ & o & & o & \\ H_1 \equiv μ \neq μ_0 & & H_1 \equiv μ > μ_0 & & H_1 \equiv μ < μ_0 \end{array} \)

Expresión 2: Tipos de contrastes de hipótesis

donde \( μ_0 \) es un valor conocido dado de antemano. Para ello se toma una m.a.s concreta \( x_1, x_2, \cdots , x_{n} \) cuya media valdrá: \( \bar {x} = \displaystyle \frac{1} {n} \displaystyle \sum_{i=1}^{n} x_{i} \)

Se distinguen dos situaciones: a) Varianza poblacional conocida y b) varianza poblacional desconocida.

Contrastes de hipótesis para la media de una población normal con Varianza conocida

El caso en el que se desea resolver un contraste de hipótesis para la media de una variable continua y, además, se conoce el valor de la varianza de dicha variable en toda las poblaciónes el más sencillo de todos y, a la vez, el menos usual.

Supongamos una muestra aleatoria \( X_1, X_2, \cdots, X_n \) de tamaño n de valores de una variable aleatoria que sigue una distribución normal de media μ desconocida, y de desviación típica σ conocida. Se plantea el siguiente contraste:

\( \begin{array}{c} H_0 \equiv \mu = \mu_0 \\ H_1 \equiv μ \neq μ_0 \end{array} \)

Expresión 3: Contraste de hipótesis bilateral

Para resolver este contraste, calculamos el siguiente estadístico de contraste:

\( Z= \displaystyle \frac {\overline{X}-μ_0} {σ/ \sqrt{n}} \)

Expresión 4: Estadístico de contraste de la media con varianza conocida

que sigue una distribución normal de media 0 y desviación típica 1 cuando la hipótesis nula es cierta. A continuación se busca el cuantil 1-α/2 de una distribución normal y se comparan ambos valores.

En el contraste de hipótesis bilateral, si el valor absoluto del estadístico de contraste es mayor que el cuantil, se rechazará la hipótesis nula. En caso contrario, no se rechazará.

En el contraste de hipótesis unilateral

- Con hipótesis alternativa del tipo <, el valor crítico \( – z_{1-α} \) y la hipótesis nula se rechaza cuando \( Z < – z_{1- α} \)

- Con hipótesis alternativa del tipo >. el valor crítico \( – z_{1-α} \) y la hipótesis nula se rechaza cuando \( Z > – z_{1- α} \)

R no incluye una función específica para la resolución de contrastes de hipótesis de este tipo. Aun así, pueden resolverse de una forma muy sencilla como se muestra en el siguiente ejemplo.

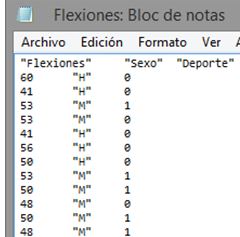

Supuesto Práctico 1

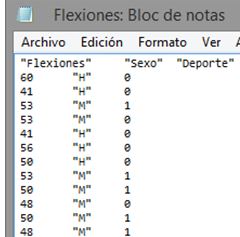

Con el fin de estudiar el número medio de flexiones continuadas que pueden realizar sus alumnos, un profesor de educación física somete a 75 de ellos, elegidos aleatoriamente, a una prueba. El número de flexiones realizado por cada alumno, así como su sexo y si realizan o no deporte fuera del horario escolar se muestran en el fichero Flexiones.txt.

Tabla1; Datos del Supuesto Práctico 1

Se sabe que el número de flexiones se distribuye según una Normal de varianza poblacional 7.5. ¿Puede asumirse, considerando un nivel de significación del 5%, que el número medio de flexiones que realizan los alumnos es de 55?

El contraste de hipótesis asociado a este ejercicio es

\( \begin{array}{c} H_0 \equiv \mu = 55 \\ H_1 \equiv μ \neq 55 \end{array} \)

Expresión 5: Contraste de hipótesis del supuesto práctico 1

En primer lugar debemos importar en R los datos que contienen el número de flexiones realizadas por cada alumno. Para ello, utilizamos la orden read.table.

> setwd(“D:/”) # cambiar al directorio de trabajo donde están los datos

> datos<- read.table(“D:/Flexiones.txt”, header = TRUE)

> datos

Flexiones Sexo Deporte

1 60 H 0

2 41 H 0

3 53 M 1

4 53 M 0

5 41 H 0

6 56 H 0

7 50 H 0

8 53 M 1

9 50 M 1

10 48 M 0

11 50 M 1

12 48 M 1

13 56 H 0

14 52 M 1

15 54 M 0

16 50 H 1

17 50 H 0

18 54 H 0

19 52 H 1

20 48 H 0

21 48 H 1

22 35 M 1

23 50 M 1

24 41 M 1

25 56 M 1

26 52 M 1

27 56 M 0

28 54 H 1

29 53 H 0

30 53 M 0

31 53 H 0

32 41 M 1

33 48 M 0

34 50 H 1

35 50 M 1

36 52 H 0

37 53 M 0

38 35 H 0

39 35 H 0

40 54 M 0

41 46 M 1

42 48 H 0

43 50 M 0

44 48 H 0

45 41 M 0

46 48 M 1

47 60 H 1

48 53 M 0

49 54 M 1

50 56 H 1

51 50 H 1

52 41 H 0

53 60 M 1

54 60 M 1

55 54 H 0

56 54 H 0

57 53 H 0

58 35 M 0

59 54 H 0

60 48 M 0

61 50 H 0

62 54 H 0

63 54 H 0

64 53 H 0

65 52 H 0

66 50 H 0

67 52 H 0

68 48 H 1

69 46 H 1

70 53 H 0

71 50 H 0

72 35 H 0

73 50 H 1

74 60 M 1

75 50 H 0

Una vez hecho esto, introducimos en R el nivel de significación que proporciona el enunciado.

> alpha<- 0.05

A continuación, calculamos el valor del estadístico de contraste.

> alpha<- 0.05

> media<- mean(datos$Flexiones)

> mu_0 <- 55

> varianza <- 7.5

> n <- nrow(datos)

> Z<- (media – mu_0) / (sqrt(varianza)/sqrt(n))

> Z

[1] -15.47408

Y también el valor crítico, que en este caso coincide con z1-α/2, el cuantil 1-α/2 de una distribución normal de media 0 y varianza 1.

> cuantil<- qnorm(1 – alpha/2)

> cuantil

[1] 1.959964

Como el valor absoluto del estadístico de contraste (15.47408) es mayor que el valor crítico (1.959964), en este caso se rechaza la hipótesis nula en favor de la hipótesis alternativa. Es decir, no puede asumirse que el número medio de flexiones que realizan los alumnos es de 55.

Contrastes de hipótesis para la media de una población normal con Varianza desconocida

Supongamos que la varianza poblacional de la variable de interés es desconocida. Nuestro objetivo sigue siendo la resolución del contraste de hipótesis para la media de dicha variable.

\( \begin{array}{ccccc} H_0 \equiv \mu = \mu_0 & & H_0 \equiv μ \geq μ_0 & & H_0 \equiv μ \leq μ_0 \\ & o & & o & \\ H_1 \equiv μ \neq μ_0 & & H_1 \equiv μ < μ_0 & & H_1 \equiv μ > μ_0 \end{array} \)

Expresión 6: Tipos de contrastes de hipótesis

Supongamos, de nuevo, una muestra aleatoria \( X_1, X_2, \cdots, X_n \), de tamaño n de valores de la variable aleatoria que sigue una distribución normal de media \( \mu \) y desviación típica \( \sigma \), ambas desconocidas. Para resolver el contraste de hipótesis para \( \mu \) en este caso partimos del estadístico de contraste

\( T= \displaystyle \frac {\overline{X}-μ_0} {s/ \sqrt{n}} \)

Expresión 7: Expresión del estadístico de contraste

dicho estadístico sigue una distribución t de Student con n-1 grados de libertad cuando la hipótesis nula es cierta. En la fórmula anterior, s hace referencia a la cuasidesviación típica muestral.

Fijado un nivel de significación α

a) Para la hipótesis alternativa \( H_1: \mu \neq \mu_0 \) la correspondiente región de no rechazo es \( (-t_{α/2;n-1}, t_{α/2;n-1}) \) y el estadístico de contraste adopta la forma de la Expresión 7

y se utiliza la siguiente regla de decisión

\( \begin{array}{ccccc} H_0 \equiv \mu = \mu_0 & Si & t_ {exp} < t_{α/2;n-1} & \Rightarrow & No \hspace{.2cm} se \hspace{.2cm} rechaza \hspace{.2cm} H_0 \\ H_1 \equiv μ \neq μ_0 & Si & t_ {exp} \geq t_{α/2;n-1} & \Rightarrow & Se \hspace{.2cm} rechaza \hspace{.2cm} H_0 \end{array} \)

Expresión 8: Contraste para \( H_1 \equiv \mu \neq \mu_0 \) y regla de decisión

b) Para la hipótesis alternativa \( H_1 \equiv \mu > \mu_0 \) la correspondiente región de no rechazo es \( ( -\infty, t_{\alpha;n-1}) \) y el estadístico de contraste es el mismo a). Se utiliza la siguiente regla de decisión

\( \begin{array}{ccccc} H_0 \equiv \mu \leq \mu_0 & Si & t_ {exp} < t_{α;n-1} & \Rightarrow & No \hspace{.2cm} se \hspace{.2cm} rechaza \hspace{.2cm} H_0 \\ H_1 \equiv μ > μ_0 & Si & t_ {exp} \geq t_{α;n-1} & \Rightarrow & Se \hspace{.2cm} rechaza \hspace{.2cm} H_0 \end{array} \)

Expresión 9: Contraste para \( H_1 \equiv μ > μ_0 \) y regla de decisión

c) Para la hipótesis alternativa \( H_1 \equiv μ < μ_0 \) la correspondiente región de no rechazo es \( (- t_{\alpha;n-1}, \infty,) \), el estadístico de contrate es el anterior y se adopta la siguiente regla de decisión

\( \begin{array}{ccccc} H_0 \equiv \mu \geq \mu_0 & Si & t_ {exp} > – t_{α;n-1} & \Rightarrow & No \hspace{.2cm} se \hspace{.2cm} rechaza \hspace{.2cm} H_0 \\ H_1 \equiv μ < μ_0 & Si & t_ {exp} \leq – t_{α;n-1} & \Rightarrow & Se \hspace{.2cm} rechaza \hspace{.2cm} H_0 \end{array} \)

Expresión 10: Contraste para \( H_1 \equiv \mu < \mu_0 \) y regla de decisión

La función de R t.test, la cual se introdujo en la práctica 5, resuelve contrastes de hipótesis en este contexto. Recordemos la sintaxis de esta función:

t.test(x, alternative, mu = 0, conf.level = 0.95)

donde

- x es un vector numérico con los valores de la muestra de la variable de interés

- alternative indica el tipo de la hipótesis alternativa del contraste. Los posibles valores son “two.sided” (hipótesis alternativa del tipo ≠, es la opción que se considera por defecto), “less” (hipótesis alternativa del tipo <) y “greater” (hipótesis alternativa del tipo >).

- mu es un valor numérico que se corresponde con el valor µ0 que se desea comprobar si es válido para la media de la variable. Si no se introduce ningún valor, se toma el valor 0 por defecto.

- level es un valor numérico que indica el nivel de confianza, en tanto por uno, al que se construirá el intervalo de confianza asociado al contraste. Si omitimos este parámetro en la llamada a la función, el intervalo de confianza se calcula a un nivel de confianza del 95%.

Veamos el funcionamiento de la función t.test mediante un ejemplo.

Supuesto Práctico 2

Considerando nuevamente el conjunto de datos que se ha presentado en el Supuesto práctico1, relativo al número de flexiones y el sexo de los alumnos. Contrastar a un nivel de significación del 2% la hipótesis de que el número medio de flexiones realizada por los alumnos es de 50. Suponer en este caso que el número de flexiones se distribuye según una normal de varianza desconocida. El fichero es Flexiones.txt.

Tabla1; Datos del Supuesto Práctico 1

En primer lugar, planteamos el contraste de hipótesis asociado a este supuesto

\( \begin{array}{c} H_0 \equiv \mu = 50 \\ H_1 \equiv μ \neq 50 \end{array} \)

Expresión 11: Contraste de hipótesis del supuesto práctico 2

Partiendo del conjunto de datos del supuesto 1, el cual se había importado y almacenado en una variable de nombre datos

En primer lugar, como hicimos anteriormente, debemos importar en R los datos que contienen el número de flexiones realizadas por cada alumno. Para ello, utilizamos la orden read.table.

> setwd(“C:/Users/Usuario/Desktop/Datos/”) # cambiar al directorio de trabajo donde están los datos

> datos<- read.table(“Flexiones.txt”, header = TRUE)

Una vez importado los datos, vamos a resolver este contraste. Para ello, basta con realizar la siguiente llamada a la función t.test:

> t.test(datos$Flexiones, alternative = “two.sided”, mu = 50, conf.level = 0.98)

One Sample t-test

data: datos$Flexiones

t = 0.15451, df = 74, p-value = 0.8776

alternative hypothesis: true mean is not equal to 50

98 percent confidence interval:

48.46512 51.74822

sample estimates:

mean of x

50.10667

Entre la información que devuelve la función t.test, encontramos la relativa al intervalo de confianza, que se estudió en la práctica 5. En esta práctica nos centraremos en la referente al contraste de hipótesis.

t = 0.15451, df = 74, p-value = 0.8776

alternative hypothesis: true mean isnotequal to 50

En primer lugar, aparece el valor del estadístico de contraste (0.15451) junto a los grados de libertad de la distribución t de Student (74) que sigue dicho estadístico de contraste. A continuación, encontramos el p-valor, que en este caso es 0.8776. Por último, el programa nos recuerda que la hipótesis alternativa que se está contrastando es del tipo ≠.

Teniendo en cuenta que el p-valor (0.8776) es superior al nivel de significación (0.02) en este ejemplo no podemos rechazar la hipótesis nula, por lo que podemos asumir que el número medio de flexiones que realizan los alumnos es de 50.

Contrastes de hipótesis para el parámetro p de una distribución Binomial

Supongamos que \( X \) es una variable aleatoria con distribución de probabilidad binomial con parámetro \( 1 \) y \( \pi \), \( X \rightarrow B(n, π) \), de la que se extrae una muestra aleatoria \( X_1, X_2, \cdots, X_n \) de tamaño \( n \). Sea \( p \) la proporción poblacional. Se desea contrastar si el parámetro \( \pi \) puede ser igual a un valor \( \pi_0 \), es decir se desea resolver uno de los siguientes contrastes

\( \begin{array}{|c|c|} \hline \text {Contraste bilateral} & \text {Contrastes unilaterales} \\ \hline H_0 \equiv \pi = \pi_0 & H_0 \equiv \pi \geq \pi_0 \hspace {2cm} H_0 \equiv \pi \leq \pi_0 \\ H_1 \equiv \pi \neq \pi_0 & H_1 \equiv \pi < \pi_0 \hspace {2cm} H_1 \equiv \pi > \pi_0 \\ \hline \end{array} \)

Expresión 12: Tipos de contrastes de hipótesis para la proporción

El contraste de hipótesis para el parámetro \( p \) (proporción de éxitos) de una distribución Binomial se basa en la distribución del estadístico muestral \( \pi \) para un tamaño muestral \( n \) suficientemente grande.

Denotando por \( \widehat {p} \) la proporción de éxitos de la muestra de una distribución Binomial, se verifica que

\( Z= \displaystyle \frac {\widehat{p}- \pi_0} { \displaystyle \sqrt { \displaystyle \frac { \widehat{p} (1- \widehat {p})} {n}}} \)

Expresión 13: Expresión del estadístico de contraste para el parámetro p de un distribución Binomial

sigue una distribución normal de media 0 y desviación típica 1 bajo la hipótesis nula.

a) Para la hipótesis alternativa \( H_1 \equiv \pi \neq \pi_0 \) la correspondiente región de no rechazo es \( (- z_{α/2}, z_{α/2}) \)

b) Para la hipótesis alternativa \( H_1 \equiv \pi > \pi_0 \) la correspondiente región de no rechazo es \( (-\infty , z_α) \)

c) Para la hipótesis alternativa \( H_1 \equiv \pi < \pi_0 \) la correspondiente región de no rechazo es \( (- z_α , \infty) \).

La función que resuelve contrastes de hipótesis para la proporción en R es prop.test. Sus argumentos son los siguientes

prop.test(x, n,p = NULL, alternative = c(“two.sided”, “less”, “greater”), conf.level = 0.95)

donde

- x es un valor numérico que indica el número de elementos del grupo que presentan la característica de interés

- n es un valor numérico que indica el número total de elementos del grupo

- p es un valor numérico que se corresponde con el valor π0 que se desea comprobar si es válido para la proporción

- alternative indica el tipo de la hipótesis alternativa del contraste. Los posibles valores son “two.sided” (hipótesis alternativa del tipo ≠ , es la opción que se considera por defecto), “less” (hipótesis alternativa del tipo <) y “greater” (hipótesis alternativa del tipo >).

- level es un valor numérico que indica el nivel de confianza, en tanto por uno, al que se construirá el intervalo de confianza asociado al contraste. Si omitimos este parámetro en la llamada a la función, el intervalo de confianza se calcula a un nivel de confianza del 95%.

Vamos a aplicar la función prop.test a los datos sobre las flexiones realizadas por los alumnos que hemos utilizado en los ejemplos anteriores.

Supuesto Práctico 3

Considerando nuevamente el conjunto de datos que se ha presentado en el Supuesto práctico1, relativo al número de flexiones y el sexo de los alumnos. Contrastar a un nivel de confianza del 95%, si la proporción de alumnos varones es mayor o igual que 0.5 frente a que dicha proporción es menor. El fichero es Flexiones.txt.

El contraste que debemos resolver es

\( \begin{array}{c} H_0 \equiv \pi_H \geq 0.5 \\ H_1 \equiv \pi_H < 0.5 \end{array} \)

Expresión 14: Contraste de hipótesis del Supuesto Práctico 3

Para realizar la llamada a la función prop.test necesitamos conocer el número de alumnos varones y el número total de estudiantes en la muestra. Para ello utilizamos la función de R table.

En primer lugar, omo hicimos anteriormente, debemos importar en R los datos que contienen el número de flexiones realizadas por cada alumno. Para ello, utilizamos la orden read.table.

> setwd(“C:/Users/Usuario/Desktop/Datos/”) # cambiar al directorio de trabajo donde están los datos

> datos<- read.table(“Flexiones.txt”, header = TRUE)

Una vez importado los datos, utilizamos la función de R table como hemos dicho anteriormente

> table(datos$Sexo)

H M

43 32

De los 75 estudiantes que conforman la muestra, 43 son chicos. Por lo que la llamada a prop.test sería la siguiente:

> prop.test(43, 75, p = 0.5, alternative = “less”, conf.level = 0.95)

1-sample proportions test with continuity correction

data: 43 out of 75, null probability 0.5

X-squared = 1.3333, df = 1, p-value = 0.8759

alternative hypothesis: true p is less than 0.5

95 percent confidence interval:

0.0000000 0.6693525

sample estimates:

p

0.5733333

De nuevo, los resultados de la función incluyen información sobre el intervalo de confianza y sobre el contraste de hipótesis. Nos centraremos en esta última.

X-squared = 1.3333, df = 1, p-value = 0.8759

alternativehypothesis: true p islessthan 0.5

El valor del estadístico de contraste es 1.3333, con un p-valor de 0.8759. Como el p-valor es mayor que el nivel de significación, que es 0.05, no rechazamos la hipótesis de que la proporción de alumnos es mayor o igual que 0.5.

Contrastes de hipótesis para la diferencias de medias de dos poblaciones normales e independientes

De un modo general, dos muestras se dice que son independientes cuando las observaciones de una de ellas no condicionan para nada a las observaciones de la otra, siendo dependientes en caso contrario. En realidad, el tipo de dependencia que se considera a estos efectos es muy especial: cada dato de una muestra tiene un homónimo en la otra, con el que está relacionada, de ahí el nombre alternativo de muestras apareadas. Por ejemplo, supongamos que se quiere estudiar el efecto de un medicamento, sobre la hipertensión, a un grupo de 20 individuos. El experimento se podría planificar de dos formas:

-

Aplicando el medicamento a 10 de estos individuos y dejando sin tratamiento al resto. Transcurrido un tiempo se miden las presiones sanguíneas de ambos grupos y se contrasta la hipótesis \( H_0: \mu_1 = \mu_2 \hspace{.2cm} vs \hspace{.2cm} H_1: \mu_1 \neq \mu_2 \) para evaluar si las medias son iguales o no. Como las muestras están formadas por individuos distintos sin relación entre sí, se dirá que son muestras independientes.

-

Aplicando el medicamento a los 20 individuos disponibles y anotando su presión sanguínea antes y después de la administración del mismo. En este caso los datos vienen dados por parejas, presión antes y después y tales datos están relacionados entre sí. Las muestras son apareadas.

Consideramos ahora dos variables aleatorias independientes \( X_1 \) y \( X_2 \) con distribuciones normales de parámetro \( (\mu_1, \sigma_1) \) y \( (\mu_2, \sigma_2) \) respectivamente, de las que vamos a tomar muestras aleatorias independientes de tamaños \( n_1 \) y \( n_2 \), respectivamente.

Nuestro objetivo, en este caso, es resolver un contraste de hipótesis para la diferencia de las medias de ambas distribuciones, es decir, para \( \mu_1 \) y \( \mu_2 \). Este contraste presentará alguna de las formas que se muestran a continuación

\( \left \lbrace \begin{array} {c} H_0 \equiv \mu_1 – \mu_2 = d_0 \\ H_1 \equiv \mu_1 – \mu_2 \neq d_0 \end {array}\right. \) \( \hspace{1cm} \left \lbrace \begin{array} {c} H_0 \equiv \mu_1 – \mu_2 \geq d_0 \\ H_1 \equiv \mu_1 – \mu_2 < d_0 \end {array}\right. \) \( \hspace{1cm} \left \lbrace \begin{array} {c} H_0 \equiv \mu_1 – \mu_2 \leq d_0 \\ H_1 \equiv \mu_1 – \mu_2 > d_0 \end {array}\right. \)

Expresión 15: Contraste de hipótesis para la diferencia de medias

Pero antes de la resolución del contraste, debemos determinar si las varianzas de ambas distribuciones o, equivalentemente, sus desviaciones típicas, \( \sigma_1 \) y \( \sigma_2 \), aun siendo desconocidas, pueden asumirse iguales o no. La resolución del contraste de hipótesis sobre las medias se realiza de forma diferente dependiendo de las varianzas.

Para decidir si las varianzas de las dos distribuciones pueden asumirse iguales o no plantearemos y resolveremos el siguiente contraste de hipótesis:

\( \begin{array}{c} H_0 \equiv \sigma_{1}^{2} = \sigma_{2}^{2} \\ H_1 \equiv \sigma_{1}^{2} \neq \sigma_{2}^{2} \end{array} \)

Expresión 16: Contraste de hipótesis para la igualdad de varianzas

Para resolver este contraste, partimos del estadístico de contraste

\( F= \displaystyle \frac {s_{1}^{2}} {s_{2}^{2}} \)

Expresión 17: Estadístico de contraste para comparar dos varianzas de dos distribuciones normales e independientes

que sigue una distribución F de Snedecor con \( n_1-1 \) grados de libertad en el numerador y \( n_2-1 \) grados de libertad en el denominador cuando la hipótesis nula del contraste es cierta. Los valores \( s_{1}^{2} \) y \( s_{2}^{2} \) en la expresión anterior hacen referencia a las cuasivarianzas muestrales de la variable en el primer y el segundo grupo, respectivamente. En R, la función var.test se encarga de resolver este contraste. Sus parámetros son los siguientes:

var.test(x, y, alternative = c(“two.sided”, “less”, “greater”), conf.level = 0.95)

siendo

- x un vector numérico con los datos de la variable de interés en el primer grupo o muestra

- y un vector numérico con los datos de la variable de interés en el segundo grupo o muestra

- alternative indica el tipo de la hipótesis alternativa del contraste. Los posibles valores son “two.sided” (hipótesis alternativa del tipo \( \neq \), es la opción que se considera por defecto), “less” (hipótesis alternativa del tipo <) y “greater” (hipótesis alternativa del tipo >).

- level un valor numérico que indica el nivel de confianza, en tanto por uno, al que se construirá el intervalo de confianza asociado al contraste. Si omitimos este parámetro en la llamada a la función, el intervalo de confianza se calcula a un nivel de confianza del 95%.

Supuesto Práctico 4

Continuando con los datos relativos a las flexiones realizadas por un grupo de estudiantes y asumiendo que las flexiones que realizan los chicos y las que realizan las chicas se distribuyen según sendas distribuciones normales con medias y varianzas desconocidas, contrastar a un nivel de significación del 5% si las varianzas poblacionales de ambas distribuciones pueden asumirse iguales.

El contraste de hipótesis que debemos resolver es

\( \left \lbrace \begin{array}{c} H_0 \equiv \sigma_{H}^{2} = \sigma_{M}^{2} \\ H_1 \equiv \sigma_{H}^{2} \neq \sigma_{M}^{2} \end{array} \right. \)

Expresión 18: Contraste de hipótesis sobre las varianzas del Supuesto Práctico 3

donde \( \sigma_{H}^{2} \) representa la varianza del número de flexiones realizadas por los chicos \( \sigma_{M}^{2} \) y representa la varianza del número de flexiones realizadas por las chicas.

Lo primero que tenemos que hacer para aplicar la función var.test es separar en dos variables los datos relativos a las flexiones realizadas por los chicos y por las chicas.

> Flexiones.chicos<- datos$Flexiones[datos$Sexo == “H”]

> Flexiones.chicas<- datos$Flexiones[datos$Sexo == “M”]

A continuación, utilizamos la función var.test

> var.test(Flexiones.chicos, Flexiones.chicas, alternative = “two.sided”, conf.level = 0.95)

F test to compare two variances

data: Flexiones.chicos and Flexiones.chicas

F = 0.87506, num df = 42, denom df = 31, p-value = 0.679

alternative hypothesis: true ratio of variances is not equal to 1

95 percent confidence interval:

0.4415454 1.6765483

sample estimates:

ratio of variances

0.8750585

Analizando la información relativa al contraste de hipótesis que se incluye en la salida de var.test, vemos que el valor del estadístico de contraste es 0.87506. La distribución F de Snedecor que sigue el estadístico de contraste tiene 42 grados de libertad en el numerador y 31 en el denominador. El p-valor asociado al contraste es 0.679. Como este valor es superior al nivel de significación (que para este ejemplo es 0.05), no podemos rechazar la hipótesis nula que hemos planteado. Es decir, se puede considerar que la varianza del número de flexiones realizadas por chicos y la varianza del número de flexiones realizadas por chicas son iguales.

Una vez se ha determinado la igualdad (o desigualdad) de las varianzas de ambas distribuciones, procedemos a plantear y a resolver el contraste de hipótesis para la diferencia de las medias propiamente dicho.

a) Si las varianzas se han supuesto iguales, se parte del estadístico de contraste

\( T= \displaystyle \frac{ ( \overline {X}_1 – \overline {X}_2) }{ \displaystyle \sqrt { \displaystyle \frac {(n_{1}-1) s_{1}^{2}+ (n_{2}-1) s_{2}^{2}} {n_{1 } – n_{2} – 2 } } \displaystyle \sqrt { \displaystyle \frac{1}{n_{1}} + \displaystyle \frac{1}{n_{2}}} } \)

Expresión 19:Estadistico de contraste para la diferencia de medias de dos problaciones con varianzas iguales

Que se distribuye según una t de Student con \( n_1 + n_2 -2 \) grados de libertad cuando la hipótesis nula es cierta

b) Si las varianzas se han supuesto distintas, el estadístico de contraste de partida es

\( T= \displaystyle \frac{ ( \overline {X}_1 – \overline {X}_2) }{ \displaystyle \sqrt { \displaystyle \frac {s_{1}^{2}} {n_{1} } + \displaystyle \frac {s_{2}^{2}} {n_{2} } } } \)

Expresión 20: Estadistico de contraste para la diferencia de medias de dos problaciones con varianzas supuestas distintas

Que se distribuye, bajo la hipótesis nula, según una distribución t de Student con f grados de libertad, siendo f el entero más próximo a

\( \displaystyle \frac{\left ( \displaystyle \frac {s_2^{2}}{n_1} + \displaystyle \frac {s_2^{2}} {n_2} \right )^{2} } { \displaystyle \frac { \left ( \displaystyle \frac {s_1^{2}} { n_1} \right ) ^{2} } {n_{1}-1 } + \displaystyle \frac { \left ( \displaystyle \frac { s_2^{2}} { n_2} \right )^{2}} { n_2-{1}} } \)

Expresión 21: Expresión para el cálculo de los grados de libertad f

En ambos casos se utiliza la función t.test (que fue introducida y utilizada con anterioridad).Los parámetros de t.test presentan algunos cambios cuando la función se utiliza en un contexto de dos poblaciones:

t.test (x, y, alternative = c(“two.sided”, “less”, “greater”), mu = 0, var.equal = FALSE, conf.level = 0.95)

En este caso:

- x es un vector numérico que incluye los valores de la variable de interés en el primer grupo o muestra

- y es un vector numérico que incluye los datos de la variable de interés en el segundo grupo o muestra

- alternative indica el tipo de la hipótesis alternativa del contraste. Los posibles valores son “two.sided” (hipótesis alternativa del tipo \( \neq \), es la opción que se considera por defecto), “less” (hipótesis alternativa del tipo <) y “greater” (hipótesis alternativa del tipo >)

- mu es un valor numérico que se corresponde con el valor que se desea comprobar si es válido para la diferencia de las medias de la variables

- equal es un argumento lógico que indica si las varianzas de la variable en los dos grupos o muestras puede suponerse igual o no. Para establecer el valor de este parámetro nos basamos en la interpretación del contraste de hipótesis que proporciona la función var.test. Por defecto, la función considera que las varianzas en los dos grupos son distintas

- level un valor numérico que indica el nivel de confianza, en tanto por uno, al que se construirá el intervalo de confianza asociado al contraste. Si omitimos este parámetro en la llamada a la función, el intervalo de confianza se calcula a un nivel de confianza del 95%.

Supuesto Práctico 5

En vista de los resultados obtenidos en el Supuesto Práctico 4, y suponiendo que el número de flexiones que realizan los alumnos y las alumnas se distribuyen de acuerdo a variables normales de medias y varianzas desconocidas, ¿puede suponerse, a un nivel de significación del 5%, que el número medio de flexiones que realizan los chicos y las chicas es igual?

El contraste que debemos resolver en esta ocasión es

\( \left \lbrace \begin{array}{c} H_0 \equiv \mu_H = \mu_M \\ H_1 \equiv μ_H \neq μ_M \end{array} \right. \) \( \hspace{1cm} \text{o} \hspace{1cm} \left \lbrace \begin{array}{c} H_0 \equiv μ_H – μ_M = 0 \\ H_1 \equiv μ_H – μ_M \neq 0 \end{array} \right. \)

Expresión 22: Contraste de hipótesis para la diferencia de medias de dos poblaciones normales independientes

En ambos casos \( \mu_H \), representa la media poblacional del número de flexiones realizadas por chicos y \( \mu_M \) es la media poblacional del número de flexiones realizadas por las chicas.

Dado que en el Supuesto práctico 4 se concluyó la igualdad de las varianzas del número de flexiones que hacen chicos y chicas, debemos establecer a TRUE el valor del parámetro var.equal cuando realicemos la llamada a la función t.test.

> setwd(“C:/Users/Usuario/Desktop/Datos/”) # cambiar al directorio de trabajo donde están los datos

> datos<- read.table(“Flexiones.txt”, header = TRUE)

> Flexiones.chicos<- datos$Flexiones[datos$Sexo == “H”]

> Flexiones.chicas<- datos$Flexiones[datos$Sexo == “M”]

> t.test(Flexiones.chicos, Flexiones.chicas, alternative = “two.sided”, mu = 0, var.equal = TRUE)

Two Sample t-test

data: Flexiones.chicos and Flexiones.chicas

t = -0.06154, df = 73, p-value = 0.9511

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

-2.887271 2.714306

sample estimates:

mean of x mean of y

50.06977 50.15625

Entre la información sobre el contraste de hipótesis que se incluye entre los resultados

data: Flexiones.chicos and Flexiones.chicas

t = -0.06154, df = 73, p-value = 0.9511

alternativehypothesis: true difference in meansisnotequal to 0

se incluye el valor del estadístico de contraste (-0.06154), los grados de libertad de la distribución t de Student que sigue el estadístico de contraste (73) y el p-valor (0.9511). Como el p-valor es mayor que el nivel de significación fijado (0.05), no rechazamos la hipótesis nula del contraste.

Contrastes de hipótesis para la diferencia de medias de dos poblaciones normales relacionadas

Sean \( X_1, X_2, \cdots, X_n \) e \( Y_1, Y_2, \cdots, Y_n \) dos muestras aleatorias de tamaño n y relacionadas, de tal forma que la primera procede de una población \( N ( \mu_1, \sigma_1) \) y la segunda de una población \( N ( \mu_2, \sigma_2) \).

Antes de plantear y resolver el contraste de hipótesis para la diferencia de medias de estas dos poblaciones, se hace necesario indicar qué se entiende por muestras relacionadas. Se dice que dos muestras \( X_1, X_2, \cdots, X_n \) e \( Y_1, Y_2, \cdots, Y_n \) están relacionadas o apareadas cuando los datos de las muestras vienen por parejas, uno de cada una de ellas, de manera que cada individuo proporciona dos observaciones. El contraste que debemos resolver será alguno de los siguientes:

\( \left \{ \begin{array}{c} H_0 \equiv \mu_1 – \mu_2 = d_0 \\ H_1 \equiv μ_1 – μ_2 \neq d_0 \end{array}\right. \) \( \hspace {2cm} \left \{ \begin{array}{c} H_0 \equiv \mu_1 – \mu_2 \geq d_0 \\ H_1 \equiv μ_1 – μ_2 < d_0 \end{array}\right. \) \( \hspace {2cm} \left \{ \begin{array}{c} H_0 \equiv \mu_1 – \mu_2 \leq d_0 \\ H_1 \equiv μ_1 – μ_2 > d_0 \end{array}\right. \)

Expresión 23: Contraste de hipótesis para la diferencia de medias dos poblaciones normales relacionadas

En los casos de muestras relacionadas, se utiliza nuevamente la función t.test para la resolución de contrastes de hipótesis, pero se ha de indicar que los datos que reciben como parámetros provienen de muestras relacionadas incluyendo en la llamada a la función el argumento lógico paired, cuyo valor debe establecerse a TRUE.

t.test (x, y, alternative = c(“two.sided”, “less”, “greater”), mu = 0, paired = TRUE, conf.level = 0.95)

Supuesto Práctico 6

Para estudiar los efectos de un programa de control de peso, el profesor de educación física selecciona aleatoriamente a 6 alumnos y se les toma nota de sus pesos antes y después de pasar por el programa.

\( \begin{array}{||c|c|c|c|c|c|c||} \hline \text {Antes} & 72.0 & 73.5 & 70.0 & 71.5 & 76.0 & 80.5 \\ \hline \text {Después} & 73.0 & 74.5 & 74.0 & 74.5 & 75.0 & 80.2 \\ \hline \end{array} \)

Tabla2; Datos del Supuesto Práctico 6

¿Puede suponerse, a un nivel de significación del 5%, que el programa para el control de peso es efectivo? O, dicho de otra forma, ¿el peso medio de los alumnos antes de someterse al programa es igual al peso medio tras el programa?

El contraste de hipótesis que debemos resolver es el siguiente:

\( \left \{ \begin{array}{c} H_0 \equiv \mu_a = \mu_d \\ H_1 \equiv μ_a \neq μ_d \end{array}\right. \)

Expresión 24: Contraste de hipótesis para el Supuesto práctico 6

donde \( \mu_a \) y \( \mu_d \) hacen referencia al peso medio poblacional antes y después de pasar por el programa de control de peso, respectivamente.

Como puede observarse, los datos vienen por parejas: peso antes y después, dos datos por individuo. Parece lógico que los datos se encuentren relacionados entre sí.

En primer lugar, vamos a introducir los datos en R.

> Antes <- c(72.0, 73.5, 70.0, 71.5, 76.0, 80.5)

> Despues<- c(73.0, 74.5, 74.0, 74.5, 75.0, 82.0)

A partir de estos datos, vamos a aplicar la función t.test, para resolver el contraste de hipótesis que hemos planteado.

> t.test(Antes, Despues, alternative = “two.sided”, mu = 0, paired = TRUE)

Paired t-test

data: Antes and Despues

t = -2.2238, df = 5, p-value = 0.07676

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

-3.4135884 0.2469217

sample estimates:

mean of the differences

-1.583333

Según los datos que se incluyen en la salida de la función, el estadístico de contraste toma un valor de -2.2238 y sigue una distribución t de Student con 5 grados de libertad. El p-valor asociado al contraste es 0.07676. Como este p-valor es mayor que 0.05, que es el nivel de significación del contraste, podemos afirmar que la diferencia entre los pesos medios de los alumnos antes y después de seguir el programa de control de peso es nula o, equivalentemente, que ambos pesos medios pueden suponerse iguales.

Contrastes de hipótesis para la diferencia de proporciones

Consideremos dos muestras aleatorias \( X_1, X_2, \cdots, X_{n1} \) e \( Y_1, Y_2, \cdots, Y_{n2} \) de tamaños \( n1 \) y \( n2 \) independientes entre sí, extraídas de poblaciones con distribuciones binomiales \( B (n1, \pi_1) \) y \( B (n2, \pi_2 ) \), respectivamente. Pretendemos resolver alguno de los siguientes contrastes de hipótesis:

\( \left \{ \begin{array}{c} H_0 \equiv \pi_1 – \pi_2 = \delta_0 \\ H_1 \equiv \pi_1 – \pi_2 \neq \delta_0 \end{array}\right. \) \( \hspace {2cm} \left \{ \begin{array}{c} H_0 \equiv \pi_1 – \pi_2 \geq \delta_0 \\ H_1 \equiv \pi_1 – \pi_2 < \delta_0 \end{array}\right. \) \( \hspace {2cm} \left \{ \begin{array}{c} H_0 \equiv \pi_1 – \pi_2 \leq \delta_0 \\ H_1 \equiv \pi_1 – \pi_2 > \delta_0 \end{array}\right. \)

Expresión 25: Contraste de hipótesis para la diferencia de proporciones

Para ello, partimos del estadístico de contraste

\( Z = \displaystyle \frac { (\widehat{p}_1- \widehat{p}_2) – \delta_0} { \displaystyle \sqrt { \displaystyle \frac {\widehat{p}_1(1- \widehat{p}_1) } {n_1} + \displaystyle \frac { \widehat{p}_2 (1- \widehat{p}_2)} {n_2} } } \)

Expresión 26: Estadístico de contraste para la diferencia de proporciones

con \( \widehat{p}_1 \) y \( \widehat{p}_2 \) las proporciones de individuos que presentan la característica de interés en la primera y la segunda muestra, respectivamente. Este estadístico de contraste sigue una distribución normal de media 0 y desviación típica 1 cuando la hipótesis nula del contraste en cuestión es cierta.

Para resolver este contraste en R utilizaremos de nuevo la función prop.test, pero teniendo en cuenta que ahora contamos con dos muestras en lugar de con una. Esto afecta (mínimamente) a la manera de definir los parámetros. La sintaxis de la función en este caso es:

prop.test(x, n, alternative = c(“two.sided”, “less”, “greater”), conf.level = 0.95)

Pero ahora

- x es un vector de dimensión 2 que indica el número de elementos en cada grupo que presentan la característica de interés

- n es un vector numérico de dimensión 2 que indica el número total de elementos del grupo

- alternative indica el tipo de la hipótesis alternativa del contraste. Los posibles valores son “two.sided” (hipótesis alternativa del tipo \( \neq \), es la opción que se considera por defecto), “less” (hipótesis alternativa del tipo <) y “greater” (hipótesis alternativa del tipo >).

- conf.level sigue siendo un valor numérico que indica el nivel de confianza, en tanto por uno, al que se construirá el intervalo de confianza asociado al contraste. Si omitimos este parámetro en la llamada a la función, el intervalo de confianza se calcula a un nivel de confianza del 95%.

Supuesto Práctico 7

Retomando el conjunto de datos relativo a las flexiones que realizan un grupo de estudiantes, contrastar, a un nivel de significación del 8% si la proporción de alumnos y de alumnas que practican deporte pueden considerarse iguales.

El contraste que vamos a resolver es

\( \left \{ \begin{array}{c} H_0 \equiv \pi_H – \pi_M = 0 \\ H_1 \equiv \pi_H – \pi_M \neq 0 \end{array}\right. \)

Expresión 27: Contraste de hipótesis para el Supuesto práctico 7

donde \( \pi_H \) y \( \pi_M \) representan la proporciones de chicos y chicas que practican deporte, respectivamente.

En primer lugar, utilicemos el comando table para determinar cuántos chicos y cuantas chicas practican deporte.

> table(datos$Sexo, datos$Deporte)

0 1

H 32 11

M 13 19

En total, 11 de los 43 y 19 de las 32 chicas muestreados practican deporte fuera del horario escolar. Vamos a crear dos vectores con esta información: en uno indicaremos el total de chicos y chicas que practican deporte y en el otro el total de chicos y chicas en la muestra.

> vector_Deporte<- c(11, 19)

> vector_Sexo<- c(43, 32)

Es muy importante que los valores se introduzcan en el mismo orden en los dos vectores. Ahora ya podemos utilizar la función prop.test utilizando estos dos vectores como argumentos.

> prop.test(vector_Deporte, vector_Sexo, alternative = “two.sided”, conf.level = 0.92)

2-sample test for equality of proportions with continuity correction

data: vector_Deporte out of vector_Sexo

X-squared = 7.3787, df = 1, p-value = 0.0066

alternative hypothesis: two.sided

92 percent confidence interval:

-0.5566881 -0.1191840

sample estimates:

prop 1 prop 2

0.255814 0.593750

Según la salida de la función prop.test, el p-valor asociado al contraste es 0.0066, que al ser menor que el nivel de significación (0.08), nos lleva a concluir que las proporciones de chicos y chicas que hacen deporte no coinciden.

Contrastes de hipótesis no paramétricos

En la sesión anterior hemos estudiado contrastes de hipótesis acerca de parámetros poblacionales, tales como la media y la varianza, de ahí el nombre de contrastes paramétricos. En estadística paramétrica se trabaja bajo el supuesto de que las poblaciones poseen distribuciones conocidas, donde cada función de distribución teórica depende de uno o más parámetros poblacionales. Sin embargo, en muchas situaciones, es imposible especificar la forma de la distribución poblacional. El proceso de obtener conclusiones directamente de las observaciones muestrales, sin formar los supuestos con respecto a la forma matemática de la distribución poblacional se llama teoría no paramétrica.

En esta sesión vamos a realizar procedimientos que no exigen ningún supuesto, o muy pocos acerca de la familia de distribuciones a la que pertenece la población, y cuyas observaciones pueden ser cualitativas o bien se refieren a alguna característica ordenable. En estos casos, cuando no se dispone de información acerca de qué distribución de probabilidad sigue la variable a nivel poblacional, se pueden utilizar técnicas estadísticas no paramétricas para el planteamiento y resolución de contrastes de hipótesis no paramétricos. .Estas técnicas se basan exclusivamente en la información que se recoge en la muestra para resolver los contrastes.

Así, uno de los objetivos de esta sesión es el estudio de contrates de hipótesis para determinar si una población tiene una distribución teórica específica. La técnica que nos introduce a estudiar esas cuestiones se llama Contraste de la Chi-cuadrado para la Bondad de Ajuste. Una variación de este contraste se emplea para resolver los Contrastes de Independencia. Tales contrastes pueden utilizarse para determinar si dos características (por ejemplo preferencia política e ingresos) están relacionadas o son independientes. Y, por último estudiaremos otra variación del contraste de la bondad de ajuste llamado Contraste de Homogeneidad. Tal contraste se utiliza para estudiar si diferentes poblaciones, son similares (u homogéneas) con respecto a alguna característica. Por ejemplo, queremos saber si las proporciones de votantes que favorecen al candidato A, al candidato B o los que se abstuvieron son las mismas en dos ciudades.

El procedimiento Prueba de la Chi-cuadrado

Hemos agrupado los procedimientos en los que el denominador común a todos ellos es que su tratamiento estadístico se aborda mediante la distribución Chi-cuadrado. El procedimiento Prueba de Chi-cuadrado tabula una variable en categorías y calcula un estadístico de Chi-cuadrado. Esta prueba compara las frecuencias observadas y esperadas en cada categoría para contrastar si todas las categorías contienen la misma proporción de valores o si cada categoría contiene una proporción de valores especificada por el usuario.

Contraste de hipótesis no paramétrico para la independencia de los valores de una variable cualitativa

Supongamos que se dispone de información sobre una variable cualitativa, X, y se quiere comprobar si todas las categorías de la variable aparecen por igual. Es decir, se pretende comprobar si las categorías de la variable son independientes o no. El contraste de hipótesis que se debe resolver es el siguiente:

\( H_0 \equiv \hspace{.2cm} \) Las categorías de la variable X aparecen igual

\( H_1 \equiv \hspace{.2cm} \) Las categorías de la variable X no aparecen igual

Para resolver este contraste en R se utiliza la función chisq.test (que ya se presentó en la práctica 3). Los argumentos de esta función son:

chisq.test(x, p = rep(1/length(x), length(x)))

donde

- x es un vector que recoge las frecuencias con las que aparece cada categoría de la variable.

- p es un vector, de la misma dimensión que x, que recoge las proporciones que se quieren probar para cada categoría de la variable. Por defecto, se contrasta si todos los valores de la variable aparecen en la misma proporción.

Supuesto Práctico 8

La directora de un hospital quiere comprobar si los ingresos en el hospital se producen en la misma proporción durante todos los días de la semana. Para ello, se anota el número de ingresos durante una semana cualquiera. Los datos se recogen en la siguiente tabla:

\( \begin{array}{||c|c||} \hline \text {Día de la semana} & \text {Número de ingresos } \\ \hline \text {Lunes} & 78 \\ \hline \text {Martes} & 90 \\ \hline \text {Miércoles} & 94 \\ \hline \text {Jueves} & 89 \\ \hline \text {Viernes} & 110 \\ \hline \text {Sábado} & 84 \\ \hline \text {Domingo} & 44 \\ \hline \end{array} \)

Tabla 3: Datos del Supuesto Práctico 8

Contrastar, a un nivel de significación del 5%, si la hipótesis de la directora del hospital puede suponerse cierta. ¿Puede asumirse que las proporciones de ingresos de lunes a domingo son (0.15, 0.15, 0.15, 0.15, 0.20, 0.15, 0.05)?

Solución

En primer lugar vamos a introducir los datos en R.

> frecuencias <- c(78, 90, 94, 89, 110, 84, 44)

El contraste que se debe resolver es:

\( H_0 \equiv \hspace{.2cm} \) Los ingresos en el hospital se producen en la misma proporción todos los días de la semana

\( H_1 \equiv \hspace{.2cm} \) Los ingresos en el hospital no se producen en la misma proporción todos los días de la semana

Para resolver este contraste se usa la función chisq.test.

> chisq.test(frecuencias)

Chi-squared test for given probabilities

data: frecuencias

X-squared = 29.389, df = 6, p-value = 5.135e-05

El estadístico de contraste, que sigue una distribución chi-cuadrado, toma el valor 29.389. Los grados de libertad de la distribución chi-cuadrado para este ejemplo son 6. El p-valor asociado al contraste es menor que 0.05 por lo que, considerando un nivel de significación del 5%, se rechaza la hipótesis nula. Es decir, se concluye que los ingresos hospitalarios no se producen en la misma proporción todos los días de la semana.

Para comprobar si el vector (0.15, 0.15, 0.15, 0.15, 0.20, 0.15, 0.05) puede considerarse como el vector de proporciones de ingresos hospitalarios durante los 7 días de la semana, creamos un vector en R que recoja estos valores:

> proporciones <- c(0.15, 0.15, 0.15, 0.15, 0.20, 0.15, 0.05)

Volvemos a llamar a la función chisq.test incluyendo como argumento el vector que acabamos de definir.

> chisq.test(frecuencias, p = proporciones)

Chi-squared test for given probabilities

data: frecuencias

X-squared = 9.5286, df = 6, p-value = 0.146

En este caso, el valor del estadístico de contraste es 9.5286. El p-valor asociado es 0.146 que, al ser superior a 0.05, nos indica que no se puede rechazar la hipótesis nula. Esto equivale a decir que, a un nivel de significación del 5%, puede suponerse que los ingresos hospitalarios se producen según los valores que se recogen en el vector proporciones.

Supuesto Práctico 9

Lanzamos un dado 720 veces y obtenemos los resultados que se muestran en la tabla.

\( \begin{array}{||c|c|c|c|c|c|c||} \hline x_i & 1 & 2 & 3 & 4 & 5 & 6 \\ \hline n_i & 116 & 120 & 115 & 120 & 125 & 124 \\ \hline \end{array} \)

Tabla 4: Datos del Supuesto Práctico 9

Contrastar la hipótesis de que el dado está bien construido.

Solución

Comencemos introduciendo en R las frecuencias con las que aparecen los valores del dado.

> frecuencias <- c(116, 120, 115, 120, 125, 124)

Que el dado esté bien construido equivale a decir que todos sus valores aparecen en la misma proporción. Por tanto, el contraste de hipótesis que se debe resolver es el siguiente:

\( H_0 \equiv \hspace{.2cm} \) Los valores del dado aparecen en la misma proporción

\( H_1 \equiv \hspace{.2cm} \) Los valores del dado no aparecen en la misma proporción

Para resolver este contraste de hipótesis se utiliza la función chisq.test, que recibe como argumento el vector de frecuencias.

> chisq.test(frecuencias)

Chi-squared test for given probabilities

data: frecuencias

X-squared = 0.68333, df = 5, p-value = 0.9839

El valor del estadístico de contraste es 0.68333 y el p-valor asociado es igual a 0.984. Como este p-valor es superior a 0.05 no se puede rechazar la hipótesis nula por lo que, a un nivel de significación del 5%, concluimos que todos los valores del dado aparecen en la misma proporción. Dicho de otra forma, el dado está bien construido.

Contraste de hipótesis no parametricos para la independencia de dos variables cualitativas

Supongamos que se dispone de datos de dos variables cualitativas, X e Y, y se quiere comprobar si los valores que toma una de ellas dependen en cierta medida de los valores que toma la otra. En tal caso, se dice que las variables X e Y son dependientes. Para comprobar la dependencia (o, equivalentemente, la independencia) de X e Y se debe resolver el siguiente contraste de hipótesis

\( H_0 \equiv \hspace{.2cm} \) X e Y son variables independientes

\( H_1 \equiv \hspace{.2cm} \) X e Y no son variables independientes (son dependientes)

En R se usa el comando chisq.test para resolver este tipo de contrastes. Dicho comando tiene los siguientes argumentos:

chisq.test (x, correct = TRUE)

donde

- x es el nombre de la tabla de doble entrada (a la cual se suele denominar tabla de contingencia, como se verá en el apéndice de esta misma práctica) para las dos variables cualitativas

- correct es un argumento lógico que indica si es necesaria una corrección por continuidad (que se denomina corrección por continuidad de Yates) a la hora de calcular el estadístico de contraste. Si se realiza esta corrección, el estadístico de contraste que se calcula es el siguiente:

\( \chi^{2}_{corr} = \displaystyle \sum_{i=1}^{k} \displaystyle \sum_{j=1}^{p} \displaystyle \frac { (| n_{ij} – e_ {íj} | – 0.5)^{2}} {e_{ij}} \)

Expresión 28: Estadístico de contraste con corrección por continuidad de Yates

El objetivo de esta corrección es que el estadístico \( \chi^{2}_{corr} \) ajuste mejor a la distribución teórica correspondiente, especialmente en muestras pequeñas.

Por defecto, este argumento toma el valor TRUE, por lo que la corrección por continuidad de Yates se hace de forma automática, de modo que si queremos calcular el valor del estadístico de contraste sin ningún tipo de modificación, debemos asignar a este parámetro el valor FALSE.

Supuesto Práctico 10

La siguiente tabla muestra información sobre el número de ejemplares de 7 especies de peces avistados aguas arriba y aguas abajo en un río.

\( \begin{array}{||c|cc||} \hline & \hspace{3cm} \text{ Zona} & \\ \hline & \text{Aguas arriba } & \text{Aguas abajo} \\ \hline \text{Especie A} & 37 & 19 \\ \hline \text{Especie B} & 12 & 10 \\ \hline \text{Especie C} & 10 & 7 \\ \hline \text{Especie D} & 18 & 20 \\ \hline \text{Especie E} & 11 & 8 \\ \hline \text{Especie F} & 16 & 12 \\ \hline \text{Especie G} & 59 & 24 \\ \hline \end{array} \)

Tabla5; Datos del Supuesto Práctico 10

Contrastar, a un nivel de significación del 5%, si la especie de pez y la zona de avistamiento pueden considerarse variables independientes.

Solución

En primer lugar, introduzcamos en R los datos que proporciona el enunciado y construyamos la tabla de contingencia.

> frecuencias <- c(37, 19, 12, 10, 10, 7, 18, 20, 11, 8, 16, 12, 59, 24)

> tabla_conting <- matrix (frecuencias, 7, 2, byrow = TRUE, dimnames = list(c(“A”, “B”, “C”, “D”, “E”, “F”, “G”), c(“Aguas_Arriba”, “Aguas_abajo”)))

> tabla_conting

Aguas_Arriba Aguas_abajo

A 37 19

B 12 10

C 10 7

D 18 20

E 11 8

F 16 12

G 59 24

El contraste de hipótesis que se debe resolver es:

\( H_0 \equiv \hspace{.2cm} \) La especie y la zona de avistamiento son independientes

\( H_1 \equiv \hspace{.2cm} \) La especie y la zona de avistamiento no son independientes

A continuación, usaremos la función chisq.test (sin aplicar la corrección por continuidad) para resolver el contraste.

> chisq.test(tabla_conting, correct = FALSE)

Pearson’s Chi-squared test

data: tabla_conting

X-squared = 7.7604, df = 6, p-value = 0.2562

El estadístico de contraste, que sigue una distribución chi-cuadrado con 6 grados de libertad, toma el valor 7.7604. El p-valor asociado al contraste es 0.2562. Como este p-valor es mayor que 0.05, no podemos rechazar la hipótesis nula por lo que concluimos que la especie y la zona de avistamiento son variables independientes. Esto es, para cada especie, se observan el mismo número de peces aguas arriba y aguas abajo en el río.

Supuesto Práctico 11

Se realiza una investigación para determinar si hay alguna asociación entre el peso de un estudiante y un éxito precoz en la escuela. Se selecciona una muestra de 50 estudiantes y se clasifica a cada uno según dos criterios, el peso y el éxito en la escuela. Los datos se muestran en la tabla adjunta

\( \begin{array}{||c|c|c||} \hline \text {Éxito}/\text {Sobrepeso} & \text { SI} & \text {NO} \\ \hline \text {SI} & 162 & 263 \\ \hline \text {NO} & 38 & 37 \\ \hline \end{array} \)

Tabla 6; Datos del Supuesto Práctico 11

Contrastar, a un nivel de significación del 5%, si las dos variables estudiadas están relacionadas o si, por el contrario, son independientes.

Solución

Introducimos los datos en R

> frecuencias <- c(162, 263, 38, 37)

> tabla_conting <- matrix (frecuencias, 2, 2, byrow = TRUE, dimnames = list(c(“Exito = Sí”, “Exito = No”), c(“Sobrepeso = Sí”, “Sobrepeso = No”)))

> tabla_conting

Sobrepeso = Sí Sobrepeso = No

Exito = Sí 162 263

Exito = No 38 37

El contraste de hipótesis que se debe resolver es:

\( H_0 \equiv \hspace{.2cm} \) El exito en la escuela y el sobrepeso son independientes

\( H_1 \equiv \hspace{.2cm} \) El exito en la escuela y el sobrepeso no son independientes

Vamos a resolver el contraste usando la función chisq.test (sin aplicar la corrección por continuidad).

> chisq.test(tabla_conting, correct = FALSE)

Pearson’s Chi-squared test

data: tabla_conting

X-squared = 4.183, df = 1, p-value = 0.04083

El p-valor asociado a este contraste es 0.04083. Como este p-valor es menor que 0.05, se rechaza la hipótesis nula del contraste, por lo que concluimos que el éxito escolar y el sobrepeso son variables dependientes. Esto es, los valores de una dependen de los valores de la otra.